数据集成平台是什么?一文看懂数据集成平台架构全流程

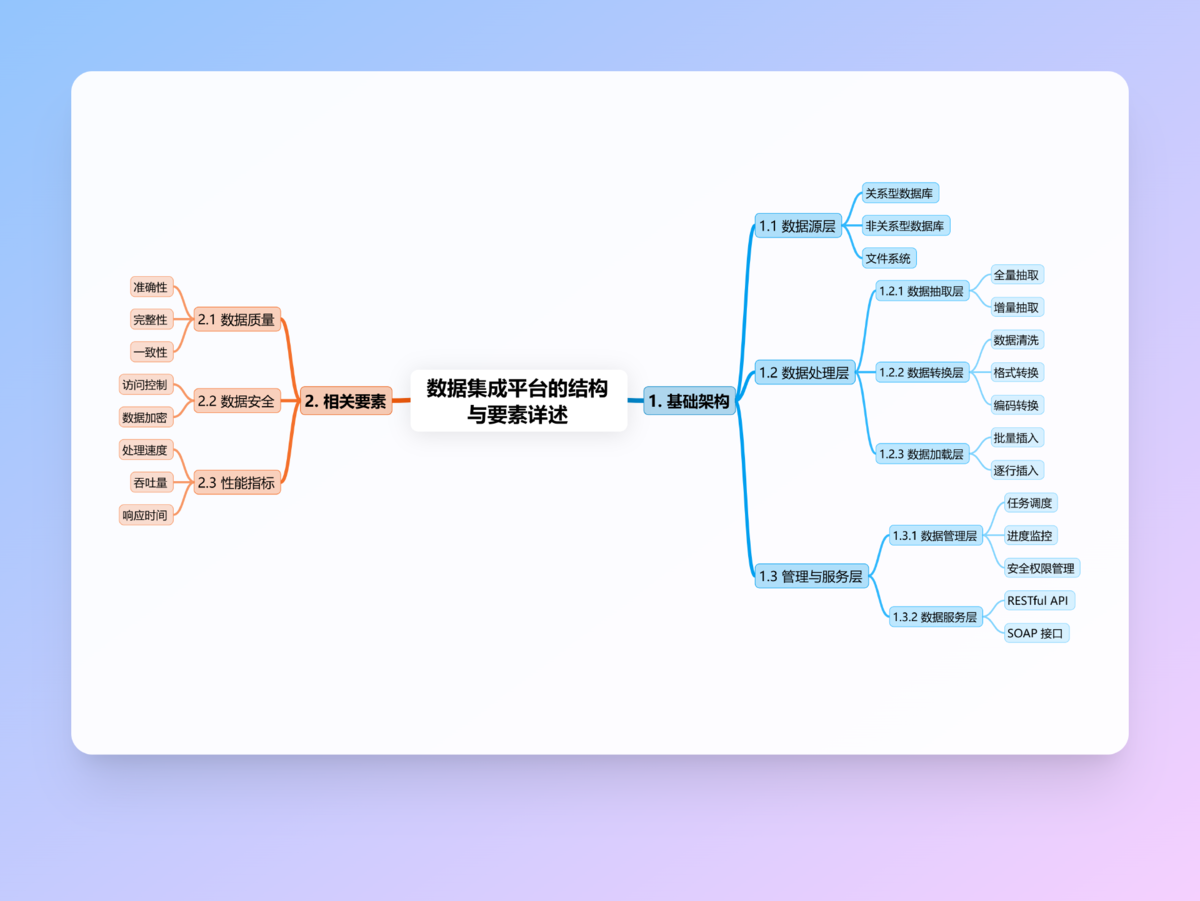

数据集成平台是企业解决数据孤岛问题的核心工具,通过抽取、转换、加载(ETL)流程整合多源异构数据。其重要性体现在三个方面:打破信息壁垒、提升数据质量和支撑数据决策。平台采用六层架构设计:数据源层连接各类系统;抽取层采用增量/全量策略获取数据;转换层进行数据清洗与标准化;加载层将处理后的数据输送至目标系统;管理层负责任务调度与质量监控;服务层通过API提供数据服务。优秀架构具备灵活扩展、高效稳定和安

目录

如今企业都面临一个头疼的问题: 每天数据量巨大,但这些数据来自五花八门的系统(财务、销售、库存...),格式各异,散落在各处。想把它们整合起来有效利用?说实话,真的是很费劲啊! 那也就是这时候,数据集成平台的价值就明明白白地显现出来了。说白了, 它就是专门负责把这些零散数据聚拢到一起、统一管理的工具。而数据集成平台架构,就是构建这个平台的核心蓝图,直接决定了它到底有多大能耐。

读完这篇文章,你就能明明白白地搞清楚:

- 数据集成平台到底是干啥的?

- 为什么它对现代企业这么重要?

- 它的核心架构是怎么一层层运作起来的?

- 这种架构能带来哪些实实在在的好处?

一、 什么是数据集成平台

咱先别急着说为啥要用这个数据集成平台,首要任务是搞懂它到底是什么东西。

用过来人的经验告诉你,数据集成平台的核心作用就是打破这种僵局。它能将各种源头的数据——比如传统的 MySQL、Oracle 数据库,新兴的 MongoDB、Redis,甚至日常的 Excel、CSV 文件——都汇聚到一个地方。具体分三步走:

①抽取:把分散的数据原样“拿”过来,类似收集原材料。

②转换:这一步是重头戏,核心是加工处理:

- 清洗:剔除错误信息、去掉重复记录、补全缺失值;

- 统一格式:比如日期全转成“YYYY-MM-DD”,金额单位统一用“元”;

- 按规则整合:把不同来源的相关数据拼起来,或者算总价、平均值等新字段。

③加载:把处理好的、“干净好用”的数据,“放”到目标系统(比如数据仓库、数据湖或业务系统)。

我一直强调,数据集成平台的价值远不止聚拢数据这么简单。它做了两件关键事:

- 提升数据质量:让数据更准确、更可靠;

- 实时监控管理:盯着数据流动全程,一出问题立刻告警,快速定位解决

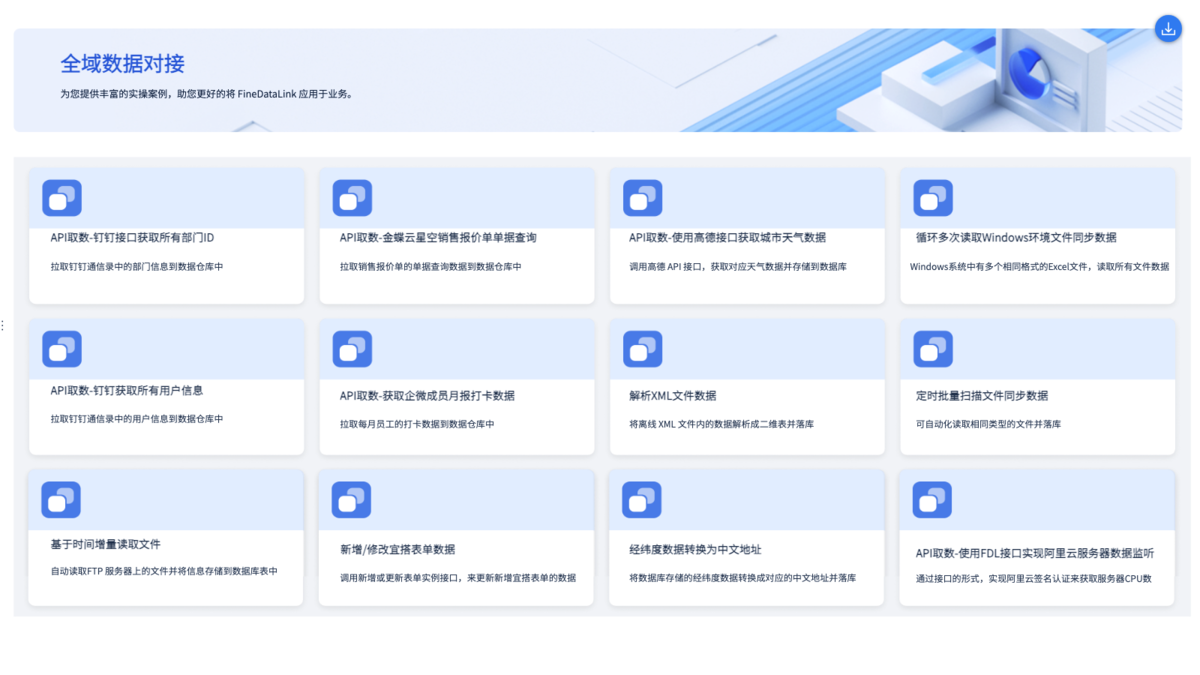

当前市面上确实有很多好工具能帮咱们做到这点。比如 FineDataLink,它在数据整合方面就很有一套,它支持ETL/ETL两种开发方式,覆盖几十种数据源,ERP、CRM、日志文件统统都能接入进来,有效帮助企业解决数据孤岛问题。立即体验FineDataLink>>>FDL 激活

二、数据集成平台的重要性

说白了,数据集成平台在企业数据链条里就是核心枢纽,绝不是可有可无!它为什么这么关键?主要体现在三大硬核价值上:

1.打破信息孤岛

不同部门用不同系统,数据不通是常态。你懂我意思吗? 销售用CRM、财务用ERP、库存用WMS……结果数据各管各的,协作效率低下。平台能把分散数据整合成一张“全景图”,让所有人基于同一份信息工作。数据通了,跨部门协作才顺!

2.提升数据质量

不同系统数据格式五花八门,错误、重复、缺失比比皆是。我一直强调:没质量的数据,再牛的分析工具也白搭! 平台通过清洗→转换→验证三步走,把“脏数据”洗成“干净水”,让分析结果真正可信。

3.支撑数据决策

企业想在竞争中立足,必须靠数据说话。但数据分散时,决策就像盲人摸象。平台提供高质量、统一的数据底座,帮分析工具精准发现机会、预警风险。说白了,没这个基础,数据驱动就是空谈

举个通俗点的例子: 就好比有一家连锁超市,以前各门店的销售数据、库存情况、顾客消费信息都存在在不同系统里。用了数据集成平台后,就能把这些数据都自动整合起来。管理层通过分析这份整合好的数据,就能清清楚楚知道哪些地区、哪些时段什么卖得好?库存跟得上吗?顾客喜欢买啥组合?知道了这些信息,就能及时调整进货量、搞精准促销。结果?销售额和利润实实在在提升了。这就是平台带来的实实在在的价值!

三、 数据集成平台架构解析

数据集成平台内部是六层精密协作的体系,咱们一层层拆开看:

1.数据源层

数据的“起点”,包括:传统数据库(MySQL、Oracle);新型数据库(MongoDB、Redis);文件系统(Excel、CSV日志)。

听着是不是熟? 这些数据往往散落在本地、云端甚至物联网设备里,平台第一步就是连通它们。

2.数据抽取层

负责把数据从源头“搬”出来,核心是两种策略:

全量抽取:适合数据量小或初次同步;

增量抽取:只抓新增或变动数据,省时省资源。

比如电商每天10万订单,增量抽只要5分钟,全量抽可能2小时。要完成这些抽取任务,一款强大的数据抽取工具至关重要。FineDataLink(FDL)就是这样一款出色的工具,它能按照预设规则,灵活地从各种数据源中抽取数据,不管是关系型数据库还是非关系型数据库,都能轻松应对。而且 FDL 支持增量抽取,能精准识别变化的数据,大大提升了抽取效率,就好比给数据抽取装上了一个高效的 “引擎”

3.数据转换层

数据加工的“核心车间”,分三步:

①清洗:剔除错误、去重、补缺失值;

②转换:统一格式(如日期全转YYYY-MM-DD);

③整合:关联多源数据(如订单表+库存表)。

只有扎实地走完清洗、转换、整合这三步,数据才算真正变得“干净”、“规范”、“好用”,为后面的分析提供可靠的原料,这步做扎实了,后面分析才靠谱。

4.数据加载层

数据在前一层已经收拾干净、整理规范了,下一步的任务就是把它们输送到该去的系统里,也就是目标系统,这一环节有三种方式灵活选:

①实时加载:秒级响应,适合风控等场景;

②批量加载:夜间跑批,省资源;

③定时加载:按需设定,不干扰业务

5.数据管理层

用过来人的经验告诉你,这层就是确保整个平台稳定运行、不出乱子的关键。它主要干四件实实在在的事:

①任务调度:

说白了,就是给数据流动排好时间表:什么时候去哪个系统拿数据?拿到后按什么规则清洗转换?处理完该送到哪里?好的调度就像自动排班表,这一功能可以把整个流程串起来,省掉人工盯着的麻烦。

②实时监控:

全程盯着数据流动:抽了多少条?转换有没有报错?加载成功没有? 就像有个24小时值班的“数据保安”,一有问题立刻亮红灯。

③异常处理:

网络断了自动重连,数据格式异常自动隔离——简单来说,就是让问题不扩散、能自愈。实在解决不了的,立马发警报(邮件/短信)叫人处理。

④安全与权限:

精细管好谁能动什么:销售组只能看销售数据,财务组才能改金额规则。没这层管控,前面跑得再快也是裸奔,数据安全根本谈不上。

6.数据服务层

这层可以理解成是平台的“对外窗口”,让企业里其他系统、分析工具或者业务用户,能方便地用到这些整合好的宝贵数据。那这一步怎么实现呢?主要靠两类接口:

- 查询接口(如RESTful API): 业务系统要数据时,直接调接口取——比如报表系统拉销售数据做图表,客服系统查用户订单记录。

- 推送接口: 实时把数据“喂”给业务系统。比如库存低于10件时,自动触发补货提醒到采购系统。

这层如果做不好,前面辛苦整好的数据就是死水一潭,再优质也产生不了价值!

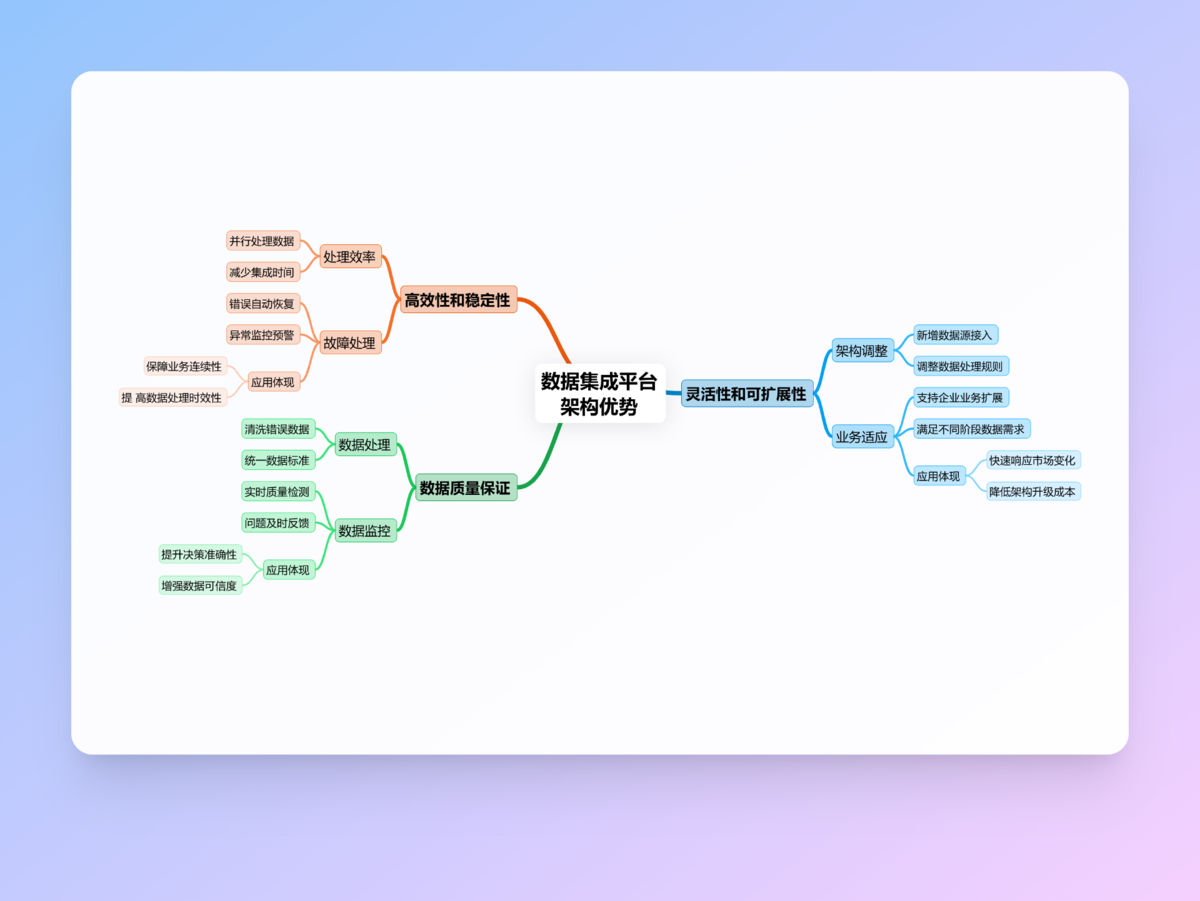

四、 数据集成平台架构的优势

选择或设计一个好的架构,带来的好处是实实在在、看得见摸得着的:

1.灵活性和可扩展性强

企业的需求有所改变?延展了新的业务?数据量突然暴涨?面对这些突发情况,好的架构能通过添加新数据源、调整转换规则、扩展服务接口等方式轻松应对这些变化。

2.高效且稳定

只要架构设计合理的话,像数据抽取、转换、加载这些步骤,能并行处理的就并行处理,可以大大缩短整体完成时间,提高整体的工作效率。并且每一层都有它应对错误与突发情况的方式,能够保证集成过程不易崩,哪怕出现问题也能较快得到调整与恢复,不影响总体的工作进度。

FineDataLink(FDL)在这方面表现卓越。FDL 采用了先进的分布式处理技术,能让数据抽取、转换和加载等操作并行执行,极大地缩短了数据集成的时间。而且在出现网络故障、数据源异常等问题时,FDL 有智能的错误处理和重试机制,就像一个可靠的 “守护者”,能自动进行重试,确保数据集成的稳定性和高效性,保障企业数据的顺畅流转。

3.保障数据质量与安全

我一直强调,数据质量是生命线! 转换层那些清洗和转换规则,就是提升质量的核心关卡。管理层持续的监控和及时的告警,形成了一个质量控制的闭环,能持续发现问题、解决问题。安全不是靠喊的,是靠做的,管理层严格的权限控制、数据传输和存储时的加密、详细的审计日志,再加上对敏感数据的脱敏处理,这一套组合拳下来,才能真正确保数据安全合规。

说到底, 数据集成平台就是现代企业管好数据、用好数据绕不开的核心工具。它实实在在地解决了数据分散、格式混乱、质量参差的老大难问题,打通了信息孤岛,为企业的数据分析和科学决策提供了最关键的、统一可靠的数据基础。

而它内部的分层架构——从连接五花八门的数据源(数据源层),到高效抽取(抽取层)、精细加工(转换层)、精准投放(加载层),再到全局统筹管理(管理层)和开放服务(服务层)——正是这一切能高效、稳定、安全运行的根本保障。

用我这个过来人这些年的经验告诉你, 一个好的架构,核心价值就在于灵活扩展、高效稳定、保障质量安全这三点上。企业在选型或自建时,一定要结合自己实际的业务需求和数据特点(数据量大小、实时性要求、安全等级、预算等),找到那个最对路的架构方案,千万别盲目追新或贪大求全。

Q&A 常见问题解答

Q:数据集成平台架构复杂吗?感觉有点晕。

A:说实话, 复杂度确实有,尤其当企业数据环境很庞大复杂的时候。但关键在于,它是可以灵活调整的! 小型企业或者刚起步时,完全可以从满足核心需求(抽、转、载)的相对简单架构开始,够用就好。等业务和数据量上来了,再逐步引入更完善的管理层、更丰富的服务层。好在现在市面上有很多成熟的集成工具(开源像Airbyte, 商业如FineDataLink),界面友好,开箱即用,能大大降低自己从头搭建复杂架构的难度和门槛。

Q:这种架构怎么保证我的数据安全?特别是敏感数据。

A:数据安全是重中之重,主要靠数据管理层来实现,核心手段有这几板斧:

- 严格的权限控制:精细设置谁(用户/角色)能访问哪些数据(比如只能看自己部门的数据)、能进行什么操作(只能读?能修改配置?能删数据?)。敏感数据(如薪资、客户隐私)必须严格控制访问范围。

- 数据传输和存储加密:数据在网络上“跑”的时候(比如从源系统到平台,或从平台到目标系统),以及在平台自己存储的时候,必须加密(常用SSL/TLS, AES),防止被半路截胡或非法访问。没加密裸奔?绝对不行!

- 审计日志:详细记录关键操作:谁(哪个账号)在什么时间、操作了什么(访问了哪些数据、修改了哪个任务配置)、操作结果如何。出了问题方便追踪溯源,也是合规审计的硬要求。

- 数据脱敏:对于身份证号、银行卡号、手机号这类敏感数据,在提供给非必要人员或环境(比如测试环境、给外包分析团队)时,要进行脱敏处理,比如替换成模拟数据。说白了,就是不该看的就别让人看到真东西。

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)