运行comfyui Wan2.1 文生视频工作流,问题总结

ComfyUI 的文生图工作流(Text-to-Image)是一个基于节点化操作的多阶段生成过程,其核心逻辑是将文本提示词逐步转化为图像,涉及模型加载、文本编码、潜空间生成、采样解码等步骤。以下是其完整运行过程及可能导致速度缓慢的原因分析:

第一次跑comfyUI 遇到了一些常见的问题:

1:comfyui 页面文件太小,无法完成操作

2:运行完成以后 运行结果(webp) 文件存储到哪里去了

3:把comfyui 安装到了,机械硬盘上了。倒是运行一个简单的文生图8分钟

第一个:遇到ComfyUI页面文件(虚拟内存)不足的问题

*1. 手动增加虚拟内存(Windows系统)*

步骤:

-

打开系统属性

-

- 右键点击 “此电脑” 或 “我的电脑” → 选择 “属性”。

- 点击右侧的 “高级系统设置”。

-

进入虚拟内存设置

-

- 在 “高级” 选项卡 → “性能” 区域点击 “设置”。

- 再次进入 “高级” 选项卡 → 点击 “更改”(虚拟内存部分)。

-

调整虚拟内存大小

-

- 初始大小:物理内存的1.5倍(如16GB内存 →

16*1.5*1024=24576 MB)。 - 最大值:物理内存的3倍(如16GB →

16*3*1024=49152 MB)。

- 初始大小:物理内存的1.5倍(如16GB内存 →

-

- 取消勾选 “自动管理所有驱动器的分页文件大小”。

- 选择ComfyUI所在的驱动器(通常是C盘)→ 选择 “自定义大小”。

- 建议值(根据物理内存调整):

- 点击 “设置” → “确定”,重启电脑生效。

*2. 清理磁盘空间*

- 确保目标驱动器(如C盘)有足够空间存放虚拟内存文件(至少预留10-20GB)。

- 使用磁盘清理工具或手动删除临时文件、缓存等。

*3. 优化ComfyUI配置*

-

指定临时文件路径:

在ComfyUI启动命令或配置文件中,将临时目录指向空间充足的磁盘(需修改config.json或启动参数)。# 示例(命令行启动时指定路径) python main.py --temp-dir D:\comfyui_temp -

降低工作流内存占用:

拆分大型工作流,避免一次性加载过多模型或高分辨率图像。

*4. 检查系统与日志*

- 查看错误日志:

打开ComfyUI的日志文件(通常位于comfyui.log),确认具体错误信息。 - 系统事件查看器:

Win + R → 输入eventvwr.msc→ 检查 Windows日志 > 系统 是否有内存相关错误。

*5. 其他可能性*

- 升级物理内存:若频繁遇到内存不足,考虑增加RAM(如从16GB升级到32GB)。

- 使用SSD:将虚拟内存文件设置在SSD驱动器上,提升交换速度。

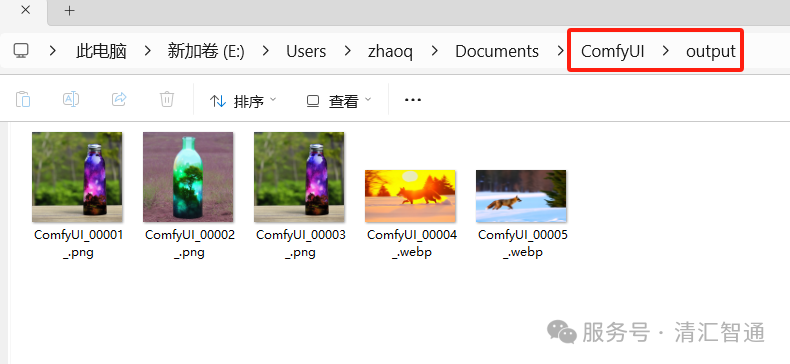

第二个问题:运行完成以后 运行结果(webp) 文件存储到哪里去了

1:一般都存在再,comfyUI的安装目录里面的output 文件夹下面

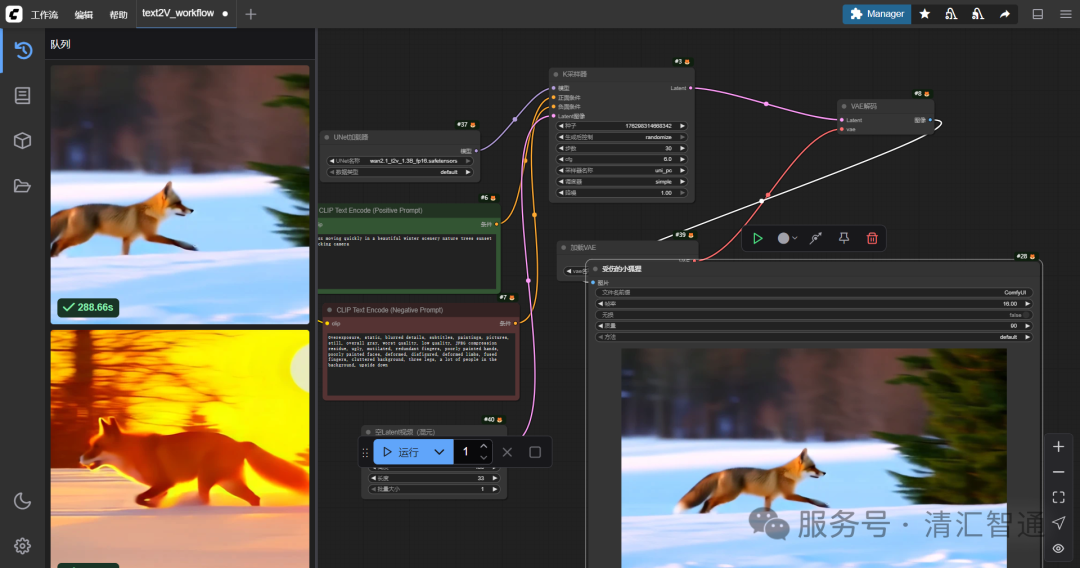

工作流图片保存位置

工作流图片保存位置

第三个问题:跑一个文生图 RTX4060 8G为啥慢

ComfyUI 的文生图工作流(Text-to-Image)是一个基于节点化操作的多阶段生成过程,其核心逻辑是将文本提示词逐步转化为图像,涉及模型加载、文本编码、潜空间生成、采样解码等步骤。以下是其完整运行过程及可能导致速度缓慢的原因分析:

*一、文生图工作流的核心运行流程*

-

加载基础模型

-

- MODEL(图像生成模型)

- CLIP(文本编码器,将文字转为语义向量)

- VAE(潜空间与像素空间的转换器)

-

- 节点:

Load Checkpoint - 作用:加载预训练的扩散模型(如 Stable Diffusion),包含三个核心组件:

- 耗时点:大模型(如 SDXL、FLUX 等)体积庞大(通常数 GB),加载到显存需要时间,尤其是首次启动时。

- 节点:

-

文本编码

-

- 节点:

CLIP Text Encode(正/负提示词) - 作用:将用户的文字描述(如 “beautiful scenery”)和负面提示词(如 “watermark”)编码为模型可理解的语义向量。

- 耗时点:复杂的提示词需要更长的编码时间,尤其是使用多语言或长文本时。

- 节点:

-

初始化潜空间

-

- 节点:

Empty Latent Image - 作用:创建初始的潜空间画布(Latent Space),定义生成图像的尺寸(如 512x512)。

- 耗时点:高分辨率(如 1024x1024)会增加后续采样计算量。

- 节点:

-

扩散采样生成

-

- Steps(迭代步数,通常 20-30 步)

- CFG Scale(提示词相关性,值越高越贴近文本)

- Sampler(如 Euler a、DPM++ 2M)

-

- 节点:

KSampler - 作用:结合模型、提示词和潜空间,通过迭代去噪生成潜空间图像。关键参数包括:

- 耗时点:高步数(Steps)和复杂采样器(如 DPM++)显著增加计算时间。

- 节点:

-

解码与保存

-

- 节点:

VAE Decode+Save Image - 作用:将潜空间图像解码为可视像素图像,并保存到本地。

- 耗时点:大尺寸图像解码需要更多显存和计算资源。

- 节点:

*二、运行速度缓慢的主要原因*

-

模型加载与初始化

-

- 首次加载模型:需要从硬盘读取大模型文件到显存,若磁盘速度慢(如 HDD)或显存不足,会显著延迟启动时间。

- 冷启动问题:长时间未使用后,函数计算环境可能回收实例,重新加载模型需重复初始化。

-

显存与计算资源限制

-

- 显存不足:高分辨率图像或复杂模型(如 SDXL、FLUX)占用大量显存,可能导致显存溢出(OOM),触发降速或失败。

- GPU 性能瓶颈:低端显卡(如 GTX 1060)难以高效处理扩散模型的并行计算。

-

节点配置与参数选择

-

- 高步数(Steps):例如设置 50 步会比 20 步耗时增加 2 倍以上。

- 复杂采样器:DPM++ 2M 等算法精度高但计算密集。

- 分块放大流程:如使用分块采样器(Tiled KSampler)或 UltimateSD 插件时,分块处理会增加显存交换频率。

-

插件与依赖影响

-

- 插件冲突:某些插件(如 ControlNet、VideoHelperSuite)可能引入额外计算或依赖加载。

- 环境配置问题:缺少 FFmpeg 或 OpenCV 等依赖库,可能触发后台安装或报错。

-

系统与网络因素

-

- 磁盘 I/O 瓶颈:频繁读写临时文件或缓存时,低速硬盘会拖累整体流程。

- 网络延迟:在线下载模型或插件时,网络不稳定可能导致等待。

*三、优化速度的实用建议*

-

硬件与资源优化

-

- 使用 SSD 提升模型加载速度,确保显存充足(建议至少 8GB 显存)。

- 在函数计算环境中,开启 镜像加速 或设置 预热策略 减少冷启动时间。

-

参数调整

-

- 降低 Steps(如 20-25 步)和 CFG Scale(如 7-8)。

- 选择轻量采样器(如 Euler a)而非 DPM++ 系列。

-

工作流简化

-

- 移除不必要的节点(如重复的 ControlNet 或插件)。

- 对高分辨率需求,优先使用 潜在放大(Latent Upscale)而非直接生成大图。

-

环境与依赖管理

-

- 定期清理插件和模型,避免冗余文件占用资源。

- 确保 FFmpeg、OpenCV 等依赖库已正确安装并更新。

-

使用高效模型

-

- 选择优化后的模型(如 FLUX 或 Stable Diffusion 3 Medium),其生成速度和质量可能优于传统 SDXL。

*四、最后*

ComfyUI 的文生图工作流因其模块化设计具备高度灵活性,但性能受模型复杂度、硬件配置和参数设置的多重影响。通过优化显存分配、简化工作流、选择高效模型,可显著提升生成速度。对于进阶用户,结合分块采样、插件管理等功能,可在速度与质量间找到平衡。

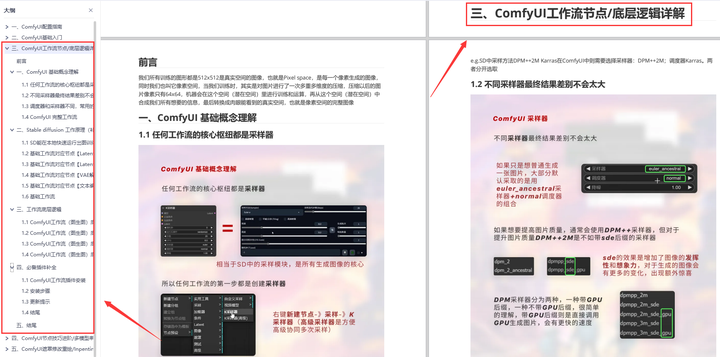

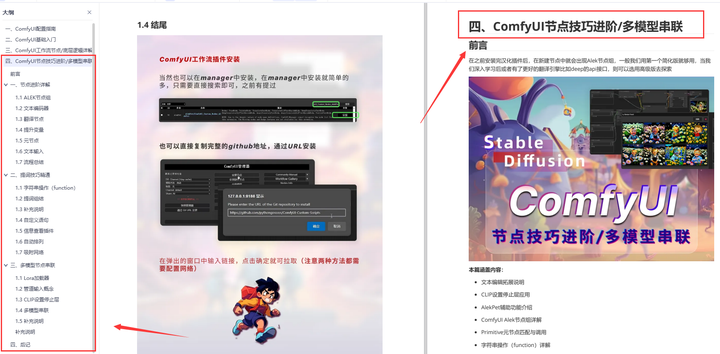

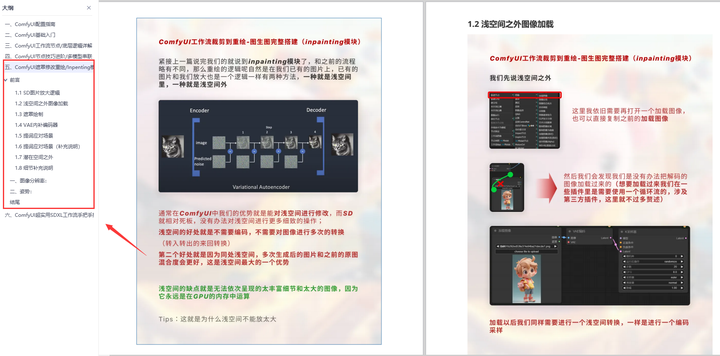

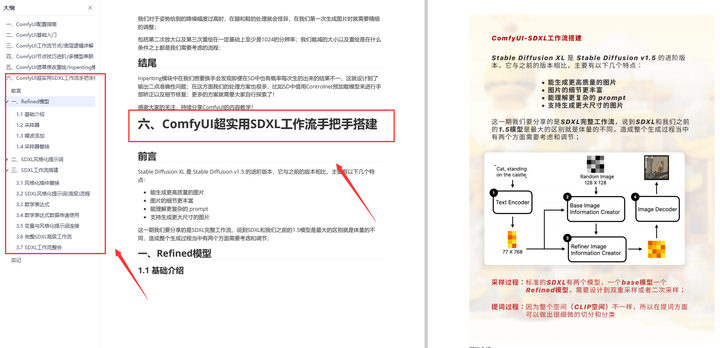

为了帮助大家更好地掌握 ComfyUI,我在去年花了几个月的时间,撰写并录制了一套ComfyUI的基础教程,共六篇。这套教程详细介绍了选择ComfyUI的理由、其优缺点、下载安装方法、模型与插件的安装、工作流节点和底层逻辑详解、遮罩修改重绘/Inpenting模块以及SDXL工作流手把手搭建。

由于篇幅原因,本文精选几个章节,详细版点击下方卡片免费领取

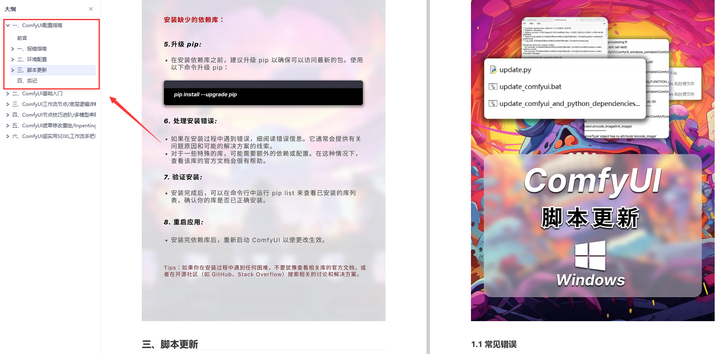

一、ComfyUI配置指南

- 报错指南

- 环境配置

- 脚本更新

- 后记

- …

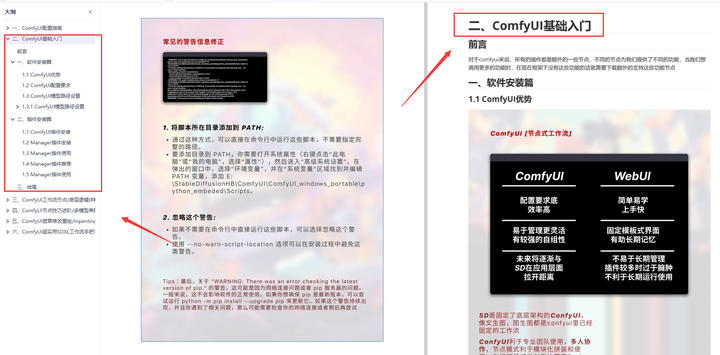

二、ComfyUI基础入门

- 软件安装篇

- 插件安装篇

- …

三、 ComfyUI工作流节点/底层逻辑详解

- ComfyUI 基础概念理解

- Stable diffusion 工作原理

- 工作流底层逻辑

- 必备插件补全

- …

四、ComfyUI节点技巧进阶/多模型串联

- 节点进阶详解

- 提词技巧精通

- 多模型节点串联

- …

五、ComfyUI遮罩修改重绘/Inpenting模块详解

- 图像分辨率

- 姿势

- …

六、ComfyUI超实用SDXL工作流手把手搭建

- Refined模型

- SDXL风格化提示词

- SDXL工作流搭建

- …

由于篇幅原因,本文精选几个章节,详细版点击下方卡片免费领取

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)