【深度学习系列--经典论文解读】ImageNet Classification with Deep Convolutional Neural Networks

AlexNet是深度学习的里程碑式论文,开创了计算机视觉的新时代。该论文提出的深度卷积神经网络在2012年ImageNet比赛中以15.3%的错误率远超传统方法(26.2%),主要创新包括:使用ReLU激活函数加速训练、Dropout防止过拟合、GPU并行计算解决显存限制、数据增强提升泛化能力。虽然存在计算成本高、LRN效果有限等局限,但其深度架构设计理念(5卷积层+3全连接层)和训练方法为后续V

目录

前言

2012 年,Alex Krizhevsky 等人发表了划时代的论文《ImageNet Classification with Deep Convolutional Neural Networks》,简称 AlexNet。这篇论文首次在 ImageNet 图像识别比赛中以遥遥领先的成绩获胜,使得深度学习一举成为计算机视觉领域的主流方法。

0. 为什么这篇论文值得读

开启了深度学习视觉识别的黄金时代;

证明了卷积神经网络(CNN)在大规模图像分类中的强大性能;

引入了ReLU、Dropout、局部响应归一化、GPU并行计算等创新技术;

是理解现代卷积网络(如 VGG、ResNet)的奠基之作。

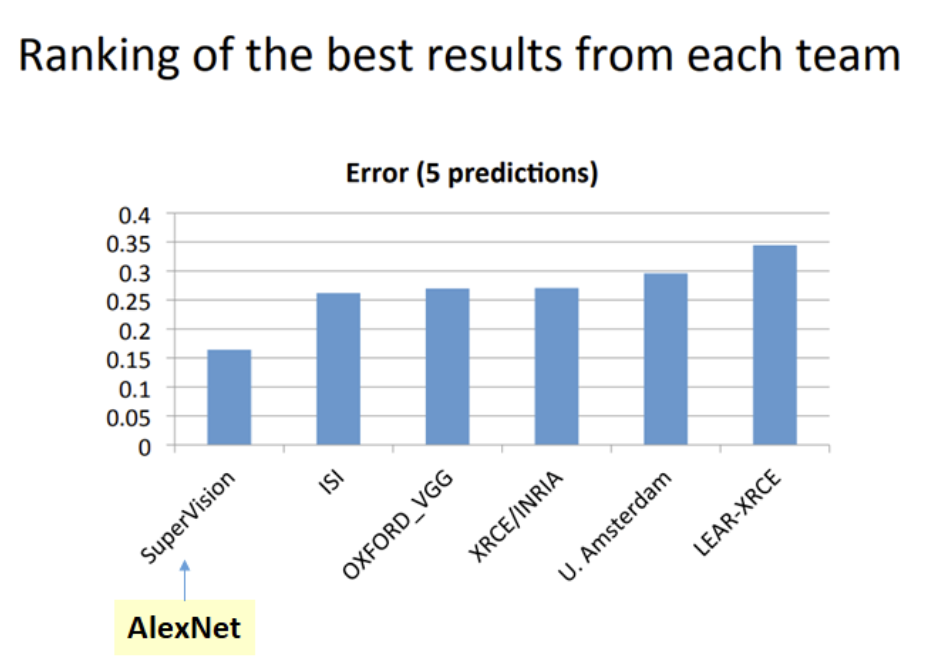

AlexNet以显著优势赢得了2012年ImageNet大规模视觉识别挑战赛。其Top-5错误率降至15.3%,远超第二名(基于传统计算机视觉方法)的26.2%。这一结果震惊了整个计算机视觉和机器学习社区。

AlexNet彻底改变了计算机视觉的研究方向。在其之后,基于CNN的方法迅速成为图像识别、目标检测、语义分割等几乎所有视觉任务的主导方法,并持续至今。它标志着从手工设计特征(如SIFT, HOG)向数据驱动、端到端学习特征的根本性转变。

1. 背景与问题

当时的主流图像分类方法如 SIFT + HOG 特征提取 + SVM 等方法,面对 ImageNet 这样超过百万张图的大规模任务表现乏力。而传统 CNN 又因计算资源不足、过拟合等问题未被充分发展。

作者提出的问题:

如何设计一个深层次的神经网络架构,能在千万量级图像上进行有效训练并取得优异性能?

2. 研究内容

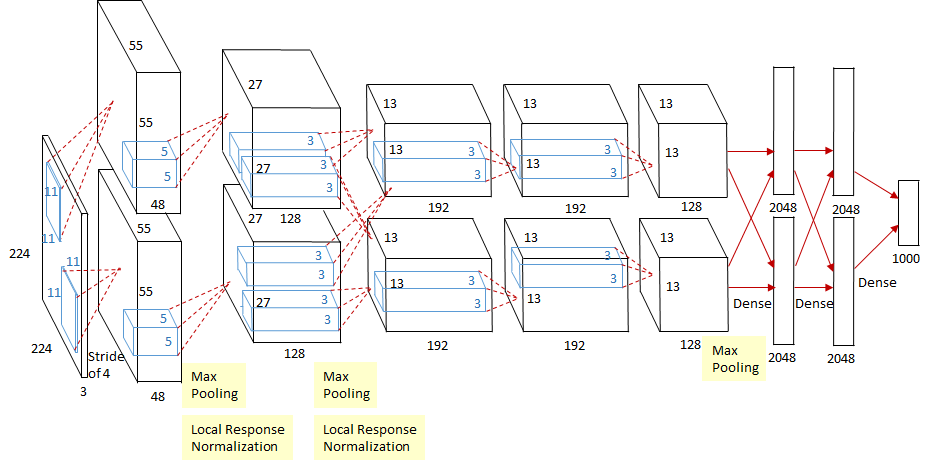

设计了一个包含 8 层(5 个卷积层 + 3 个全连接层) 的深度卷积神经网络,并训练该模型用于对 ImageNet ILSVRC-2010 数据集的 1000 类图像进行分类。

-

输入:224×224 RGB 图像

-

输出:1000 类的 softmax 预测概率

-

训练数据:120 万张图像

3. LeNet-5 → AlexNet 网络结构

虽然 AlexNet 与 LeNet-5 都是 CNN,其深度、设计理念已有巨大飞跃

| 特性 | LeNet-5 (1998) | AlexNet (2012) | 进步意义 |

|---|---|---|---|

| 深度 | 5层 (2卷积+2池化/下采样+1FC) | 8层 (5卷积+3池化+3FC) | 证明了更深网络的必要性和可行性。 |

| 规模 | 约6万参数 | 约6000万参数 | 模型容量指数级增长,能捕捉更复杂模式。 |

| 激活函数 | Sigmoid/Tanh | ReLU | 训练速度极大提升,缓解梯度消失。 |

| 正则化 | 权重衰减 | Dropout | 更强大的正则化,显著减轻过拟合。 |

| 数据 | MNIST (小规模,28x28 灰度) | ImageNet (大规模,256x256 彩色) | 大数据驱动是深度模型成功的关键。 |

| 计算硬件 | CPU | GPU (NVIDIA GTX 580 x2) | GPU并行计算使训练大规模深度网络成为现实。 |

| 输入/输出 | 灰度图像,10分类 | 彩色图像,1000分类 | 处理更复杂、高分辨率、多类别的任务。 |

| 池化 | 平均池化,非重叠 (2x2, stride2) | 最大池化,重叠 (3x3, stride2) | 保留更显著特征,信息更丰富。 |

| 归一化 | 无 | LRN (局部响应归一化) | 尝试增强神经元间的竞争(虽然后续被BN取代)。 |

| 分组卷积 | 无 | 有 (用于GPU并行) | 解决当时显存限制的工程创新。 |

| 影响力 | 开创CNN概念 | 引爆深度学习革命 | 从学术概念证明走向工业级实用,改变整个领域。 |

-

输入层 (Input):

输入图像尺寸:224 x 224 x 3 (RGB彩色图像) -

卷积层 1 (Conv1):

卷积核:96个,尺寸 11x11,步长 4。-

输出特征图尺寸:(224-11)/4 + 1 = 55x55x96。

-

独特设计:分组卷积 (Grouped Convolution): 由于当时GPU显存限制(每块GTX 580仅有3GB),Alex创新性地将96个卷积核平均分配到2块GPU上执行(每组48个核)。因此,Conv1的输出实际上是2组独立的55x55x48特征图,分别位于两块GPU上。这是模型并行的一种早期形式。

-

激活函数:ReLU (Rectified Linear Unit):

计算简单高效(无需指数运算)。有效缓解梯度消失问题(正区间梯度恒为1)。加速收敛。论文中明确指出ReLU的使用让网络训练速度比使用tanh快数倍。f(x) = max(0, x)。这是AlexNet最关键的创新之一。相比传统的tanh或sigmoid激活函数: -

局部响应归一化 (Local Response Normalization - LRN): 在ReLU之后应用。LRN旨在模仿生物神经元的侧向抑制机制,对局部邻域内的响应进行归一化,增强大响应并抑制小响应。后续研究表明LRN的效果有限或不稳定,在更深的网络(如VGG, ResNet)中已被Batch Normalization取代。

-

最大池化层 (Max Pooling): 核尺寸 3x3,步长 2。

-

输出特征图尺寸:(55-3)/2 + 1 = 27x27x96 (仍然是分组的,每GPU 27x27x48)。

-

-

-

卷积层 2 (Conv2):

-

卷积核:256个,尺寸 5x5,步长 1,填充 2 (保证输出尺寸不变)。

-

输出特征图尺寸:27x27x256。

-

分组卷积: 同样在2块GPU上执行。关键点: 卷积操作只发生在同一GPU内的特征图之间。即,每个GPU上的卷积核只对本GPU在Conv1输出的48个特征图进行卷积(输入通道48),然后各自产生128个特征图(每组128个核)。最后将两块GPU的结果在通道维度拼接,得到256通道的输出。

-

激活函数:ReLU。

-

LRN。

-

最大池化层: 核尺寸 3x3,步长 2。

-

输出特征图尺寸:(27-3)/2 + 1 = 13x13x256 (分组的,每GPU 13x13x128)。

-

-

-

卷积层 3 (Conv3):

-

卷积核:384个,尺寸 3x3,步长 1,填充 1。

-

输出特征图尺寸:13x13x384。

-

分组卷积: 输入是256通道(分两块GPU,各128通道)。本层的384个核也分为两组(各192个)。重要变化:卷积操作现在跨GPU进行! 即,每个GPU上的192个卷积核会对两块GPU上共256个输入特征图进行卷积(输入通道256)。这增加了模型容量和特征融合能力。输出每组192通道,拼接成384通道。

-

激活函数:ReLU。

-

无池化,无LRN。

-

-

卷积层 4 (Conv4):

-

卷积核:384个,尺寸 3x3,步长 1,填充 1。

-

输出特征图尺寸:13x13x384。

-

分组卷积: 结构与Conv3完全相同(输入384通道,分组卷积跨GPU,输出384通道)。

-

激活函数:ReLU。

-

无池化,无LRN。

-

-

卷积层 5 (Conv5):

-

卷积核:256个,尺寸 3x3,步长 1,填充 1。

-

输出特征图尺寸:13x13x256。

-

分组卷积: 类似Conv2。输入384通道(分两块GPU,各192通道)。本层256个核分为两组(各128个)。卷积操作只发生在同一GPU内(每组核只对本GPU的192个输入特征图做卷积)。

-

激活函数:ReLU。

-

最大池化层: 核尺寸 3x3,步长 2。

-

输出特征图尺寸:(13-3)/2 + 1 = 6x6x256 (分组的,每GPU 6x6x128)。

-

-

-

全连接层 6 (FC6):

-

展平: 将Conv5的输出(6x6x256 = 9216维)展平成一个一维向量。

-

神经元数量:4096个。

-

激活函数:ReLU。

-

Dropout: 这是AlexNet另一个极其关键的创新,首次在CNN中大规模成功应用。在训练阶段,以0.5的概率随机将FC6层的每个神经元的输出置零。这相当于每次训练迭代时随机采样一个“更瘦”的网络。

-

作用: 强制网络学习更鲁棒的特征,防止神经元之间复杂的共适应(co-adaptation),是一种非常有效的正则化技术,大大减轻了过拟合。

-

推理阶段: 不使用Dropout,所有神经元都参与,但输出值需要乘以Dropout概率(0.5)以保持期望值不变(或者权重在训练时已经隐含了缩放,具体实现方式有差异)。

-

-

-

全连接层 7 (FC7):

-

神经元数量:4096个。

-

激活函数:ReLU。

-

Dropout: 同样以概率0.5应用。

-

-

全连接层 8 (FC8) / 输出层:

-

神经元数量:1000个 (对应ImageNet的1000个类别)。

-

激活函数:Softmax。将1000个神经元的输出转化为代表1000个类别的概率分布。

-

4.创新点总结

深度卷积结构: 在当时是最深的实用网络之一(8层),证明了深度对于学习复杂视觉层次化表示的重要性

ReLU激活函数: 极大加速了训练过程,缓解了梯度消失,成为后续几乎所有深度学习模型的标配。

Dropout: 强大的正则化技术,有效抑制过拟合,尤其在全连接层效果显著,至今仍是常用手段(尽管在纯卷积网络中有时被BN替代)。

重叠最大池化 (Overlapping Max Pooling): 使用步长小于核尺寸(3x3核,步长2)的池化,相比传统非重叠池化(2x2核,步长2)能保留更多信息,并轻微提升性能

数据增强 (Data Augmentation): 在训练时动态对输入数据进行变换以增加数据多样性,减轻过拟合,包括:

①图像裁剪 (Random Cropping): 从原始256x256图像中随机裁剪出224x224区域。

②水平翻转 (Horizontal Flipping): 随机水平翻转图像。

③颜色扰动 (PCA-based RGB Jittering): 对RGB像素值进行主成分分析(PCA),并沿主成分方向添加微小扰动(均值为0,标准差为0.1的高斯噪声乘以PCA特征值)。这是一种早期且有效的颜色扰动方式。

GPU并行训练: 开创性地使用两块GPU并行训练,通过分组卷积实现模型并行,解决了当时单GPU显存不足的问题,显著缩短了训练时间。(注:现代GPU显存足够大,通常不再需要这种显式的分组卷积)

局部响应归一化 (LRN): 虽然其重要性后来被质疑并被BN取代,但在当时是设计的一部分。

5.局限性

-

计算成本高: 即使在当时最强的GPU上也需要训练数天,模型参数量大(约6000万)。

-

过拟合风险: 尽管有Dropout和数据增强,相对于其参数规模,ImageNet的120万张训练图像仍然不算非常充足(后续模型如ResNet在更大数据集上效果更好)。

-

结构优化空间: 后续研究很快发现了更有效的结构:

-

VGGNet: 证明了使用更小的卷积核(3x3)堆叠更多层是更优选择。

-

GoogLeNet (Inception): 引入Inception模块,在增加深度和宽度的同时控制计算量。

-

ResNet: 通过残差连接解决了极深度网络(>100层)的梯度消失/爆炸问题,性能大幅提升。

-

-

LRN的替代: Batch Normalization (BN) 被证明是比LRN更有效、更通用的归一化技术。

-

分组卷积的淘汰: 随着GPU显存增大,显式的分组卷积不再是必需品。

6. 可参考之处

对于设计卷积网络的层数、卷积核大小、激活函数等选择有借鉴意义;

启发了后续网络设计中的模块化思想(如残差块、Inception 模块);

训练技巧(数据增强、Dropout、权重初始化)被广泛继承;

展示了大数据 + 强计算力 + 深度模型的威力,是深度学习发展三要素的典范案例。

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)