Zscaler:2025年人工智能AI安全报告

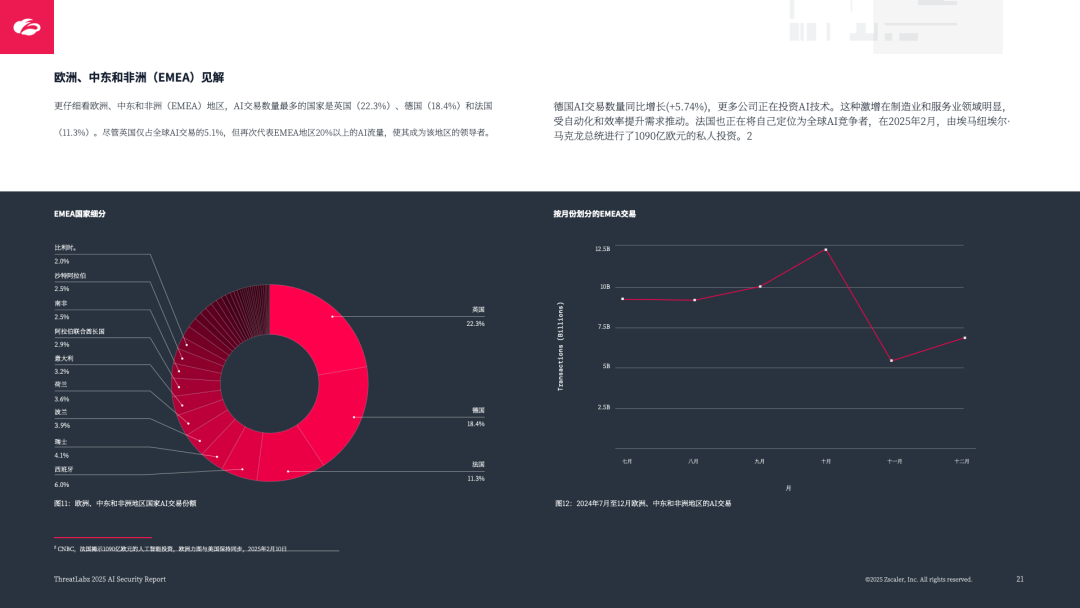

全球 TOP5 国家:美国(46.2%)、印度(8.7%)、英国(5.1%)、德国(4.2%)、日本(3.6%),美国因灵活监管推动 AI 实验,印度依托国家战略扩大行业覆盖;自主 AI(Agent AI)威胁:可自主决策、执行多步任务(如分析社交媒体生成定制钓鱼信息),降低人类监督,易被劫持操纵,且 “影子 AI”(未经授权部署)扩大攻击面;EMEA 区域:英国(22.3%)、德国(18.4%)

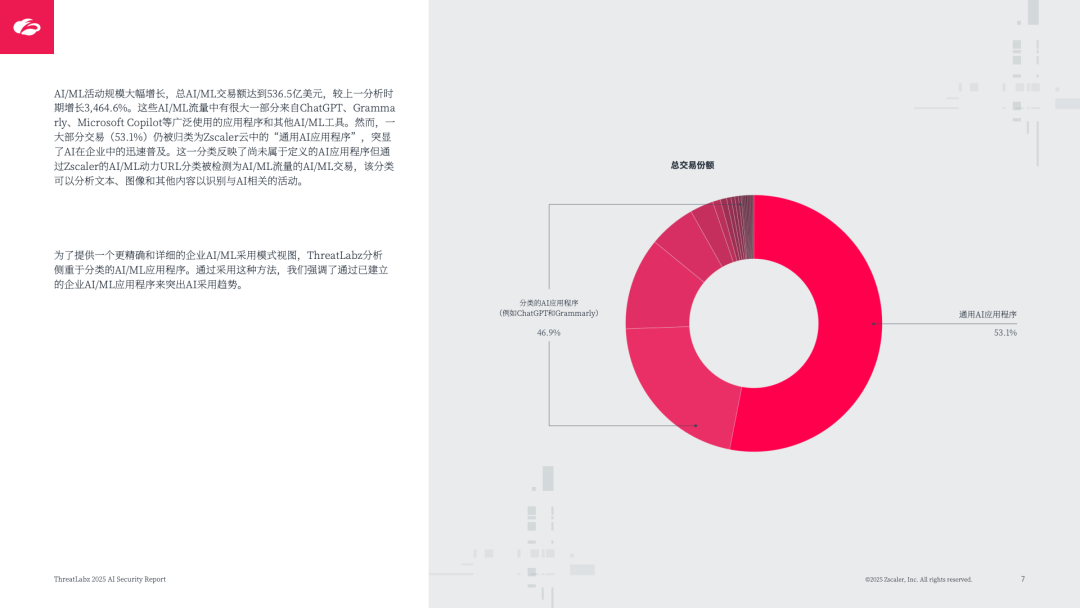

该报告由 Zscaler ThreatLabz 基于 2024 年 2 月至 12 月全球 5365 亿笔 AI/ML 交易数据编制,聚焦企业 AI 采⽤趋势、安全风险、威胁场景及防护方案,揭示 AI 在提升效率的同时,面临的 “攻击性 AI 领先防御性 AI” 困境,核心内容如下:

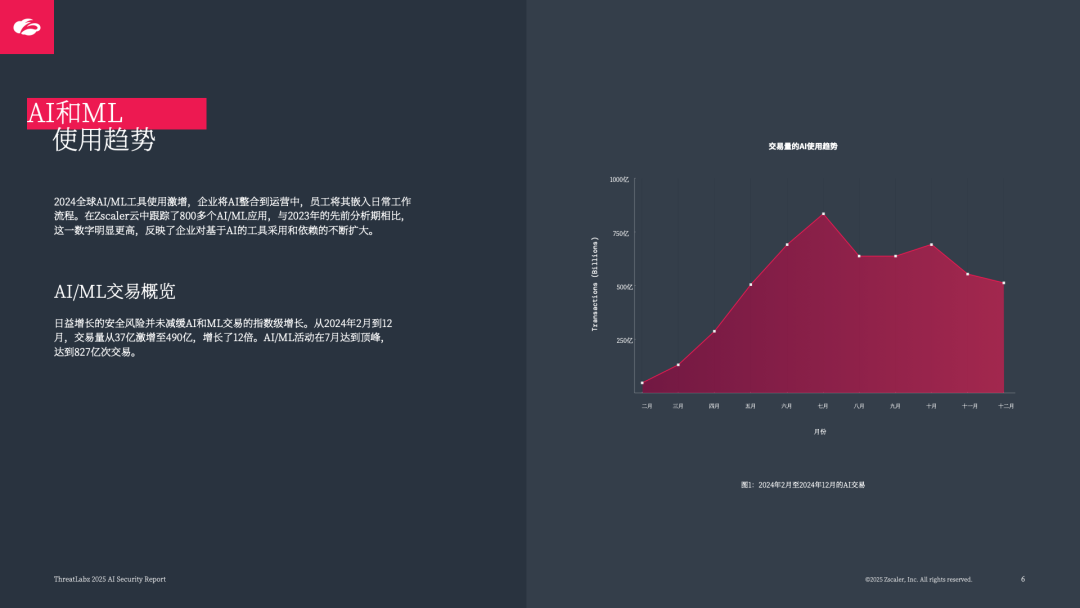

一、AI/ML 使用现状:交易量激增,安全管控同步加强

1. 使用规模指数级增长

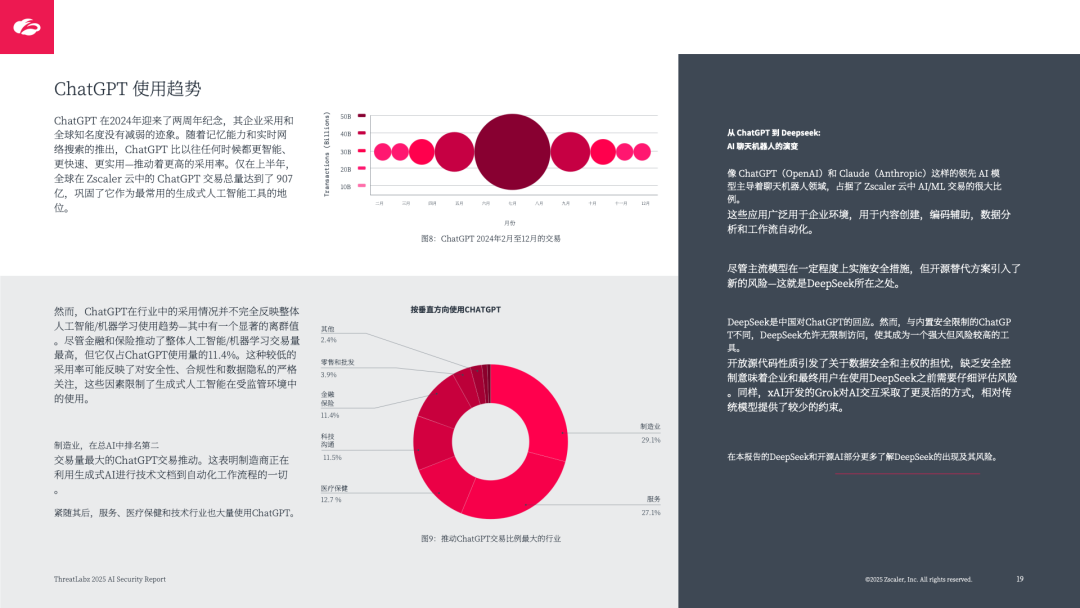

交易量爆发:AI/ML 工具交易量同比激增 36 倍(+3464.6%),2024 年 2 月至 12 月从 37 亿笔增至 490 亿笔,7 月达峰值 827 亿笔,覆盖 800 多个 AI/ML 应用;

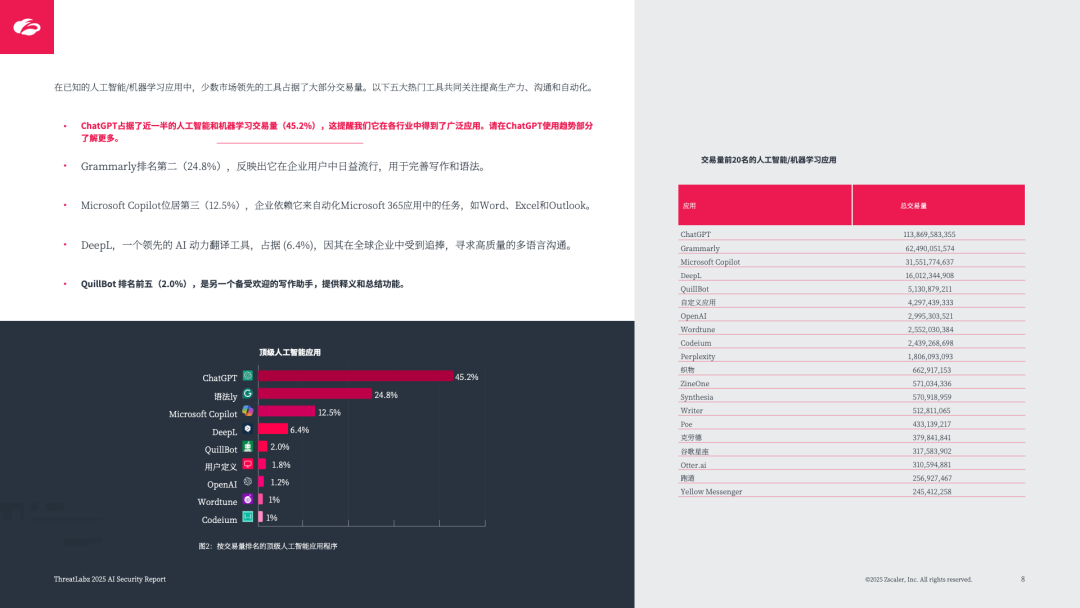

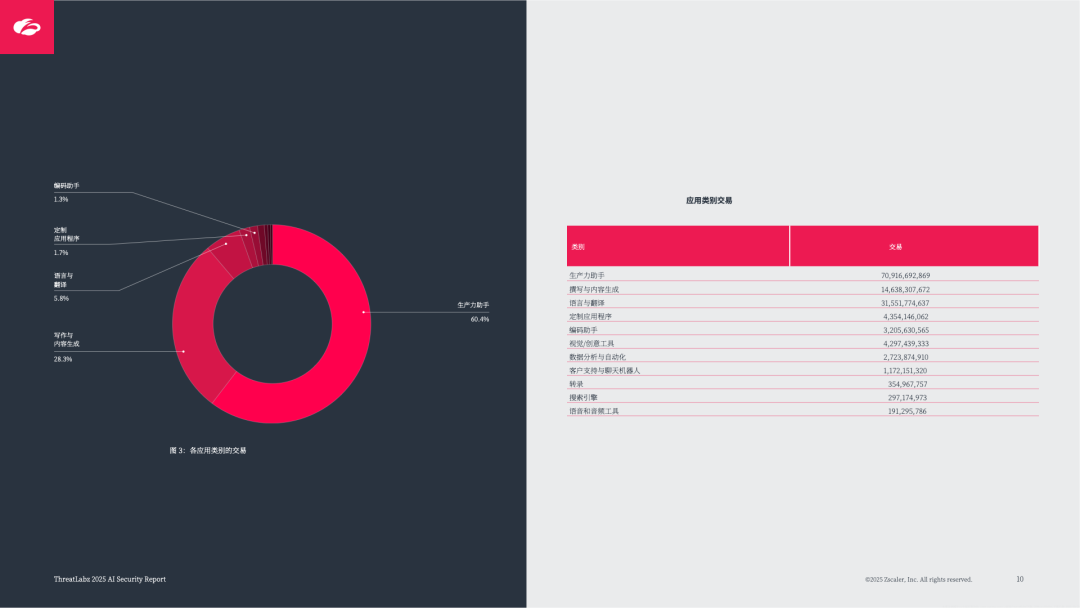

核心应用主导:ChatGPT 占已知 AI/ML 交易量的 45.2%(数据传输量 1481TB),其次是 Grammarly(24.8%)、Microsoft Copilot(12.5%),均聚焦生产力提升与内容生成;

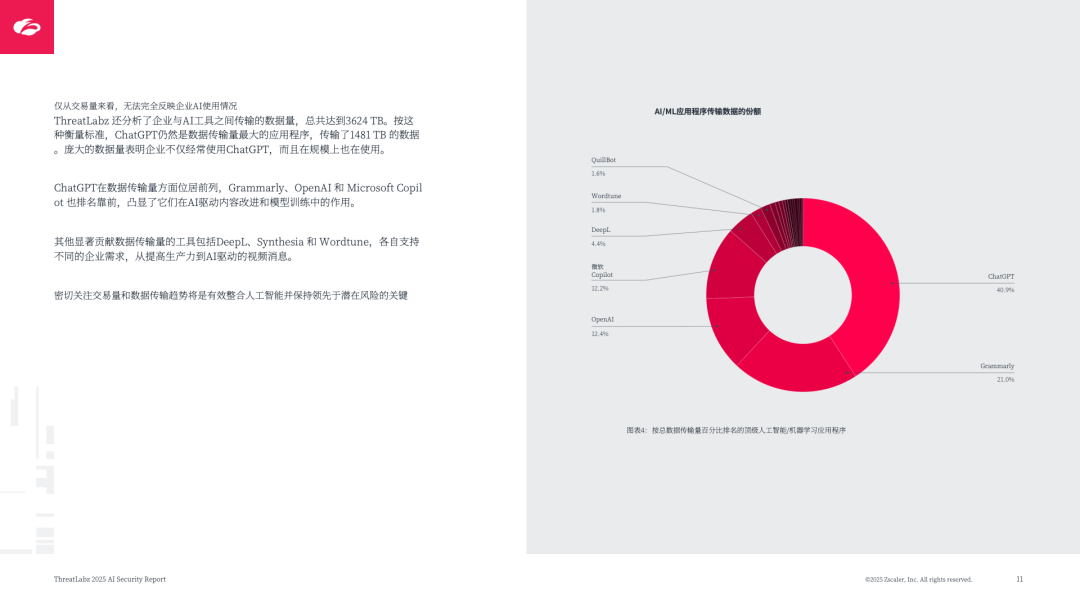

数据传输庞大:企业通过 AI/ML 应用传输数据总计 3624TB,反映 AI 在业务中的深度渗透。

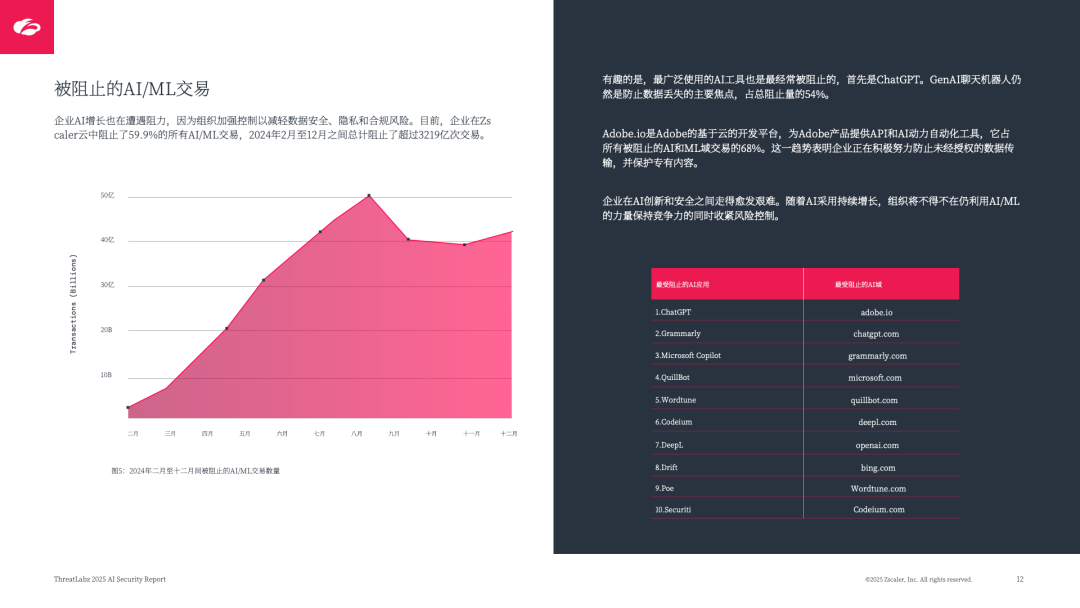

2. 安全管控力度加大

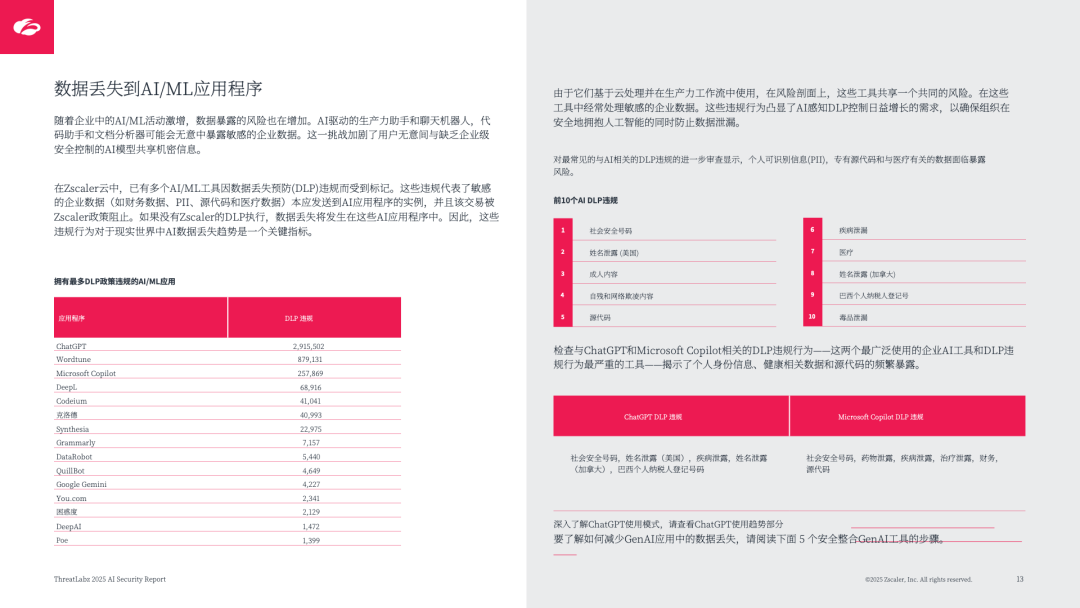

交易阻止率高:59.9% 的 AI/ML 交易被主动阻止,ChatGPT 是最常被阻止的应用(占总阻止量 54%),其次是 Grammarly、Microsoft Copilot,核心原因是数据安全与合规担忧;

数据丢失风险突出:ChatGPT、Wordtune、Microsoft Copilot 是 DLP(数据丢失预防)违规最多的应用,暴露数据以 PII(个人身份信息)、源代码、医疗数据为主,仅 ChatGPT 就有 291.5 万次 DLP 违规。

二、行业与区域差异:采⽤度与安全策略分化

1. 行业差异:金融、制造领先,安全态度不一

2. 区域差异:美国主导,欧亚加速追赶

全球 TOP5 国家:美国(46.2%)、印度(8.7%)、英国(5.1%)、德国(4.2%)、日本(3.6%),美国因灵活监管推动 AI 实验,印度依托国家战略扩大行业覆盖;

EMEA 区域:英国(22.3%)、德国(18.4%)、法国(11.3%)为核心,法国 2025 年投入 1090 亿欧元推动 AI;

APAC 区域:印度(36.4%)、日本(15.2%)、澳大利亚(13.6%)领先,日本因文化与监管谨慎采⽤,菲律宾以 41.5% 年均增速加速,但面临岗位替代风险。

三、核心安全风险:从数据泄露到自主 AI 威胁

1. 企业 AI 采⽤的基础风险

数据质量与幻觉:低质量 / 有毒训练数据导致误导性输出,AI “幻觉”(生成虚假信息)可能被利用注入恶意载荷;

知识产权暴露:第三方 AI 模型可能保留 / 复用企业敏感数据(如内部算法、专有研究),模型反演攻击可提取训练数据;

隐私合规风险:部分 AI 供应商存储输入数据用于训练或共享,违反 GDPR、HIPAA 等法规,且供应商安全标准参差不齐。

2. 开源 AI 的高风险:以 DeepSeek 为例

核心特点:中国开源 LLM,开发成本低(V3 模型约 600 万美元,仅为 GPT-4 的 6%)、API 成本低(每百万令牌 0.55 美元,远低于 OpenAI 的 15 美元),但安全控制薄弱;

关键风险:

弱安全防护:50% 以上越狱尝试成功,可生成仇恨言论、恶意代码;

数据外泄:支持 “提示注入” 生成钓鱼页面(如模仿 Microsoft Live 登录页),5 步简单提示即可完成高仿真钓鱼页面;

数据主权:中国开发背景可能面临政府监督,跨境数据隐私风险高。

3. AI 驱动的网络威胁场景

强化社交工程:深度伪造技术升级(如 OmniHuman-1 从单张照片生成实时视频)、语音克隆(几秒录音即可模仿声⾳),推动语音钓鱼(Vishing)激增,曾出现针对 Microsoft Teams 用户的语音钓鱼攻击;

AI 恶意软件与勒索软件:自动化攻击链(从漏洞扫描到数据窃取),多态恶意软件动态重写代码躲避检测,对抗性 AI 实时分析安全响应;

自主 AI(Agent AI)威胁:可自主决策、执行多步任务(如分析社交媒体生成定制钓鱼信息),降低人类监督,易被劫持操纵,且 “影子 AI”(未经授权部署)扩大攻击面;

虚假 AI 平台案例:威胁行为者创建 “Flora AI” 虚假平台,伪装成企业 AI 工具,通过欺诈 PDF(实为恶意 LNK 文件)传播 Rhadamanthys 信息窃取者,利用用户对 AI 的信任实施攻击。

四、全球 AI 监管:欧盟领先,国际协作加强

1. 区域监管进展

欧盟 AI 法案:2024 年 8 月生效,按风险分级管控 ——“不可接受风险”(如生物特征监控)直接禁止,“高风险”(如医疗、交通 AI)强制对抗性测试与事件报告,GenAI 需披露训练数据来源;

美国:无联邦统一框架,2025 年废止旧行政令,推出 “星门计划”(5000 亿美元 AI 基础设施合资项目),依赖企业自监管;

国际协作:2024 年签署《前沿 AI 安全承诺》(16 家全球 AI 公司)、《国际情报框架公约》(欧盟、美、英),成立国际 AI 安全研究所网络,推动安全标准协调。

五、2025-2026 威胁预测:风险进一步升级

AI 社交工程新高:GenAI 结合语音 / 视频钓鱼,初始访问经纪人将规模化使用 AI 生成定制化攻击内容;

自主 AI 代理风险:未经监管的自主 AI 可能泄露数据或被劫持,威胁行为者利用其映射攻击面、发动个性化诈骗;

虚假 AI 服务激增:利用企业对 AI 的兴趣,通过伪造平台传播恶意软件、窃取凭证;

开源 AI 武器化:DeepSeek、Grok 等开源模型降低攻击门槛,流氓模型(专用于网络犯罪训练)将出现;

Deepfake 跨行业欺诈:生成假身份证、伪造医疗影像(如 X 光片)、保险欺诈图⽚,破坏身份验证信任;

GenAI 保护成核心要务:GenAI 嵌入业务越深,模型篡改、数据污染风险越大,保护从 IT 优先转为企业安全核心。

六、安全实践:零信任 + AI 防护方案

1. 安全采⽤ GenAI 的 5 个步骤

全面阻止初始访问:零信任立场,阻止所有 AI/ML 应用,消除即时风险;

审查批准合规工具:制定安全 / 隐私标准,仅批准符合要求的 AI(如 ChatGPT);

部署私人实例:在企业内部托管 AI(如 Azure 专用服务器),确保数据主权,防止供应商访问敏感数据;

强化访问控制:通过 SSO、MFA、零信任架构(如 Zscaler Zero Trust Exchange)限制访问,监控加密流量;

强制 DLP 防护:部署 AI 感知 DLP 引擎,阻止敏感数据(PII、源代码)通过 AI 提示泄露。

2. Zscaler 零信任 + AI 防护核心能力

全链路威胁防护:在攻击链各阶段(侦察、初始妥协、横向移动、数据外泄)应用 AI,如隐藏攻击面、隔离可疑内容、智能分割访问;

AI 驱动功能:内联钓鱼检测、智能提示阻止、零信任浏览器(隔离恶意内容)、AI 数据分类与 DLP、入侵预测(基于攻击图与风险评分);

数据优势:依托全球最大安全云(每日处理 500T + 遥测信号、500B + 交易),训练高精准 AI 模型,每天阻止 90 亿次威胁。

七、结论

AI 已成为企业效率核心,但威胁行为者利用其放大攻击规模与复杂度。企业需摒弃传统安全模型,转向 “零信任 + AI” 架构,通过严格管控 AI 访问、保护数据、对抗 AI 驱动威胁,平衡创新与安全,避免沦为 AI 安全风险的受害者。

点击文后阅读原文,可获得下载资料的方法。

欢迎加入智能交通技术群!扫码进入。

点击文后阅读原文,可获得下载资料的方法。

联系方式:微信号18515441838

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献11条内容

已为社区贡献11条内容

所有评论(0)