服务于下一代人工智能数据中心的800V高压直流配电系统

你必须能够将它安装在功率密度更高的解决方案中,仅仅是因为这些机架中有如此多的功率,现在的800V转换器也将位于其中,而它必须是高效的,并且必须具有非常高的功率密度,”Morroni 解释道。如今,TI在功率转换方面的专业知识与NVIDIA的AI专业知识相结合,使800V高压直流架构能够支持前所未有的AI计算需求,”Jeffrey Morroni 说。客户系统中的概念验证和2026年生产,”Morr

人工智能(AI)的快速发展对数据中心基础设施提出了前所未有的要求,特别是在电力传输方面。为了应对这一挑战,德州仪器(TI)和NVIDIA宣布合作开发用于下一代人工智能数据中心的800V高压直流(HVDC)配电系统。德州仪器Kilby Labs电源管理研发总监兼研究员Jeffrey Morroni解释了这种创新的电源架构如何满足AI工作负载不断增长的计算需求。

对更高电压配电的需求

随着人工智能模型的复杂性不断增加,每个数据中心机架的功率需求预计将在短时间内从目前的100kW增加到1MW以上。传统的48V配电系统尚未准备好。这一十倍的增长是由高密度人工智能处理器的激增推动的,预计未来两年内每个芯片都需要高达3kW的功率。

Morroni表示:“要为1MW机架供电,当今的48V配电系统将需要近450磅的铜,这使得48V系统在物理上不可能扩展供电以支持长期的计算需求。此类系统所需的铜的重量和体积使其不切实际,需要不同的供电解决方案。”

较低电压下的高电流会导致显著的I2R损失,导致大量热量形式的能源浪费。这不仅增加了运营成本,还需要适当的冷却系统,进一步加剧了功耗问题。该行业已经公开承认,根本性的变革势在必行。“业界承认必须做出一些改变,我认为NVIDIA是其中的重要组成部分,”Morroni说。

向800V HVDC架构的过渡通过显著降低相同功率输出所需的电流来解决这些限制。这不仅最大限度地减少了配电组件的物理占地面积,还提高了效率和可靠性。

“人工智能数据中心正在将功率极限推向以前难以想象的水平。几年前,我们面临着48V基础设施作为下一个重大挑战。如今,TI在功率转换方面的专业知识与NVIDIA的AI专业知识相结合,使800V高压直流架构能够支持前所未有的AI计算需求,”Jeffrey Morroni 说。

800V HVDC架构

向800V HVDC架构的过渡代表了数据中心供电的根本性重新设计。通过将配电电压从48V提高到800V,可以大大降低提供相同功率所需的电流。该解决方案最大限度地减少了传导损耗,减小了铜缆的尺寸和重量,并能够提供更紧凑、更可扩展的配电系统。

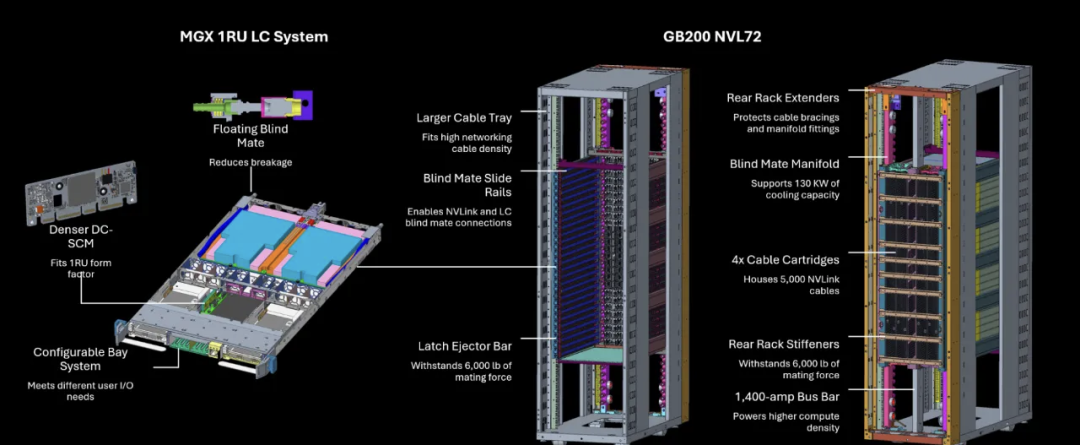

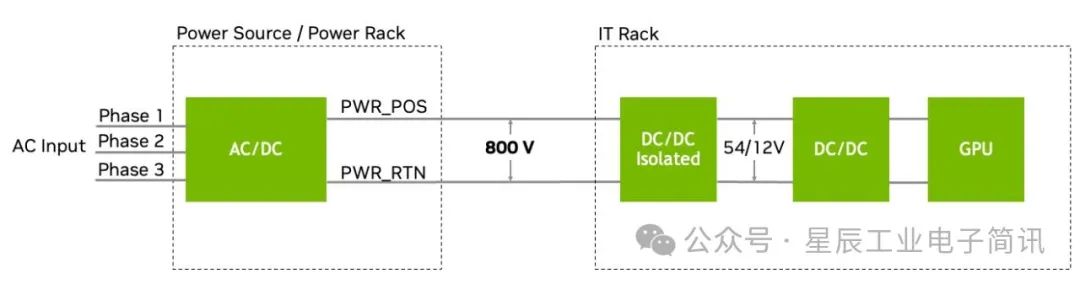

新架构的核心是三阶段功率转换过程。首先对输入的三相交流电源进行整流并转换为800VDC。然后,这种高压直流电被分布到服务器机架的背板上,中间总线转换器(IBC)将电压降压到适合服务器组件的水平,例如48V或12V。最后,下一步的转换级提供处理器和内存模块所需的低电压。这种多阶段方法可确保效率和安全性,同时支持现代人工智能工作负载所需的高功率密度。图1. 显示了800V架构可以成功应用于数据中心的案例。

图1:800V HVDC分配到IT机架和DC/DC转换为12V负载点,例如:GPU(来源:NVIDIA Corporation)

转向800V配电并不是全新的,它建立在电动汽车(EV)和电网基础设施的进步之上。十多年来,TI一直在投资高压技术,特别是在电动汽车领域,其800V系统已经投入使用。

“800V电动汽车就是一个很好的例子。与支持800V机架所需的基础设施和技术相比,安全支持800V电动汽车所需的技术和半导体基础设施看起来非常相似,”Morroni指出。这种技术诀窍加速了800V系统在数据中心的采用。

支持技术:氮化镓和先进的电源管理

800V HVDC系统的一个关键因素是采用氮化镓(GaN)技术。与传统硅器件相比,GaN半导体具有卓越的开关速度、更低的传导损耗和更高的热效率。正如Morroni所概述的那样,“氮化镓对于实现800V系统所需的高功率密度和效率至关重要。它实现了更高的开关频率,这对于减小功率转换组件的尺寸和提高整体系统效率是必要的。”

氮化镓器件部署在功率转换的初级和次级阶段,包括同步整流器和IBC。它们集成到先进散热封装(例如 TOLT封装)中,可实现高效散热,考虑到所涉及的巨大功率密度,这是一个关键的考虑因素。液体冷却系统也被集成到服务器机架中,以管理处理器和电源转换组件的热输出。

除了氮化镓之外,800V架构还集成了一套先进的电源管理技术。固态断路器提供快速故障检测和隔离,利用基于人工智能的电弧故障检测算法来增强安全性和可靠性。热插拔控制器可确保800V托盘的安全连接和断开,而可堆叠电池监视器可精确管理锂离子电池备用单元,这些备用电池单元现在以类似于电动汽车(EV)电池组的方式堆叠至800V。

应对挑战

高压供电的主要挑战之一是PCB布线和隔离的物理复杂性。走线之间数百伏的电压差需要增加爬电距离和间隙,这反过来又限制了PCB尺寸并使布局更具挑战性。

“当将800V靠近处理器时,传导损耗会下降,但隔离要求会上升,”Morroni 解释道:“绕过高密度I/O并仍然保持必要的安全裕度变得极其困难。”

出于这个原因,TI设想继续使用多级供电,800V保持相对上游,中间电压为处理器附近的最终PoL转换器供电。“这不仅仅是一个电气挑战,它也是一个机械和热挑战。多级转换供了更好的灵活性来管理这三者。”

热管理也非常重要。随着功率密度的增加,组件产生的热量也会增加。在高性能计算中已经很普遍的液体冷却系统将变得更加重要。Morroni强调说:“从GaN FET散发出来的热量进入这些散热系统,并在服务器机架内使用的这些液体冷却系统,是一个巨大的挑战。”

另一个挑战在于中间总线转换器(IBC)的设计,该转换器将800V电源降压到适合处理器的较低电压。这些转换器必须高效且紧凑,才能适应服务器机架的有限空间。“你必须能够将它安装在功率密度更高的解决方案中,仅仅是因为这些机架中有如此多的功率,现在的800V转换器也将位于其中,而它必须是高效的,并且必须具有非常高的功率密度,”Morroni 解释道。

未来的思考

向800V配电的转变不仅限于NVIDIA,它反映了更广泛的行业趋势。超大规模企业和数据中心领域的其它主要参与者也在探索高压解决方案,以满足不断增长的电力需求。

“NVIDIA并不是唯一一个谈论这个问题的人。每个人都在我们所有不同的客户群中谈论这个问题,这是因为他们都看到了相同的趋势和相同的挑战,”Morroni 观察到。

采用800V HVDC的时间表非常紧迫,预计最早将于2025年实现概念验证系统,生产部署计划于2026年进行。“该行业正在非常迅速地转向这些更高电压的配电。我们正在讨论2025年在客户系统中的概念验证和2026年生产,”Morroni 补充道:“随着我们向兆瓦级人工智能机架迈进,800V不再是可选的,而是基础。而且这个行业比以往任何时候都将更快地实现这一目标。”

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)