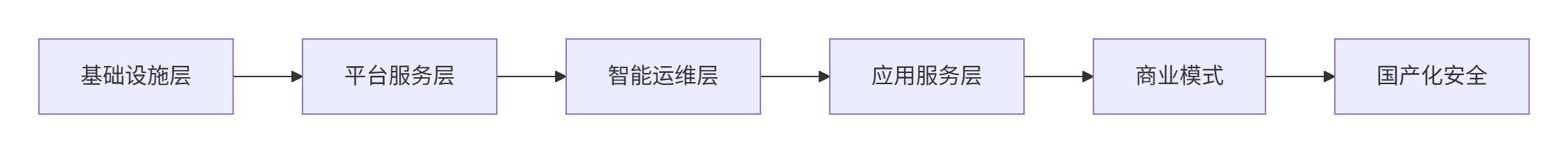

【人工智能智算中心】整体设计

商业成功关键技术:通过 “3D混合并行+RoCEv2优化” 实现千卡线性度>90%产品:推出 “训练即服务(TaaS)” 按MFU(Model FLOPs Utilization)计费生态:构建 “模型市场+开发者社区” 形成闭环生态创新计费公式TaaS计费 =\text{GPU小时} \times \text{MFU系数} \times \text{单

·

一、智算中心整体设计模块

1. 基础设施层

| 模块 | 核心内容 | 关键技术 |

|---|---|---|

| 机房与供电 | - 液冷机柜(单柜50kW) - 高压直流供电(效率>96%) - 抗震/防洪等级设计 |

冷板式液冷、AI动态调压 |

| 计算资源池 | - GPU训练集群(A100/H800) - XPU推理集群(昆仑芯) - CPU预处理集群 |

GPU裸金属服务、SR-IOV虚拟化 |

| 存储资源池 | - 全闪分布式存储(CX8028) - 分级存储(Optane+NVMe+HDD) - 并行文件系统(GPFS) |

NVMe-oF over RDMA、EC纠删码(n+k策略) |

| 网络资源池 | - 三级CLOS组网(Spine-Leaf) - 参数网(200G RoCEv2) - 存储网(100G NVMe-oF) |

DCQCN拥塞控制、Flowlet ECMP路由 |

2. 平台服务层

| 模块 | 核心内容 | 关键技术 |

|---|---|---|

| 调度系统 | - 多级队列管理(VIP/生产/开发) - 拓扑感知调度(NUMA/GPU-NIC亲和) - 弹性扩缩容 |

DRL强化学习调度器、Gang Scheduling |

| AI训练平台 | - 分布式训练框架(PyTorch+DeepSpeed) - 可视化编排(拖拽式Pipeline) - 模型版本管理 |

3D并行策略自动生成、Checkpoint自动容灾 |

| 推理服务平台 | - 模型量化(FP16/INT8) - 动态批处理(Dynamic Batching) - 多模型服务(Triton) |

TensorRT优化、请求级GPU隔离 |

| 数据治理平台 | - 数据血缘追踪 - 隐私计算(联邦学习) - 数据脱敏引擎 |

差分隐私(ε≤0.5)、同态加密(Paillier算法) |

3. 智能运维层

| 模块 | 核心内容 | 关键技术 |

|---|---|---|

| 监控告警 | - 全栈指标采集(GPU温度/网络空泡率) - 根因分析(RCA) - 光模块寿命预测 |

LSTM故障预测模型、贝叶斯网络诊断 |

| 能效管理 | - PUE实时监测(目标≤1.15) - 负载均衡调优 - 碳足迹追踪 |

AI动态调频(DVFS)、冷却塔智能启停 |

| 安全防护 | - 零信任网络(ZTNA) - 硬件可信根(TPM 2.0) - 模型防窃取(水印+加密) |

国密SM4算法、模型混淆保护 |

4. 应用服务层

| 模块 | 核心内容 | 关键技术 |

|---|---|---|

| AI模型市场 | - 预训练模型(LLaMA/ResNet) - 微调工坊(Fine-tuning Studio) - 模型评测报告 |

模型许可证管理(Token制)、API计费网关 |

| 行业解决方案 | - 医疗影像分析 - 智能制造质检 - 金融风控模型 |

领域自适应(Domain Adaptation)、少样本学习 |

| 开发者生态 | - SDK工具链(Python/Java) - 沙箱环境 - 竞赛平台 |

JupyterLab集成、AutoML自动调参 |

二、计费与资源租赁模式

1. 资源租赁计费模型

| 资源类型 | 计费维度 | 定价策略 | 适用场景 |

|---|---|---|---|

| 计算资源 | - GPU卡时(vGPU小时) - XPU推理QPS |

阶梯定价:0-1万小时 0.8/时,>1万小时 0.6/时 |

大模型训练/实时推理 |

| 存储资源 | - 高速存储(NVMe)GB/月 - 冷存储(HDD)GB/月 |

NVMe: 0.1/GB/月<br>HDD: 0.01/GB/月 |

训练数据集/模型仓库 |

| 网络带宽 | - 参数网带宽(Gbps/月) - 跨域专线(Gbps/月) |

参数网: 50/Gbps/月<br>跨域: 200/Gbps/月(保底+突发) |

分布式训练/跨中心同步 |

| 平台服务 | - 训练任务(按vGPU小时加成) - 模型托管(实例/月) |

训练加成费20% 托管费 $500/实例/月 |

AutoML/模型服务化 |

2. 增值服务收费

| 服务类型 | 计费方式 | 案例价格 | 价值点 |

|---|---|---|---|

| 模型微调 | 按训练时长+数据量阶梯收费 | 100小时+1TB数据:$5000 | 领域知识注入 |

| 容灾备份 | 备份容量+恢复SLA收费 | 黄金级(RTO<1min):$0.05/GB/月 | 业务连续性保障 |

| 安全加固 | 按模型价值比例收费 | 模型估值100万 → 年费5万 |

防模型窃取/投毒攻击 |

| 国产化迁移 | 一次性项目服务费 | 百卡集群迁移:$50万起 | 信创适配(鲲鹏+昇腾) |

3. 创新商业模式

-

资源预留包

- GPU年包:预付10万小时享7折,闲置时段可转竞价实例

- 存储容量包:买1PB送100TB冷存储

-

效果分成模式

- 金融风控模型:按调用量分成(例:0.01元/次请求)

- 药物研发AI:按研发里程碑支付(先导化合物发现→$10万)

-

生态合作计划

- ISV合作伙伴:开发者分润70%(模型市场销售)

- 高校科研计划:免费算力配额(年度TOP10论文奖励$5万)

三、国产化与安全设计

1. 国产化演进路径

| 层级 | 2024目标 | 2025目标 |

|---|---|---|

| 硬件 | 昆仑芯/Moore线程/昇腾/寒武纪占比≥30% | 全国产芯片占比≥80% |

| 软件 | 麒麟/统信OS+MindSpore适配完成 | 自研AI框架(如OneFlow)部署 |

| 协议 | RoCEv2国产交换机组网 | 自研通信库(替代NCCL) |

2. 安全体系

graph TD

A[硬件安全] --> TPM 2.0可信启动

B[数据安全] --> 传输加密(SSL)+存储加密(SM4)

C[模型安全] --> 水印植入+混淆保护

D[网络安全] --> 零信任网关(ZTNA)四、关键性能指标(KPI)

| 指标 | 目标值 | 测量方式 |

|---|---|---|

| 资源利用率 | GPU平均利用率≥85% | Prometheus+DCGM |

| 训练任务SLA | 作业完成率≥99.9% | 调度器日志审计 |

| 能效比 | PUE≤1.15 | 智能电表+温感探头 |

| 故障恢复 | RTO≤3分钟(GPU级) | 故障注入测试 |

总结:智算中心设计全景图

商业成功关键:

- 技术:通过 “3D混合并行+RoCEv2优化” 实现千卡线性度>90%

- 产品:推出 “训练即服务(TaaS)” 按MFU(Model FLOPs Utilization)计费

- 生态:构建 “模型市场+开发者社区” 形成闭环生态

创新计费公式:

- TaaS计费 =

\text{GPU小时} \times \text{MFU系数} \times \text{单价}(MFU≥50%时系数=1.2)- 模型托管 =

\text{基础费} + \text{QPS} \times \text{单价} + \text{数据合规附加费}

该设计支撑从IaaS资源租赁到AI模型分成的全栈服务,预计投资回报率(ROI)在3年内达150%。

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)