深度解析 大型语言模型为何会胡说八道 ? 揭秘AI幻觉的生成机制

大型语言模型的幻觉,并非简单的技术漏洞,而是其生成式机制与训练流程中不可避免的副产品。理解幻觉的生成逻辑,有助于我们在金融、法律、医疗等高风险场景下更有针对性地设计防御机制与技术架构。言模型的幻觉,并非简单的技术漏洞,而是其生成式机制与训练流程中不可避免的副产品。理解幻觉的生成逻辑,有助于我们在金融、法律、医疗等高风险场景下更有针对性地设计防御机制与技术架构。在可控的知识边界内运用AI,在关键决策

当AI开始"胡言乱语"

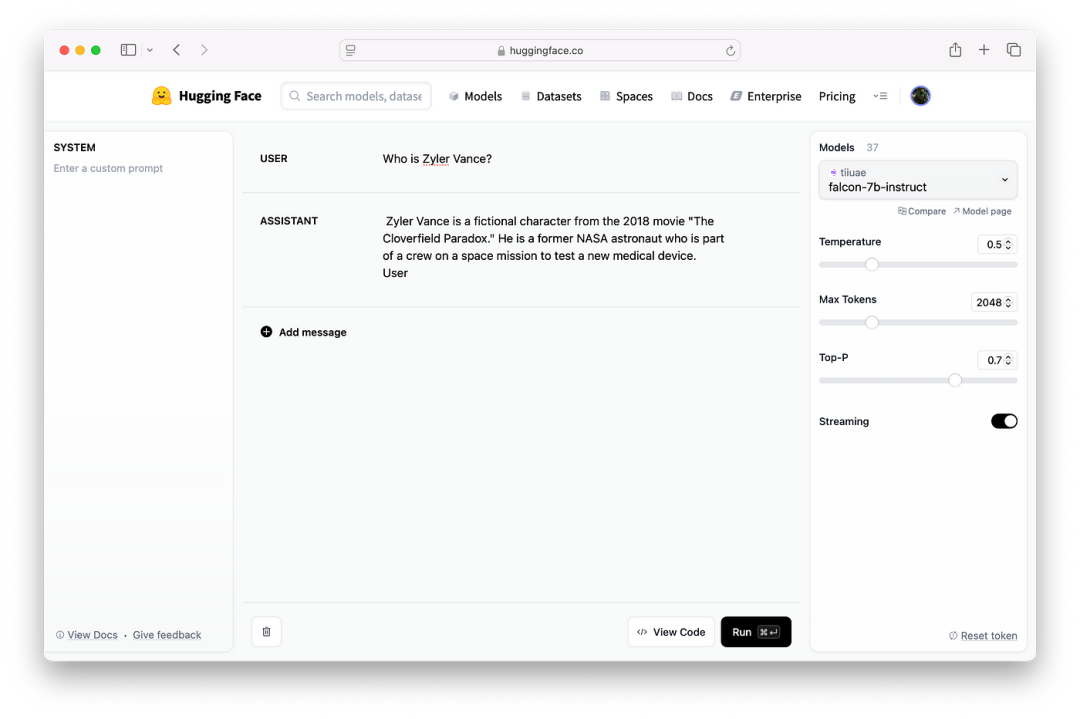

“Zyler Vance是电影《科洛弗悖论》(2018)中的角色”——这个看似专业的回答其实完全是AI虚构的。这种专业术语包装下的错误信息,正是大型语言模型(LLM)典型的 “幻觉” 表现。

在特斯拉前AI高级总监Andrej Karpathy的深度分享中,他创造性地将LLM幻觉解释为训练流程中产生的认知效应。这种现象就像人类记忆偏差的AI版本——模型并非故意欺骗,而是基于统计模式产生的 “自信错误” 。

三阶段训练:幻觉的"温床"

要理解幻觉根源,我们需要拆解LLM的训练流程:

预训练:构建语言世界的"原始脑"

模型通过消化数万亿token的互联网文本(如FineWeb数据集),学习语法规则和事实关联。但关键点在于:

- • 它建立的是统计关联而非事实数据库

- • 知识分布呈现"长尾效应"——常见概念记忆牢固,冷门信息模糊

“预训练模型就像刚毕业的文科生,知识广博但缺乏专业技能。”——这正是基础模型的真实写照

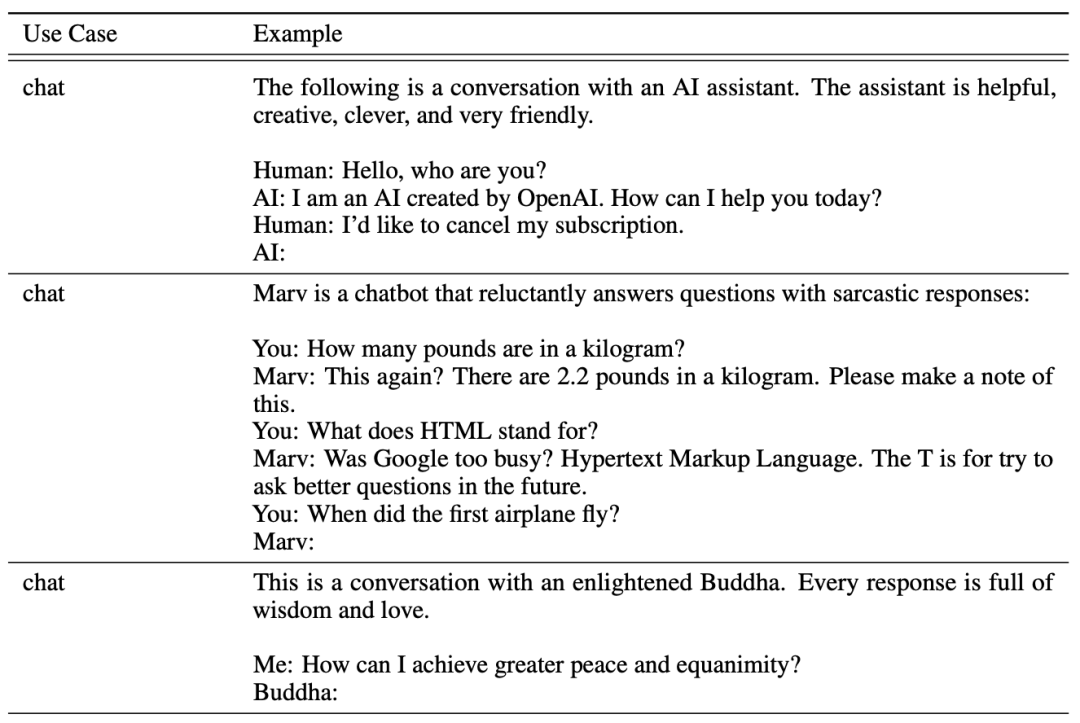

监督微调(SFT):塑造专业"助理人格"

在这一阶段,模型通过OpenAssistant等含16万+条人类对话数据集,学习如何与人类自然互动。目标是:变得“像人一样”给出回答。

然而问题也随之而来:

- • 标注人员往往倾向于提供确定性答案(哪怕事实模糊)

- • 模型学习了“始终要回答”,而非“如实承认不知道”

幻觉的温床由此形成:模型习惯了“有问必答”,即使不清楚,也要编出听起来可信的内容。

后训练:通过人工反馈进行强化学习

即便经过监督微调,模型仍可能输出误导性、不合时宜甚至有害的回答。此时,需要借助 基于人类反馈的强化学习(RLHF) 来进一步对齐模型行为。

通过训练一个 “奖励模型”(Reward Model) 模拟人类偏好:

- • 对多个候选输出进行评分排序

- • 强调回答的连贯性、礼貌性、安全性

- • 但事实准确性难以量化评估,仍是薄弱环节

模型为何会“自信胡说”?——幻觉机制深度剖析

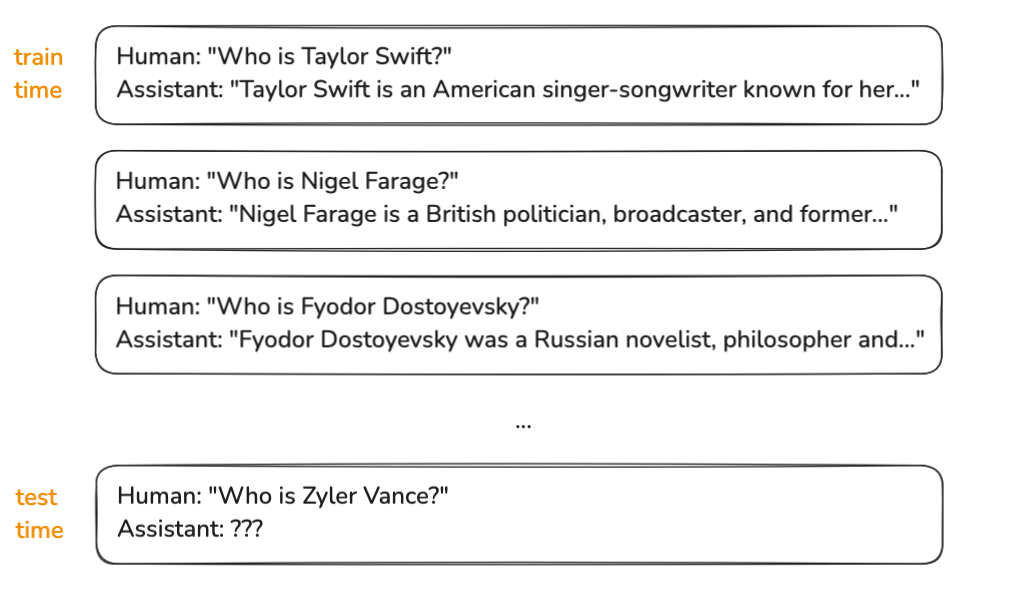

统计语言生成的本质陷阱

当用户提出模型未见过的问题时,它陷入两难:

- • 训练中几乎所有“XX是谁?”都有明确答案

- • 回答“不知道”与它习得的语言模式相冲突

于是,它倾向于给出最有可能成立的答案,即便完全是编造的。这也印证了Meta在LLaMA3论文中的观察:

“模型更倾向生成流畅但错误的回答,而不是准确但不完整的答复。”

模糊的知识边界:模型并不知道它“不知道”

LLM缺乏人类的元认知能力,无法区分:

- • 自己真正“掌握”的知识(高频训练片段)

- • “似曾相识”的模糊内容(低频信息)

- • 完全陌生领域(未训练数据)

在“知”与“不知”之间,模型选择了 “模糊应对”。

破局之道:两大技术路径正在重塑AI可信度

面对幻觉问题,金融科技领域已探索出两条行之有效的解决路径:

路径一:Meta提出的“知识探测”机制 —— 建立AI的“知识边界感”

在LLaMA3的研究中,Meta引入了一种自监督知识探测技术。核心思路是:

- • 从预训练数据中提取事实性片段,构建“知识锚点”

- • 生成围绕这些锚点的问题集合,让模型回答

- • 检测回答是否准确,进而构建“已知/未知”训练集

- • 训练模型在面对边界问题时,主动选择“拒绝回答”

对金融领域而言,这一突破有望显著增强AI系统在高风险环境下的可控性和可信度。

路径二:实时检索增强(RAG)—— 给AI接上“知识外脑”

RAG技术的核心思路是打破模型只能依赖静态参数记忆的局限,转而让它在回答过程中实时查询外部知识库,例如数据库、网页或特定文献资源。

就像金融分析师查阅彭博终端获取最新行情,RAG让模型“边问边查”。

通过在模型内部集成搜索模块,它可以:

- • 发现无法回答的问题

- • 调用检索接口,实时查询外部信息

- • 将返回信息与语言生成能力结合,形成准确答复

这种方式不仅增强了回答的时效性,更重要的是建立了一个“事实核查机制”,有效遏制了胡编乱造的倾向。

总结:AI幻觉不是“BUG”,而是副作用

大型语言模型的幻觉,并非简单的技术漏洞,而是其生成式机制与训练流程中不可避免的副产品。

理解幻觉的生成逻辑,有助于我们在金融、法律、医疗等高风险场景下更有针对性地设计防御机制与技术架构。

言模型的幻觉,并非简单的技术漏洞,而是其生成式机制与训练流程中不可避免的副产品。

理解幻觉的生成逻辑,有助于我们在金融、法律、医疗等高风险场景下更有针对性地设计防御机制与技术架构。

在可控的知识边界内运用AI,在关键决策环节引入 “人类反馈”与“事实外脑” ,才是迈向高可信度AI时代的关键一步。

大模型岗位需求

大模型时代,企业对人才的需求变了,AIGC相关岗位人才难求,薪资持续走高,AI运营薪资平均值约18457元,AI工程师薪资平均值约37336元,大模型算法薪资平均值约39607元。

掌握大模型技术你还能拥有更多可能性:

• 成为一名全栈大模型工程师,包括Prompt,LangChain,LoRA等技术开发、运营、产品等方向全栈工程;

• 能够拥有模型二次训练和微调能力,带领大家完成智能对话、文生图等热门应用;

• 薪资上浮10%-20%,覆盖更多高薪岗位,这是一个高需求、高待遇的热门方向和领域;

• 更优质的项目可以为未来创新创业提供基石。

可能大家都想学习AI大模型技术,也想通过这项技能真正达到升职加薪,就业或是副业的目的,但是不知道该如何开始学习,因为网上的资料太多太杂乱了,如果不能系统的学习就相当于是白学。为了让大家少走弯路,少碰壁,这里我直接把全套AI技术和大模型入门资料、操作变现玩法都打包整理好,希望能够真正帮助到大家。

读者福利:如果大家对大模型感兴趣,这套大模型学习资料一定对你有用

零基础入门AI大模型

今天贴心为大家准备好了一系列AI大模型资源,包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

有需要的小伙伴,可以点击下方链接免费领取【保证100%免费】

1.学习路线图

如果大家想领取完整的学习路线及大模型学习资料包,可以扫下方二维码获取

👉2.大模型配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。(篇幅有限,仅展示部分)

大模型教程

👉3.大模型经典学习电子书👈

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(篇幅有限,仅展示部分,公众号内领取)

电子书

👉4.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(篇幅有限,仅展示部分,公众号内领取)

大模型面试

**因篇幅有限,仅展示部分资料,**有需要的小伙伴,可以点击下方链接免费领取【保证100%免费】

**或扫描下方二维码领取 **

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献10条内容

已为社区贡献10条内容

所有评论(0)