掌握CIFAR-10图像分类数据集:深度学习实践指南

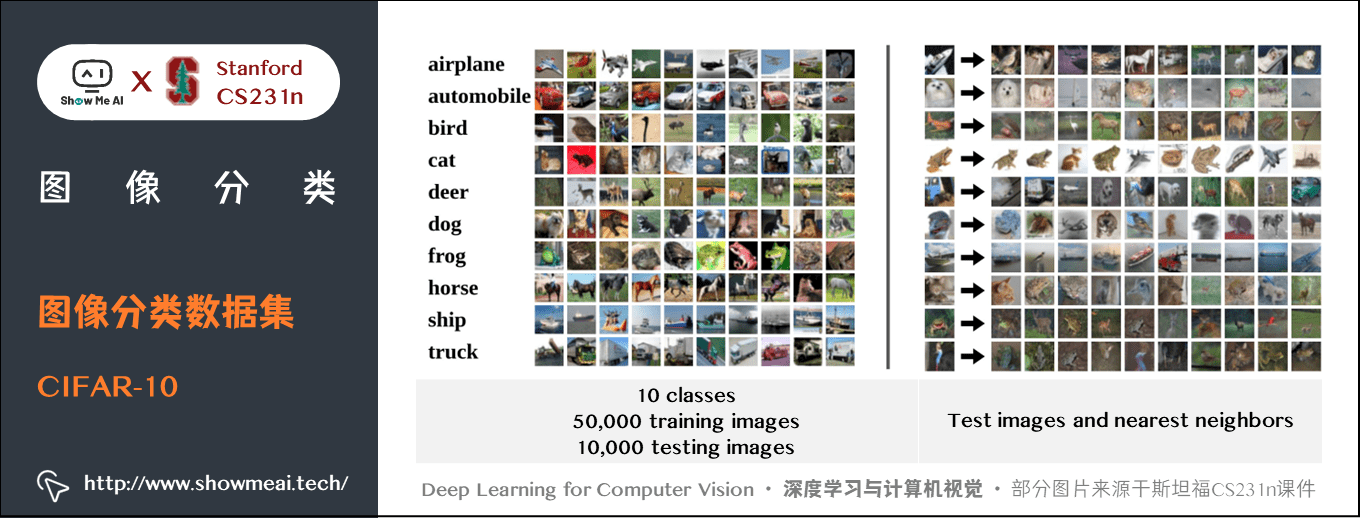

CIFAR-10是一个广泛使用的数据集,由10个不同类别的60,000张32x32彩色图像组成,包含汽车、鸟、猫、鹿、狗、青蛙、马、船和卡车等类别。每个类别有6,000张图像,其中5,000张用作训练,1,000张用作测试。数据集的来源是加拿大高级研究所的机器学习组。CIFAR-10数据集在机器学习和深度学习中的重要性显而易见,因为它是一个实际场景的图像分类问题的标准数据集,被广泛应用于评估各种图

简介:CIFAR-10是计算机视觉领域的关键图像分类数据集,包含10个类别、60,000张32x32像素的彩色图像。它被广泛用于深度学习和机器学习研究,特别是模型的初步实验和性能基准测试。数据集分为训练集和测试集,每个类别图像数量相同。处理该数据集的步骤包括数据预处理、模型构建、训练、评估和调优。Python是最常用的处理语言,借助TensorFlow、PyTorch等框架,研究人员可以深入学习和实践图像识别技术。

1. CIFAR-10数据集介绍

CIFAR-10是一个广泛使用的数据集,由10个不同类别的60,000张32x32彩色图像组成,包含汽车、鸟、猫、鹿、狗、青蛙、马、船和卡车等类别。每个类别有6,000张图像,其中5,000张用作训练,1,000张用作测试。数据集的来源是加拿大高级研究所的机器学习组。

CIFAR-10数据集在机器学习和深度学习中的重要性显而易见,因为它是一个实际场景的图像分类问题的标准数据集,被广泛应用于评估各种图像识别算法的性能。它相对于其他数据集,例如MNIST,更加复杂,因为图像不再是简单的数字,而是自然场景下的物体,更接近真实世界的图像识别任务。

接下来的章节,我们将深入了解如何在计算机视觉中应用图像分类,并通过CIFAR-10数据集来实践深度学习模型的构建、优化及评估过程。

2. 计算机视觉中的图像分类

2.1 图像分类的基本概念

2.1.1 图像分类的定义和意义

图像分类是计算机视觉领域的基础任务之一,它指的是通过算法自动识别和分类数字图像中的对象或场景。图像分类的目的是将图像映射到几个类别中的某一个,这些类别通常被预先定义并训练有素。图像分类对于许多实际应用场景至关重要,例如自动驾驶车辆中的交通标志识别、医学影像分析中的病变检测、以及安防系统中的人脸识别等。

随着智能手机和数字相机的普及,图像数据的量呈爆炸性增长。有效地管理和理解这些数据要求计算机能够以接近人类的方式解释图像内容。图像分类作为理解视觉内容的第一步,是许多视觉任务如物体检测、图像分割和场景理解的基础。

2.1.2 图像分类的发展历程

图像分类技术自20世纪60年代起就已存在,最初是基于人工规则和简单特征的手工分类方法。这些方法依赖于领域专家定义的规则和特征,但受限于特征提取的复杂性和准确性。到了20世纪90年代,随着机器学习方法的引入,图像分类开始通过训练数据来自动学习特征。特别是支持向量机(SVM)和决策树等算法在图像分类任务中取得了重大进展。

进入21世纪,随着深度学习技术的发展,尤其是卷积神经网络(CNN)的兴起,图像分类领域发生了革命性的变化。深度学习模型能够自动从原始像素数据中学习高层次的特征表示,极大地提升了分类的准确性和泛化能力。

2.2 图像分类的挑战与方法

2.2.1 图像分类面临的挑战

尽管图像分类技术已经取得了显著的进步,但实际应用中依然面临许多挑战。例如,图像的分辨率、视角、光照条件、遮挡、背景复杂度等因素都可能对分类性能产生负面影响。此外,数据的多样性和不平衡性也给分类带来了额外的难题。在一些特定场景中,如医疗影像分析,对分类准确性有着极高的要求,任何误分类都可能导致严重后果。

2.2.2 常用的图像分类方法概述

目前,图像分类方法主要分为传统机器学习方法和基于深度学习的方法。传统的机器学习方法通常需要人工设计和提取特征,然后使用分类器(如SVM、k近邻算法等)进行分类。这种方法依赖于特征的选取,并且在面对大数据集时通常需要大量的人力和时间成本。

基于深度学习的方法,尤其是卷积神经网络(CNN),已经成为了图像分类任务的主流。CNN通过学习多层非线性特征转换,能够自动提取图像的层次化特征表示,对图像中的对象和场景进行准确分类。在CIFAR-10数据集这样的复杂图像分类任务中,CNN及其变种(如残差网络、密集连接网络等)均取得了显著的性能。

# 一个简单的卷积神经网络结构示例(使用Keras构建)

from keras.models import Sequential

from keras.layers import Conv2D, MaxPooling2D, Flatten, Dense

model = Sequential([

Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)),

MaxPooling2D((2, 2)),

Conv2D(64, (3, 3), activation='relu'),

MaxPooling2D((2, 2)),

Flatten(),

Dense(64, activation='relu'),

Dense(10, activation='softmax')

])

# 参数说明:

# - Conv2D: 卷积层,32表示卷积核的数量,(3, 3)是卷积核大小,activation='relu'是激活函数。

# - MaxPooling2D: 池化层,用于降低特征维度。

# - Flatten: 将多维输入一维化。

# - Dense: 全连接层,64是神经元数量,activation='relu'是激活函数。

# - 最后一层 Dense(10, activation='softmax') 是输出层,10个神经元分别对应CIFAR-10的10个类别。

在未来的图像分类研究中,提高模型的泛化能力、减少计算成本和增强对小样本数据的学习能力将是主要的研究方向。同时,跨模态学习和无监督/半监督学习等技术也被广泛期待能够在有限标记数据的情况下实现更加有效的图像分类。

3. CIFAR-10数据集的组成与结构

3.1 数据集的详细组成

3.1.1 数据集的图像类别和数量

CIFAR-10数据集由60000张32x32彩色图像组成,这些图像被分为10个互斥类别,每个类别包含6000张图像。这些类别是飞机(airplane)、汽车(automobile)、鸟(bird)、猫(cat)、鹿(deer)、狗(dog)、青蛙(frog)、马(horse)、船(ship)和卡车(truck)。这个数据集的多样性在于它包含了许多日常生活中常见的物体,这使得训练模型在现实世界中具有更好的泛化能力。

3.1.2 每类图像的特征和应用场景

每一类图像都有其独特的特征和潜在的应用场景。例如,飞机和汽车类别的图像可以用于自动驾驶车辆的视觉系统训练,猫和狗类别的图像可以用于宠物识别,鸟类的图像可以用于生物多样性监测等。在机器学习模型的设计和训练过程中,理解每类图像的特点有助于选择合适的模型结构和参数。

3.2 数据集的文件组织形式

3.2.1 训练集与测试集的划分

CIFAR-10数据集被分为两个主要的集合:训练集和测试集。训练集包含了50000张图像,而测试集包含了10000张图像。这种划分确保了模型在训练过程中可以看到足够的数据,同时保留了足够的数据用于评估模型的性能。训练集和测试集的划分是通过随机分配来实现的,以确保它们在统计上的代表性。

3.2.2 数据标注的格式和规范

每张图像都有一个与之对应的标签,标识了该图像所属于的类别。这些标签以0到9之间的整数形式存在,0代表飞机,1代表汽车,依此类推直到9代表卡车。在实际应用中,这些标签通常以文件的形式存储,如CSV或者特定格式的文本文件。每个标签文件中的条目与图像文件列表一一对应。

# CIFAR-10标签文件示例

# 这是CSV格式的标签文件,每行对应一张图像的标签

# label_1.csv

0,0,0,1,1,2,2,3,3,4,...

# label_2.csv

5,6,7,7,8,8,9,9,9,9,...

以下是一段用于加载CIFAR-10数据集并展示前几幅图像和对应标签的Python代码:

import matplotlib.pyplot as plt

import numpy as np

import pickle

import os

# CIFAR-10数据集文件路径

cifar10_path = 'cifar-10-batches-py/'

# 定义函数加载CIFAR-10数据集

def load_cifar10_data(cifar10_path):

data_batch_1 = pickle.load(open(os.path.join(cifar10_path, 'data_batch_1'), 'rb'))

data_batch_2 = pickle.load(open(os.path.join(cifar10_path, 'data_batch_2'), 'rb'))

test_data = pickle.load(open(os.path.join(cifar10_path, 'test_batch'), 'rb'))

# 创建一个字典来存储数据集

cifar10_data = {

'data_batch_1': data_batch_1,

'data_batch_2': data_batch_2,

'test_batch': test_data

}

return cifar10_data

# 加载数据集

cifar10_data = load_cifar10_data(cifar10_path)

# 展示前10张图像及标签

def show_images(images, labels):

fig, axes = plt.subplots(2, 5, figsize=(16, 5))

for i, image in enumerate(images[:10]):

ax = axes[i // 5, i % 5]

ax.imshow(image)

ax.set_title(f"Label: {labels[i]}")

ax.axis('off')

plt.show()

# 获取数据集的前10张图像和标签

sample_data = cifar10_data['data_batch_1']['data'][:10]

sample_labels = cifar10_data['data_batch_1']['labels'][:10]

# 将数据转换为合适的格式

sample_images = np.reshape(sample_data, (10, 3, 32, 32)).transpose(0, 2, 3, 1)

# 展示图像

show_images(sample_images, sample_labels)

本段代码首先定义了两个函数: load_cifar10_data 用于加载CIFAR-10数据集, show_images 用于展示图像和对应的标签。在 show_images 函数中,我们使用了matplotlib库来绘制图像。通过执行上述代码,我们可以清楚地看到CIFAR-10数据集图像的真实面貌以及它们所对应的标签,为进一步的分析和处理提供了直观的理解。

4. ```

第四章:深度学习模型处理CIFAR-10的步骤

在计算机视觉领域,深度学习模型已经成为处理图像分类任务的核心技术之一。本章将详细介绍如何使用深度学习模型来处理CIFAR-10数据集,包括数据准备、模型训练与验证等关键步骤。

4.1 模型构建前的数据准备

4.1.1 数据集的下载和加载

首先,我们需要下载CIFAR-10数据集。该数据集可以通过多种方式获得,其中一种常用的方式是使用Python库,例如 tensorflow 或 keras 中的内置函数直接下载。

import tensorflow as tf

# 使用tensorflow内置函数下载CIFAR-10数据集

(x_train, y_train), (x_test, y_test) = tf.keras.datasets.cifar10.load_data()

下载后,我们需要加载数据集到内存中。CIFAR-10数据集的训练集和测试集分别包含50000张和10000张图片,每张图片的大小为32x32像素,颜色通道为3(RGB)。

4.1.2 数据集的预处理和划分

为了提高模型的训练效率和性能,通常需要对数据集进行预处理。预处理步骤包括归一化处理,数据增强等。

from tensorflow.keras.utils import to_categorical

# 归一化处理

x_train = x_train.astype('float32') / 255.0

x_test = x_test.astype('float32') / 255.0

# 将标签转换为one-hot编码

y_train = to_categorical(y_train, 10)

y_test = to_categorical(y_test, 10)

另外,数据集需要被划分为训练集、验证集和测试集。在本案例中,我们保留一部分训练数据作为验证集,来监控模型的训练过程并防止过拟合。

from sklearn.model_selection import train_test_split

# 划分训练集和验证集

x_train, x_val, y_train, y_val = train_test_split(x_train, y_train, test_size=0.1, random_state=42)

4.2 模型的训练与验证流程

4.2.1 模型的训练策略选择

对于深度学习模型,训练策略包括选择合适的损失函数、优化器和学习率等。以CIFAR-10为例,我们通常使用交叉熵损失函数( categorical_crossentropy ),使用如Adam优化器,并选取合适的学习率。

from tensorflow.keras.optimizers import Adam

# 编译模型,设定损失函数和优化器

model.compile(loss='categorical_crossentropy', optimizer=Adam(lr=0.001), metrics=['accuracy'])

4.2.2 验证集的使用和效果评估

在训练过程中,我们使用验证集来评估模型的性能。通过监控验证集上的准确率和损失值,可以调整模型的超参数,如学习率或训练周期数(epochs)。

# 训练模型,并在验证集上评估

history = model.fit(x_train, y_train, batch_size=64, epochs=100, validation_data=(x_val, y_val))

在训练结束后,我们使用测试集来评估模型在未见过的数据上的最终性能。测试集的准确率通常反映了模型的泛化能力。

# 在测试集上评估模型性能

test_loss, test_accuracy = model.evaluate(x_test, y_test)

print("Test accuracy:", test_accuracy)

通过这种方式,深度学习模型处理CIFAR-10的整个流程形成了一个从数据准备到模型训练再到评估的循环体系。每一个步骤都紧密相连,且每个环节的优化都会影响最终的模型性能。

表格展示CIFAR-10数据集的类别以及相关信息:

| 类别编号 | 类别名称 | 图片数量 | 特征描述 |

|----------|----------|----------|----------|

| 0 | 飞机 | 6000 | 多角度、各种飞行状态的飞机 |

| 1 | 汽车 | 6000 | 常见的汽车类型,正面和侧面视图 |

| ... | ... | ... | ... |

| 9 | 卡车 | 6000 | 多种类型的卡车和拖车 |

mermaid流程图展示深度学习模型训练和验证的流程:

```mermaid

graph LR

A[数据准备] --> B[模型构建]

B --> C[模型训练]

C --> D[使用验证集进行评估]

D --> E{是否达到预期效果?}

E -->|是| F[使用测试集评估模型]

E -->|否| C[调整训练策略]

F --> G[模型部署]

以上代码块和内容结合了对数据的下载、加载、预处理等步骤的逻辑分析,也展示了模型构建、训练与验证的流程,并以表格和流程图形式增强了内容的可视化和理解度。

5. 深度学习模型的优化与实践

在处理深度学习模型时,优化与实践是至关重要的环节。本章节将深入探讨数据预处理技术、深度学习模型的构建与优化,以及模型评估与调优的方法,并通过深度学习框架实战案例,展示如何应用这些理论和技术解决实际问题。

5.1 数据预处理技术

5.1.1 数据归一化的理论与应用

数据归一化是机器学习和深度学习中极为重要的预处理步骤。归一化能够将数据特征缩放到一个统一的范围,通常是从0到1或者将数据的均值变为0,方差变为1。这样做可以加快模型的收敛速度,提升训练效率。

在CIFAR-10数据集上应用归一化,可以通过将所有像素值除以255来实现,因为像素值的范围是0到255。下面的Python代码展示了如何进行这一简单的操作:

import numpy as np

# 假设 cifar10_data 是一个包含图像数据的 NumPy 数组,形状为 (n_samples, height, width, channels)

cifar10_data = ... # 加载CIFAR-10数据集

# 将数据归一化到0-1范围内

cifar10_data_normalized = cifar10_data / 255.0

归一化后的数据集可以直接用于模型训练,为后续的深度学习模型打下良好的基础。

5.1.2 数据增强的策略和效果

数据增强是一种通过生成训练数据的变形版本来人为增加数据集大小的方法。它可以帮助模型减少过拟合,并提升模型在实际应用中的泛化能力。对于CIFAR-10数据集,常见的数据增强策略包括旋转、平移、缩放、水平翻转等。

下面的Python代码使用了 tf.keras 进行数据增强:

from tensorflow.keras.preprocessing.image import ImageDataGenerator

# 创建一个ImageDataGenerator实例,应用一些常见的数据增强选项

datagen = ImageDataGenerator(

rotation_range=20,

width_shift_range=0.2,

height_shift_range=0.2,

horizontal_flip=True

)

# 假设 train_images 是一个NumPy数组,包含训练图像

train_images = ... # 加载训练图像数据

# 使用数据增强生成器来训练模型

train_generator = datagen.flow(train_images, batch_size=32, shuffle=True)

通过上述步骤,我们可以获得一个无限的数据流,其中的数据经过随机变换,使得模型在训练过程中总是面临新的挑战。

5.2 深度学习模型的构建与优化

5.2.1 卷积神经网络(CNN)的原理和结构

卷积神经网络(CNN)是处理图像数据的强有力模型。CNN通过卷积层自动和适应性地学习空间层级特征。一个典型的CNN模型包括卷积层、池化层、全连接层等。卷积层用于特征提取,池化层用于降低特征的空间维度,全连接层用于分类。

下面的伪代码描述了一个基本的CNN结构:

Model: "CNN_model"

Layer (type) Output Shape Param #

conv2d (Conv2D) (None, 32, 32, 32) 896

max_pooling2d (MaxPooling2D) (None, 16, 16, 32) 0

flatten (Flatten) (None, 8192) 0

dense (Dense) (None, 128) 1048704

dense_1 (Dense) (None, 10) 1290

Total params: 1,050,890

Trainable params: 1,050,890

Non-trainable params: 0

5.2.2 模型训练中的优化器选择

优化器是决定网络权重更新策略的关键组件。在深度学习中,常见的优化器包括SGD、Adam、RMSprop等。Adam优化器因其自适应调整学习率的能力而在实践中广受欢迎。

以下是设置Adam优化器的代码示例:

from tensorflow.keras.optimizers import Adam

# 创建一个Adam优化器实例

optimizer = Adam(lr=0.001)

# 假设 model 是一个构建好的CNN模型

model = ... # 构建CNN模型

# 编译模型,指定优化器、损失函数和评估指标

model.compile(optimizer=optimizer, loss='sparse_categorical_crossentropy', metrics=['accuracy'])

5.2.3 损失函数和学习率的策略

损失函数衡量的是模型的预测值和真实值之间的差异。对于分类问题,通常使用交叉熵损失函数。学习率是控制模型权重更新幅度的超参数,它对于模型训练的速度和稳定性至关重要。通过学习率衰减或周期性调整,可以在训练过程中精细地控制学习率。

例如,使用学习率衰减策略的代码如下:

from tensorflow.keras.optimizers.schedules import ExponentialDecay

# 创建一个学习率衰减策略

initial_learning_rate = 0.01

lr_schedule = ExponentialDecay(initial_learning_rate, decay_steps=100000, decay_rate=0.9)

# 使用学习率衰减策略更新Adam优化器

optimizer = Adam(learning_rate=lr_schedule)

通过以上策略的应用,我们可以在模型训练的过程中取得更好的效果。

5.3 模型评估与调优

5.3.1 常见的模型评估指标

模型评估指标用于衡量模型性能的好坏。常用的评估指标包括准确率、精确率、召回率、F1分数等。在分类任务中,准确率是最直观的评价标准,但是它不能完全反映模型的性能,尤其是在类别不均衡的数据集上。

Python代码示例,评估模型性能:

# 假设 test_images 和 test_labels 分别是测试图像和标签

test_images = ... # 加载测试图像数据

test_labels = ... # 加载测试图像标签

# 使用模型进行预测

predictions = model.predict(test_images)

# 计算准确率

accuracy = np.mean(np.equal(np.argmax(predictions, axis=1), test_labels))

print(f'Accuracy: {accuracy:.4f}')

5.3.2 模型调优的策略和技巧

模型调优旨在通过调整模型的超参数来改善性能。一些常见的调优策略包括网格搜索、随机搜索和贝叶斯优化等。网格搜索通过尝试所有可能的参数组合来找到最优解,而随机搜索通过随机选择参数来避免计算开销。贝叶斯优化是一种更高效的策略,它根据已评估参数的性能来智能地选择下一个参数组合。

例如,使用随机搜索进行超参数调优的伪代码如下:

from sklearn.model_selection import RandomizedSearchCV

# 定义一个超参数空间

param_distributions = {

'optimizer': ['Adam', 'RMSprop'],

'learning_rate': [0.001, 0.01, 0.1],

# 其他参数...

}

# 使用随机搜索进行超参数调优

random_search = RandomizedSearchCV(estimator=model, param_distributions=param_distributions, n_iter=10, cv=3)

random_search.fit(train_images, train_labels)

# 输出最佳参数组合

best_params = random_search.best_params_

print(f'Best parameters: {best_params}')

通过上述步骤,我们可以找到更优的模型配置,提高模型在实际任务中的表现。

5.4 深度学习框架实战

5.4.1 TensorFlow框架的介绍和应用

TensorFlow是一个开源的机器学习库,由Google开发。它提供了强大的API来构建和训练深度学习模型。TensorFlow的优势在于其灵活性和可扩展性,广泛应用于图像识别、自然语言处理等领域。

下面的代码展示了如何使用TensorFlow构建一个简单的CNN模型:

import tensorflow as tf

# 创建一个序贯模型

model = tf.keras.models.Sequential([

tf.keras.layers.Conv2D(32, (3, 3), activation='relu', input_shape=(32, 32, 3)),

tf.keras.layers.MaxPooling2D(2, 2),

tf.keras.layers.Conv2D(64, (3, 3), activation='relu'),

tf.keras.layers.MaxPooling2D(2, 2),

tf.keras.layers.Conv2D(64, (3, 3), activation='relu'),

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(64, activation='relu'),

tf.keras.layers.Dense(10, activation='softmax')

])

# 打印模型概况

model.summary()

5.4.2 PyTorch框架的特点和案例分析

PyTorch是一个由Facebook开发的开源机器学习库,它以其动态计算图和易用性而受到研究者和开发者的青睐。PyTorch的 torchvision 模块提供了处理图像数据的便利工具。

下面是使用PyTorch构建CNN模型的代码示例:

import torch

import torch.nn as nn

import torchvision.transforms as transforms

from torchvision.datasets import CIFAR10

from torch.utils.data import DataLoader

# 定义CNN模型

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(3, 32, kernel_size=3, padding=1)

self.conv2 = nn.Conv2d(32, 64, kernel_size=3, padding=1)

self.conv3 = nn.Conv2d(64, 64, kernel_size=3, padding=1)

self.fc1 = nn.Linear(64 * 8 * 8, 64)

self.fc2 = nn.Linear(64, 10)

def forward(self, x):

x = torch.relu(self.conv1(x))

x = torch.relu(self.conv2(x))

x = torch.relu(self.conv3(x))

x = torch.flatten(x, 1)

x = torch.relu(self.fc1(x))

x = self.fc2(x)

return x

# 创建模型实例

model = SimpleCNN()

# 打印模型概况

print(model)

通过TensorFlow和PyTorch两个深度学习框架的应用案例,我们可以看到如何构建、训练和评估模型,以及如何将理论知识转化为实际操作。

简介:CIFAR-10是计算机视觉领域的关键图像分类数据集,包含10个类别、60,000张32x32像素的彩色图像。它被广泛用于深度学习和机器学习研究,特别是模型的初步实验和性能基准测试。数据集分为训练集和测试集,每个类别图像数量相同。处理该数据集的步骤包括数据预处理、模型构建、训练、评估和调优。Python是最常用的处理语言,借助TensorFlow、PyTorch等框架,研究人员可以深入学习和实践图像识别技术。

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)