毕业设计:基于知识图谱的百科知识问答平台

毕业设计:基于知识图谱的百科知识问答平台利用深度学习和计算机视觉技术结合知识图谱构建,为用户提供智能化的问答服务。我们通过构建丰富的知识图谱,将知识进行结构化表示,并利用深度学习算法对用户问题进行语义理解和推理。通过计算机视觉技术,我们能够从多媒体内容中提取关键信息,并与知识图谱进行关联,进一步提升问答的质量和准确性。对于计算机专业、软件工程专业、人工智能专业、大数据专业的毕业生而言,它提供了一个

目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于知识图谱的百科知识问答平台

课题背景和意义

传统的百科知识问答平台往往受限于关键词匹配和人工维护的局限性,无法准确理解用户的问题并提供全面、准确的答案。基于知识图谱的百科知识问答平台能够通过构建和应用知识图谱,实现对知识的深度理解和智能推理,提供更准确、个性化的问答服务。这种系统不仅能够满足用户对知识的多样化需求,还能够促进知识的共享和传播,具有重要的教育和社会意义。

实现技术思路

一、算法技术理论

1.1 中文分词

中文自动分词是将连续的汉字序列切分成有意义的词语的过程。与英文不同,中文的分词需要考虑汉字之间的连接关系。在问题生成系统中,句法分析和中文分词的准确性对系统性能起着重要影响。句法分析的好坏直接影响问题生成的质量,而中文分词的准确性决定了系统对中文问句的理解能力。

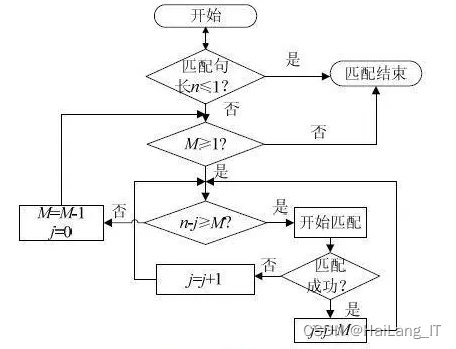

目前,中文自动分词可以分为两大类:基于词典查询的中文分词和基于词频统计的中文分词。基于词典的分词算法包括正向最大匹配算法、逆向最大匹配算法和全切分法。这些算法将待分词的字符串与词典中的词进行匹配,匹配过程中根据最大查询字符串长度进行循环匹配,直到找到匹配成功的词或无法继续匹配为止。

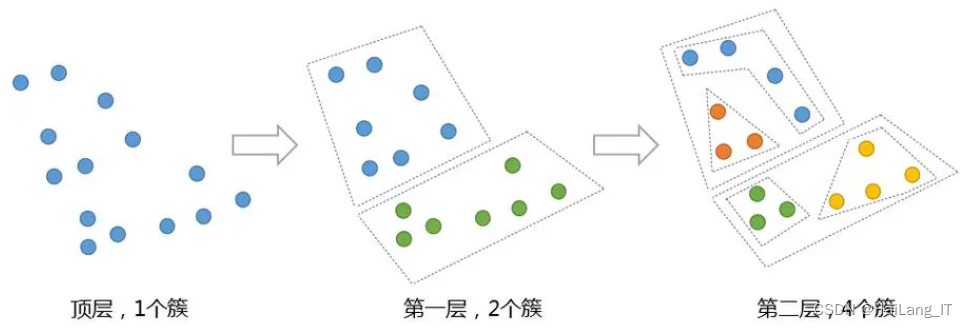

自顶向下和自底向上都是分治算法,它们通常使用递归方法生成树。自顶向下算法首先建立三个集合:后代集合、前代集合和关系边集合。算法开始时,将前代集合和关系边集合初始化为空,后代集合包含要生成树的所有节点。然后从后代集合中选择一个节点作为根节点,并将其插入前代集合中,同时从后代集合中移除。将与根节点相关联的边插入关系边集合。然后递归执行以下步骤,直到所有节点都从后代集合中移除:从后代集合中选择一个节点x,它与前代节点之间有最长的边,然后将x从后代集合中移除,并将其加入前代集合中。同时,将x与前代集合之间的最长边插入关系边集合。

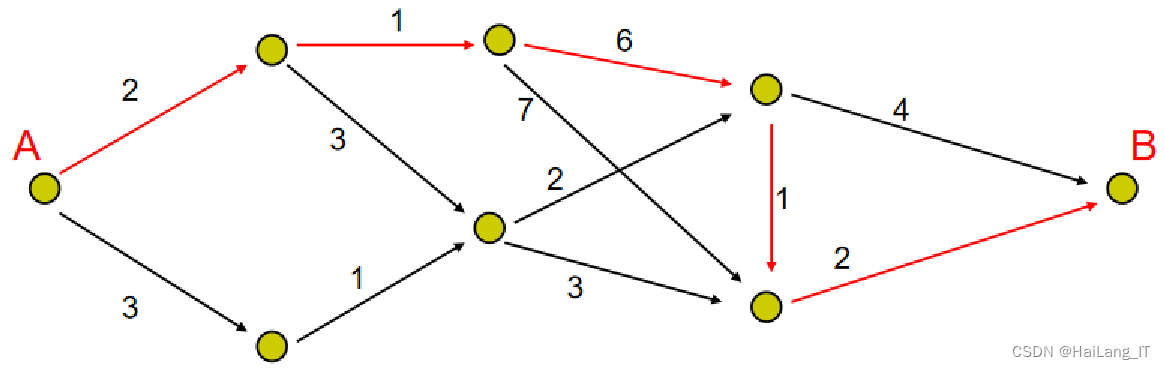

最大生成树算法是用于寻找图中权重之和最大的生成树的算法。常见的算法是基于Kruskal算法或Prim算法的变体。Kruskal算法按边权重从大到小排序,逐步选择边并合并连通分量,直到生成树完成。Prim算法从一个起始节点开始,选择与未访问节点相连的权重最大边,并标记已访问的节点,重复这个过程直到所有节点都被访问。这些算法通过贪心策略,确保生成的树具有最大的权重和。最大生成树算法在网络设计和最优路径规划等领域有广泛应用。

1.2 文本蕴含

文本蕴含是指判断句子A是否可以从句子B推导出来的关系。如果可以推导,则A和B之间存在蕴含关系;如果不能推导,则它们是不相关的。蕴含关系在问句自动生成系统中起着重要作用,可以用于深层识别被生成句子的角色。同时使用相互蕴含的句子来生成同一个问句可以提高问句的准确度和有效性。目前,基于英文的蕴含算法和系统比较多。其中,最基本的方法是计算两个句子的单词覆盖率,这只是设定一个最低标准线。另一种方法是使用句子最大子串匹配,通过比较两个句子中匹配的最长字符串的长度与预设的长度来确定它们是否存在蕴含关系。

1.3 知识图谱

知识图谱存储和查询在基于知识图谱的百科知识问答平台中起着重要的作用。为了实现这一功能,可以选择适合的图数据库,如Neo4j或GraphDB,用于存储和管理知识图谱中的实体、属性和关系。通过使用图数据库的查询语言(如Cypher),可以编写查询语句来根据用户的问题和查询条件在知识图谱中进行图查询,从而获得问题的答案或相关信息。

知识图谱存储和查询在基于知识图谱的百科知识问答平台中起着关键作用。通过选择适合的图数据库,并使用图查询语言进行查询,可以高效地存储和管理知识图谱的实体、属性和关系,并根据用户的问题和查询条件在知识图谱中进行准确的图查询。借助实体识别、关系抽取和推理等技术,可以丰富知识图谱的内容和关联性,提供更准确和全面的问答服务。

二、 数据集

自制语料资源的过程包括确定语料类型、收集语料、数据清洗和预处理、构建标注集(如果需要)、数据划分和验证、数据增强以及维护和更新。这个过程需要仔细考虑收集渠道和方法,进行数据清洗和预处理以去除噪声,构建适当的标注集,划分数据集以进行训练和评估,并定期维护和更新语料资源。

自制语料资源的关键步骤包括确定语料类型、收集语料、数据清洗和预处理、构建标注集、数据划分和验证,以及维护和更新。这些步骤需要综合考虑数据质量、数据多样性和时效性,并可能涉及人工标注和使用自动化工具进行处理和增强。

import jieba

import jieba.posseg as pseg

# 分词

words = jieba.cut(text)

# 词性标注

tagged_words = pseg.cut(text)

# 提取分词结果和词性

word_list = [word for word in words]

pos_list = [(word, pos) for word, pos in tagged_words]三、实验及结果分析

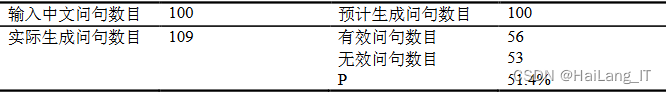

评价问句相关性的等级包括:生成的问句与输入问句完全相关、大部分相关、只有一小部分相关、完全不相关。评价句法的正确性与流畅性包括:生成的问句语法正确、连贯自然;语法正确但句式有偏差;有语法错误;不能接受。评价歧义性包括:生成的问句没有歧义;在给定一定支持信息后问句无歧义;完全歧义。评价两个问句是否关于同一内容包括:两个问句内容不同;内容相同但表达句式不同;内容完全一样。

预计生成的问句数量是根据输入问句中的命名实体数量来设计的,但实际系统生成了109个问句。这是因为不同的输入问句具有不同数量的命名实体,有些问句可能有多个命名实体,而有些问句可能没有被识别出的命名实体。因此,导致了生成问句的数量不同。

相关代码示例:

ef preprocess_text(text):

sentences = sent_tokenize(text)

tokenized_sentences = [word_tokenize(sentence) for sentence in sentences]

tagged_sentences = [pos_tag(tokens) for tokens in tokenized_sentences]

return tagged_sentences

def generate_query(tagged_sentence):

query = ""

for word, pos in tagged_sentence:

if pos.startswith('N'): # 名词

query += f"MATCH (n:{pos}) WHERE n.name = '{word}' "

elif pos.startswith('V'): # 动词

query += f"WITH n MATCH (n)-[:{word.upper()}]->(result) "

query += "RETURN result.name"

return query

def get_user_input():

user_input = input("请输入您的问题:")

return user_input

def display_answer(answer):

print("答案:", answer)最后

我是海浪学长,创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)