知识图谱增强营养健康大模型:迈向改进的管理、可重复性和验证 - RPI等

摘要生成式大型语言模型(LLMs)通过实现快速、类人的文本生成改变了人工智能领域,但它们面临挑战,包括管理不准确的信息生成。诸如提示工程、检索增强生成(RAG)以及整合特定领域知识图谱(KGs)等策略旨在解决这些问题。然而,尤其是在通过Web API使用封闭访问LLM的开发者中,实现实验的管理、可重复性和验证所需水平仍存在挑战,这增加了与外部工具集成的复杂性。为解决这一问题,我们正在探索一种软件架

摘要

生成式大型语言模型(LLMs)通过实现快速、类人的文本生成改变了人工智能领域,但它们面临挑战,包括管理不准确的信息生成。诸如提示工程、检索增强生成(RAG)以及整合特定领域知识图谱(KGs)等策略旨在解决这些问题。然而,尤其是在通过Web API使用封闭访问LLM的开发者中,实现实验的管理、可重复性和验证所需水平仍存在挑战,这增加了与外部工具集成的复杂性。为解决这一问题,我们正在探索一种软件架构,通过优先考虑灵活性和可追溯性来增强LLM工作流程,同时促进更准确和可解释的输出。我们描述了我们采用的方法,并提供了一个营养案例研究,展示了其将大型语言模型(LLMs)与RAG和知识图谱(KGs)整合以获得更强大AI解决方案的能力。

LLM experimentation through knowledge graphs: Towards improved management, repeatability, and verification - ScienceDirect

https://www.sciencedirect.com/science/article/pii/S1570826824000398

核心速览

研究背景

-

研究问题:这篇文章要解决的问题是如何通过知识图谱(Knowledge Graphs, KGs)和检索增强生成(Retrieval-Augmented Generation, RAG)来改进大型语言模型(LLMs)的管理、可重复性和验证。LLMs在生成类似人类的文本方面取得了显著进展,但面临着生成不准确信息的挑战。

-

研究难点:该问题的研究难点包括:实现LLMs实验的管理、可重复性和验证的期望水平,特别是对于通过Web API使用封闭访问LLMs的开发者,这简化了与外部工具的集成。

-

相关工作:该问题的研究相关工作包括:prompt工程、RAG框架和基于权威领域本体的知识图谱(KGs)的使用。现有的RAG框架旨在缓解LLMs响应中的幻觉和过时知识或缺失信息的问题。KGs作为结构化的外部信息源,已被用于增强LLMs的可靠性和可解释性。

研究方法

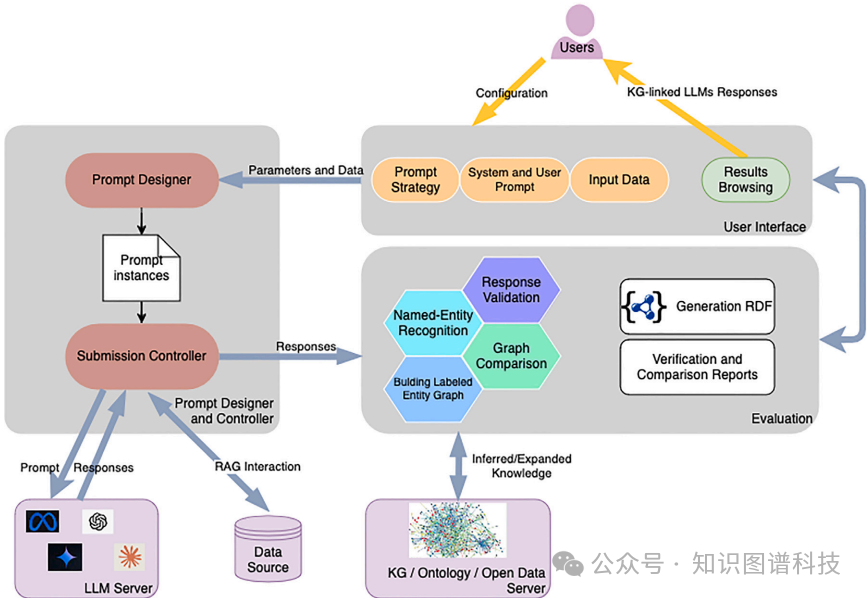

这篇论文提出了一种软件架构,用于增强LLMs的工作流程,优先考虑灵活性、可追溯性和可重复性,同时促进更准确和可解释的输出。具体来说,

-

灵活性和可追溯性:ChatBS-NexGen架构允许用户交互式地定制和组合高级提示策略,而无需编程知识。通过直观的界面,用户可以轻松配置提示策略(如少样本学习、思维链、验证链)、动态槽位的信息告知系统和用户提示,以及输入数据集。此外,还包括设置模型温度、提示重新提交次数和选择不同的LLMs等选项。所有这些特性共同促进了LLMs实验的灵活性。

-

RAG和KG增强的LLMs实验:评估模块旨在通过将LLMs的主要实体与领域知识图谱或开放网络连接起来,进行验证、基准测试和专家分析。实验使用的KG平台是Whyis,一个下一代的、具有动态代理交互的有知觉黑板架构。评估模块包括子模块用于实体识别和构建标记实体图,利用Whyis的高级功能,使跨多个LLMs和单个LLMs的多次重新提交的响应之间的比较成为可能。

-

营养案例研究:使用一个包含100名患者数据的食品和营养领域的数据集进行实验。目标是评估LLMs生成的饮食建议的适用性,考虑到个人因素如性别、年龄、性别、体重、健康指标、慢性疾病诊断以及饮食限制和偏好。

实验设计

-

数据收集:实验使用了包含100名患者数据的食品和营养领域的数据集。每个患者的个人信息包括性别、年龄、性别、体重、健康指标、慢性疾病诊断、饮食限制和偏好等。

-

实验设计:在典型的测试运行中,用户(营养研究组的成员)使用ChatBS-NexGen用户界面输入以下信息和选择数据源:提示策略、LLMs、提示重新提交次数、KG链接等。然后,ChatBS-NexGen执行提示设计子模块,实例化100个提示并提交给选定的LLMs。提交控制器子模块提交(并重新提交10次)每个实例化的提示,接收其响应并将其传递给评估步骤。

-

样本选择:选择了100名患者的数据进行实验,每个患者的提示实例化和重新提交10次。

-

参数配置:用户可以选择不同的提示策略(如少样本学习、思维链、验证链)、LLMs(如GPT-4o mini和Llama 3.1-8B)、提示重新提交次数等。

结果与分析

-

验证结果:在100名患者的实验中,LLMs推荐了483种不同的食物类型,其中178种(36.8%)可以通过FoodKG进行验证。对于30名糖尿病患者,LLMs推荐了260种不同的食物类型,其中123种(47.3%)可以通过FoodKG进行验证。

-

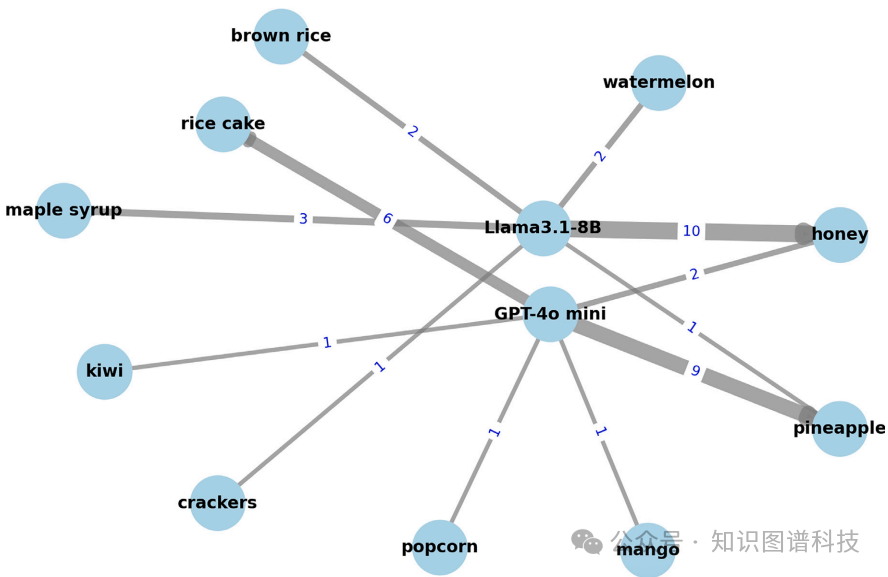

高GI食物的推荐:在推荐的10种高GI(≥50)食物中,LLMs对糖尿病患者提出了不同的建议。例如,Llama 3.1向10名糖尿病患者推荐了“蜂蜜”,占糖尿病患者的33%,而GPT-4o mini推荐了“菠萝”,占30%。

-

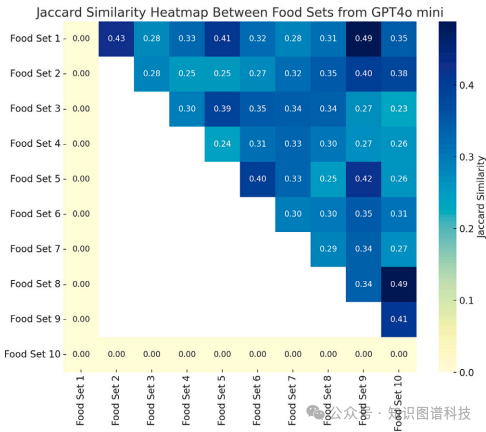

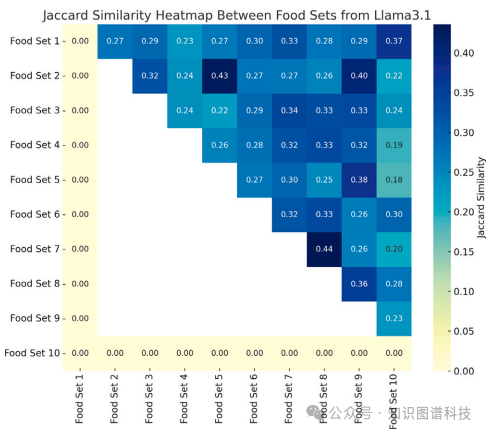

响应一致性:通过计算不同LLMs和同一LLMs的多次响应之间的Jaccard相似系数,发现不同LLMs之间以及同一LLMs的不同响应之间的一致性较低。例如,GPT-4o mini对同一患者的10个响应之间的Jaccard相似系数为0.05,表明只有5%的食物在所有响应中被共享。

总体结论

这篇论文提出了一种新的架构ChatBS-NexGen,用于改进LLMs实验的管理、可重复性和验证。通过结合RAG和KGs,该架构能够提供更准确和可解释的输出,并通过详细的日志记录确保实验的可追溯性。未来的研究方向包括支持多模态输入输出、自动提示策略、与XAI框架的集成、逻辑一致性验证器和对抗场景模拟器等。

论文评价

优点与创新

-

灵活的架构设计:ChatBS-NexGen架构通过直观的界面和模块化的设计,支持多种提示策略、不同的LLM架构、数据输入和实验设置,确保了实验的灵活性。

-

可追溯性:整个实验过程被详细记录,包括时间戳、提示数据、模型版本、响应元数据等,确保了实验的可追溯性。

-

重复性控制:通过日志记录和多次执行,可以重现相同的实验条件,评估LLMs响应的变化,增强了实验的重复性。

-

RAG和KG集成:该架构支持检索增强生成(RAG)和知识图谱(KG)的集成,显著提高了响应的验证性和解释能力。

-

营养案例研究:通过真实的医疗项目案例,展示了该架构在实际应用中的潜力,特别是在处理LLMs生成的饮食建议时,能够识别不适当的推荐和高变异性。

-

多模型支持:支持多种LLMs的交互和评估,增强了平台的通用性和实用性。

不足与反思

-

知识图谱的局限性:在应用领域中,知识图谱的数据不完整和查询构建的复杂性是主要限制因素。许多知识图谱缺乏关键属性或完全缺失,限制了其在详细和可靠分析中的应用。

-

标准化本体的重要性:采用标准化和权威本体对于增强不同系统之间的互操作性至关重要。需要开发方法将详细的溯源元数据嵌入知识图谱中,并展示其在提高可靠性和实用性方面的应用。

-

查询机制的改进:需要改进知识图谱查询机制,简化领域特定数据的检索过程,以便用户更容易使用。

-

未来研究方向:包括支持多模态输入输出、引入自动提示策略、通过与XAI框架集成提供高级解释能力、整合逻辑一致性验证器和对抗场景模拟器、动态集成多样化指标进行上下文评估、关注安全验证和偏见缓解等方面的工作。

关键问题及回答

问题1:ChatBS-NexGen架构如何实现LLMs实验的灵活性和可追溯性?

ChatBS-NexGen架构通过以下方式实现LLMs实验的灵活性和可追溯性:

-

灵活性:用户可以通过直观的界面交互式地定制和组合高级提示策略,如少样本学习、思维链(CoT)、验证链等。用户还可以输入动态槽位和相应的数据集,并设置模型温度、提示重提交次数和选择不同的LLMs。这些功能使得平台能够适应多样化的实验要求和用例。

-

可追溯性:整个实验过程被详细记录,包括时间戳、输入提示、模型版本、响应元数据、实验参数和外部集成等信息。这些日志确保了每一步骤都可以被追踪和审计,从而提高了实验的透明度和可重复性。

问题2:在营养案例研究中,ChatBS-NexGen如何利用知识图谱(KGs)验证LLMs生成的饮食建议?

-

实体识别:首先,ChatBS-NexGen识别出LLMs响应中的食物名称。

-

链接到KG:然后,将这些食物名称链接到FoodKG和WhatToMake本体。FoodKG包含了食物的详细信息,如血糖指数(GI),这些信息用于验证LLMs的建议是否适合特定的健康状况。

-

验证和分析:通过比对FoodKG中的信息,ChatBS-NexGen能够验证LLMs推荐的食物是否合适。例如,对于糖尿病患者,系统可以检查推荐食物的高GI值,并提供相应的反馈。

问题3:ChatBS-NexGen在处理LLMs响应的相似性分析时采用了哪些方法?这些方法揭示了什么?

ChatBS-NexGen采用了两种方法来分析LLMs响应的相似性:

-

跨LLMs比较:通过计算不同LLMs(如Llama-3.1和GPT-4o mini)之间响应的Jaccard相似系数,来比较它们对同一患者的推荐结果。例如,Llama-3.1和GPT-4o mini对同一患者推荐的食品覆盖范围分别为42%和39%。

-

同一LLMs内部比较:通过计算同一LLMs(如GPT-4o mini)多次响应之间的Jaccard相似系数,来评估其一致性。例如,GPT-4o mini对同一患者生成的10个响应的Jaccard相似系数为0.05,表明不同响应之间的一致性很低,推荐结果存在显著差异。

这些方法揭示了LLMs在生成推荐时存在的高变异性和一致性挑战,强调了在管理和验证LLMs响应时需要更多的自动化和结构化工具。

如何学习AI大模型 ?

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。【保证100%免费】🆓

CSDN粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传CSDN,朋友们如果需要可以扫描下方二维码&点击下方CSDN官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉CSDN大礼包:《最新AI大模型学习资源包》免费分享 👈👈

对于0基础小白入门:

如果你是零基础小白,想快速入门大模型是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以根据这些资料规划好学习计划和方向。

👉1.大模型入门学习思维导图👈

要学习一门新的技术,作为新手一定要先学习成长路线图,方向不对,努力白费。

对于从来没有接触过AI大模型的同学,我们帮你准备了详细的学习成长路线图&学习规划。可以说是最科学最系统的学习路线,大家跟着这个大的方向学习准没问题。(全套教程文末领取哈)

👉2.AGI大模型配套视频👈

很多朋友都不喜欢晦涩的文字,我也为大家准备了视频教程,每个章节都是当前板块的精华浓缩。

👉3.大模型实际应用报告合集👈

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。(全套教程文末领取哈)

👉4.大模型落地应用案例PPT👈

光学理论是没用的,要学会跟着一起做,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。(全套教程文末领取哈)

👉5.大模型经典学习电子书👈

随着人工智能技术的飞速发展,AI大模型已经成为了当今科技领域的一大热点。这些大型预训练模型,如GPT-3、BERT、XLNet等,以其强大的语言理解和生成能力,正在改变我们对人工智能的认识。 那以下这些PDF籍就是非常不错的学习资源。(全套教程文末领取哈)

👉6.大模型面试题&答案👈

截至目前大模型已经超过200个,在大模型纵横的时代,不仅大模型技术越来越卷,就连大模型相关的岗位和面试也开始越来越卷了。为了让大家更容易上车大模型算法赛道,我总结了大模型常考的面试题。(全套教程文末领取哈)

👉学会后的收获:👈

• 基于大模型全栈工程实现(前端、后端、产品经理、设计、数据分析等),通过这门课可获得不同能力;

• 能够利用大模型解决相关实际项目需求: 大数据时代,越来越多的企业和机构需要处理海量数据,利用大模型技术可以更好地处理这些数据,提高数据分析和决策的准确性。因此,掌握大模型应用开发技能,可以让程序员更好地应对实际项目需求;

• 基于大模型和企业数据AI应用开发,实现大模型理论、掌握GPU算力、硬件、LangChain开发框架和项目实战技能, 学会Fine-tuning垂直训练大模型(数据准备、数据蒸馏、大模型部署)一站式掌握;

• 能够完成时下热门大模型垂直领域模型训练能力,提高程序员的编码能力: 大模型应用开发需要掌握机器学习算法、深度学习

CSDN粉丝独家福利

这份完整版的 AI 大模型学习资料已经上传CSDN,朋友们如果需要可以扫描下方二维码&点击下方CSDN官方认证链接免费领取 【保证100%免费】

读者福利: 👉👉CSDN大礼包:《最新AI大模型学习资源包》免费分享 👈👈

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献7条内容

已为社区贡献7条内容

所有评论(0)