强化学习|一文读懂深度Q网络(DQN)

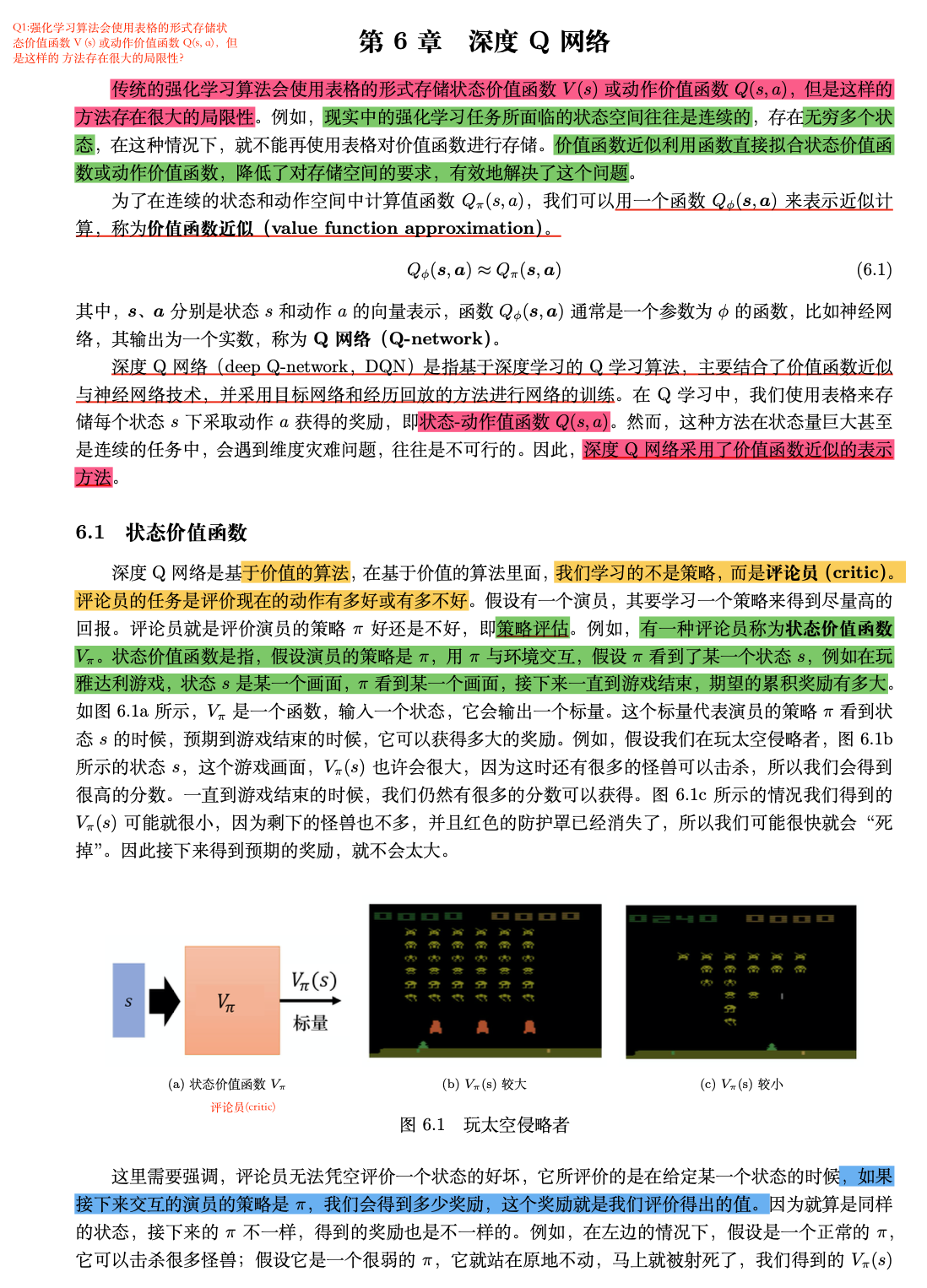

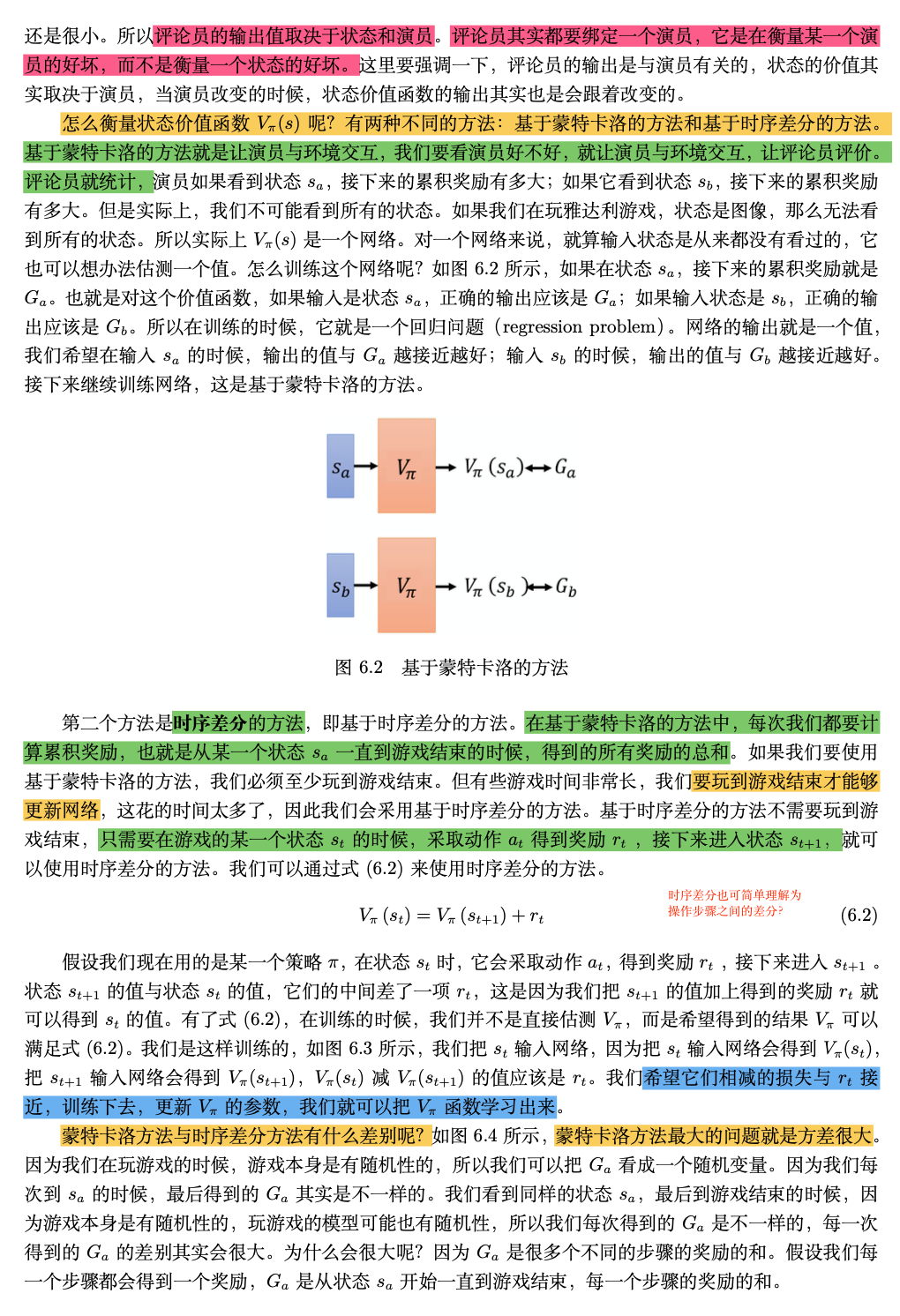

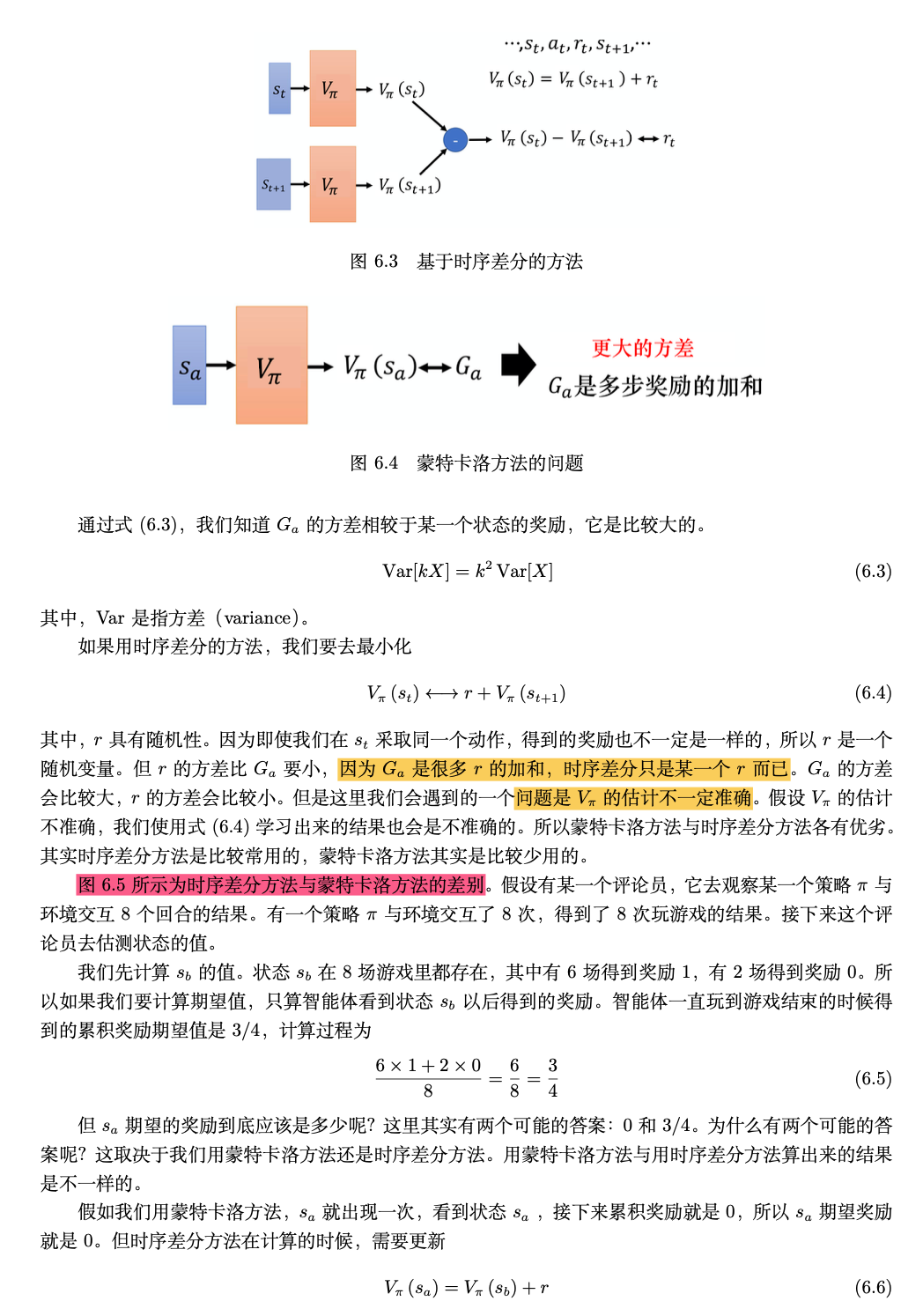

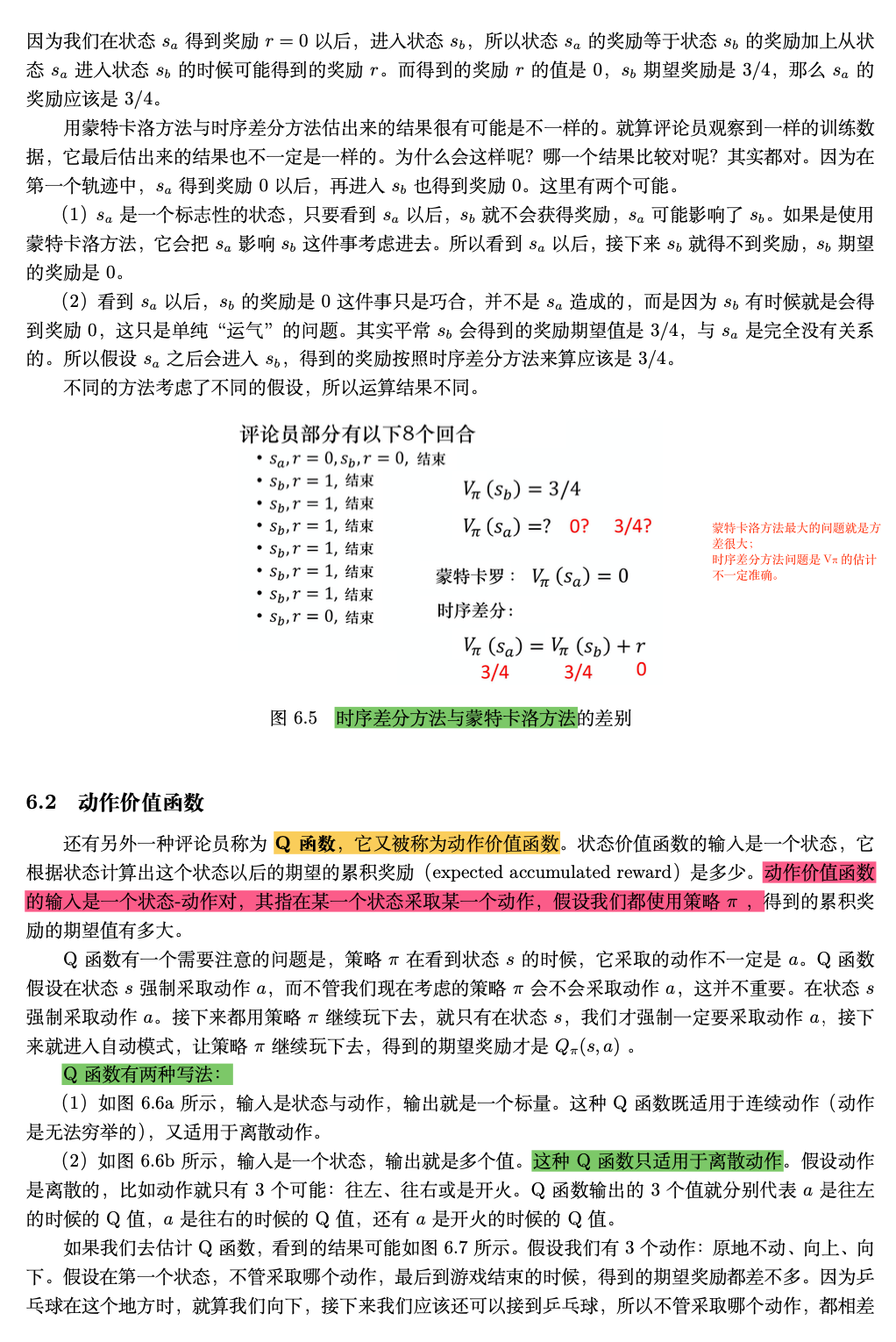

深度 Q 网络(deep Q-network,DQN):基于深度学习的 Q 学习算法,其结合了价值函数近似(value function approximation)与神经网络技术,并采用目标网络和经验回放等方法进行网络的训练。状态-价值函数(state-value function):其输入为演员某一时刻的状态,输出为一个标量,即当演员在 对应的状态时,预期的到过程结束时间段内所能获得的价值。状

在强化学习的发展历程中,深度 Q 网络(DQN)的出现堪称里程碑式突破。它首次将深度学习与传统 Q 学习相结合,成功解决了高维状态空间下的决策问题,让智能体在 Atari 游戏、围棋等复杂场景中展现出超越人类的表现。本文将从核心概念、技术创新与数学原理三个维度,深入解析 DQN 的工作机制及其理论根基。

一、DQN 的诞生:当 Q 学习遇见深度学习

传统 Q 学习(Q-Learning)通过维护一张 Q 表来存储状态 - 动作对的价值(Q 值),但在面对图像、语音等高维状态时,表格存储方式会遭遇 "维度灾难"。2013 年 DeepMind 提出的 DQN(Deep Q-Network)创造性地引入神经网络作为函数近似器,用深度卷积网络(CNN)替代 Q 表,实现了对连续状态空间的高效建模。

1. 核心技术创新:两大训练法宝

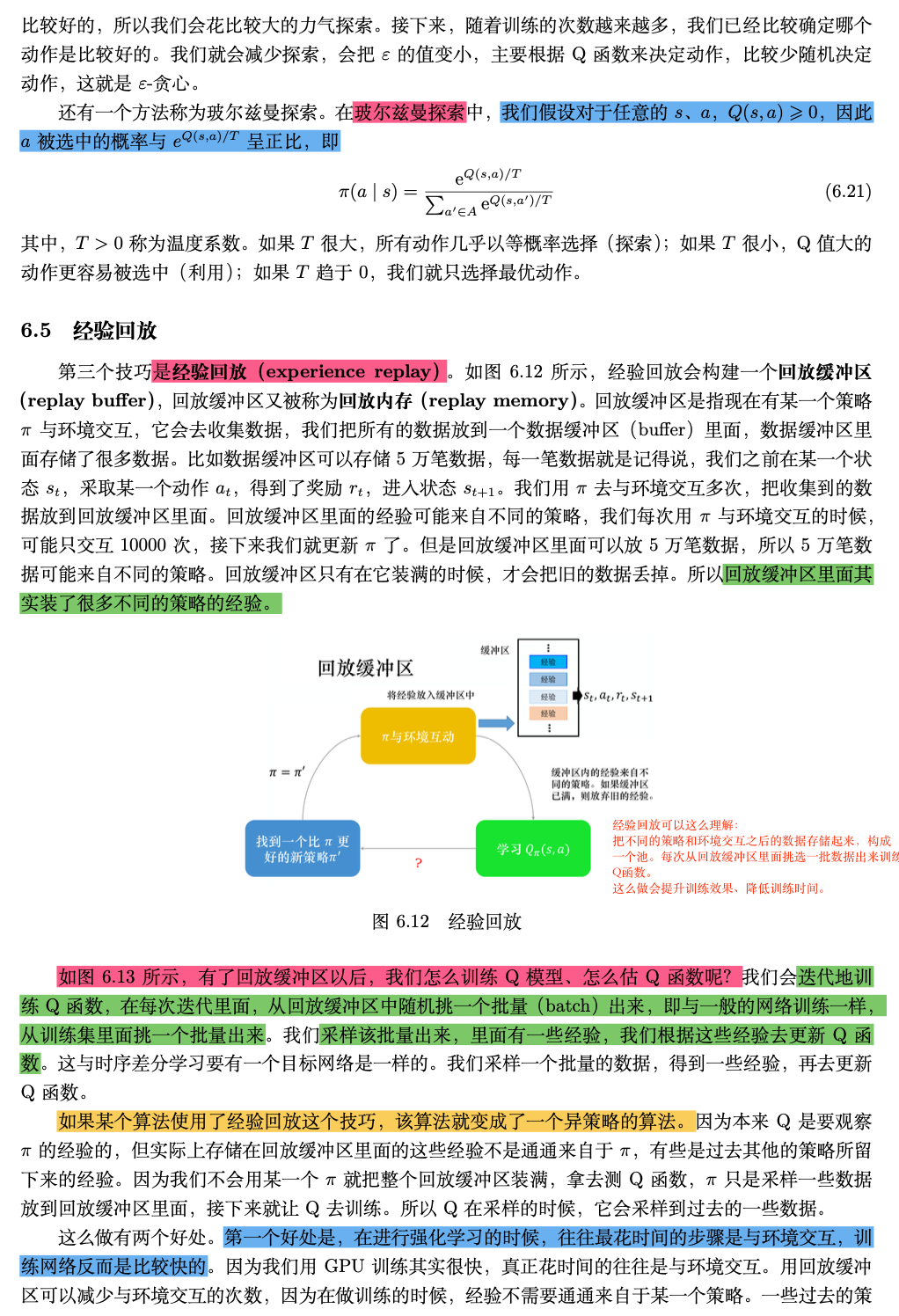

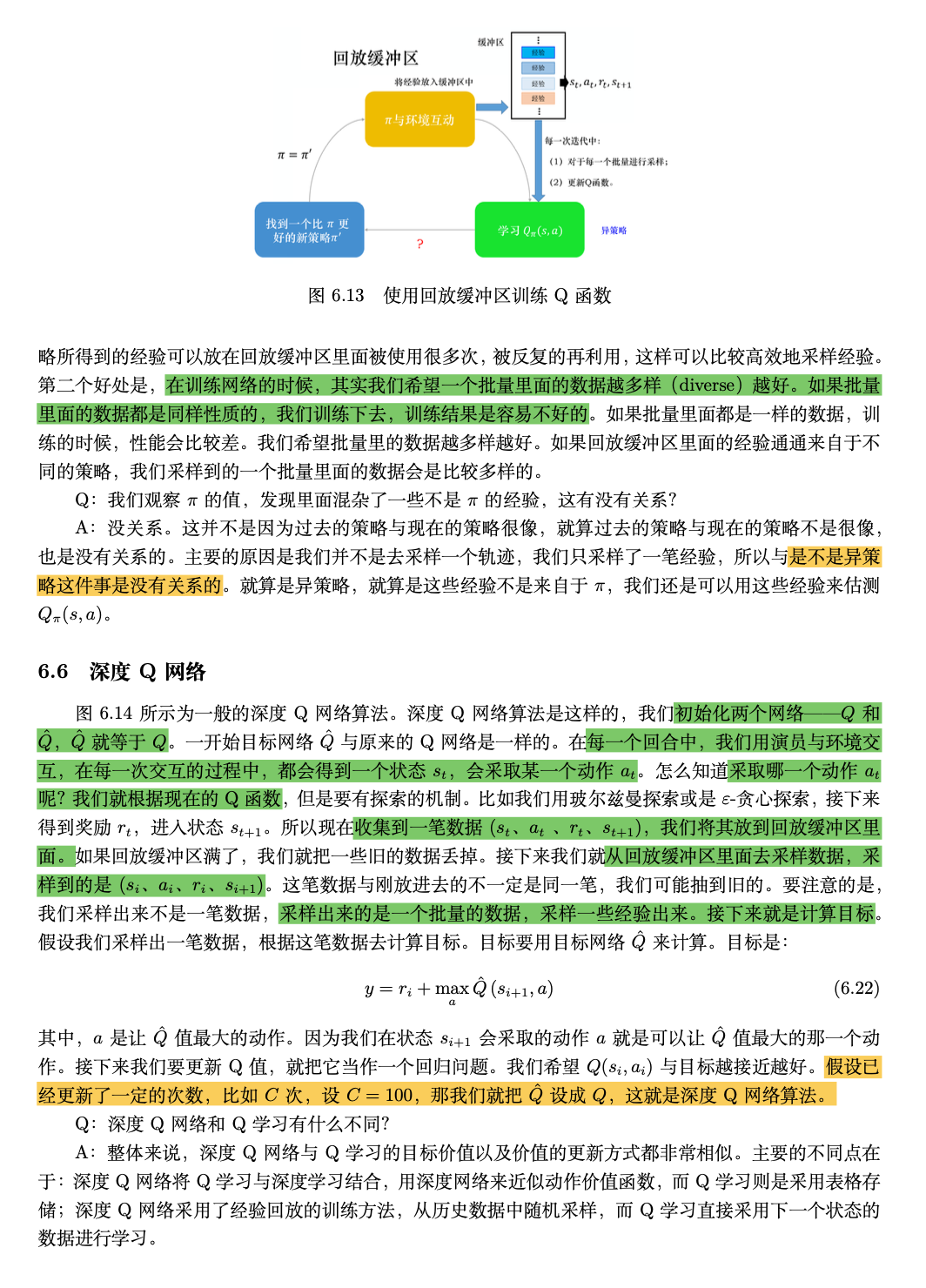

- 经验回放(Experience Replay)智能体与环境交互产生的转移样本(s, a, r, s')被存储在经验池(Replay Buffer)中,训练时随机采样批量数据而非顺序学习。这一设计解决了两大问题:

-

- 打破数据间的时间相关性,避免梯度震荡

-

- 通过重复利用样本提升数据效率,缓解强化学习样本稀缺问题

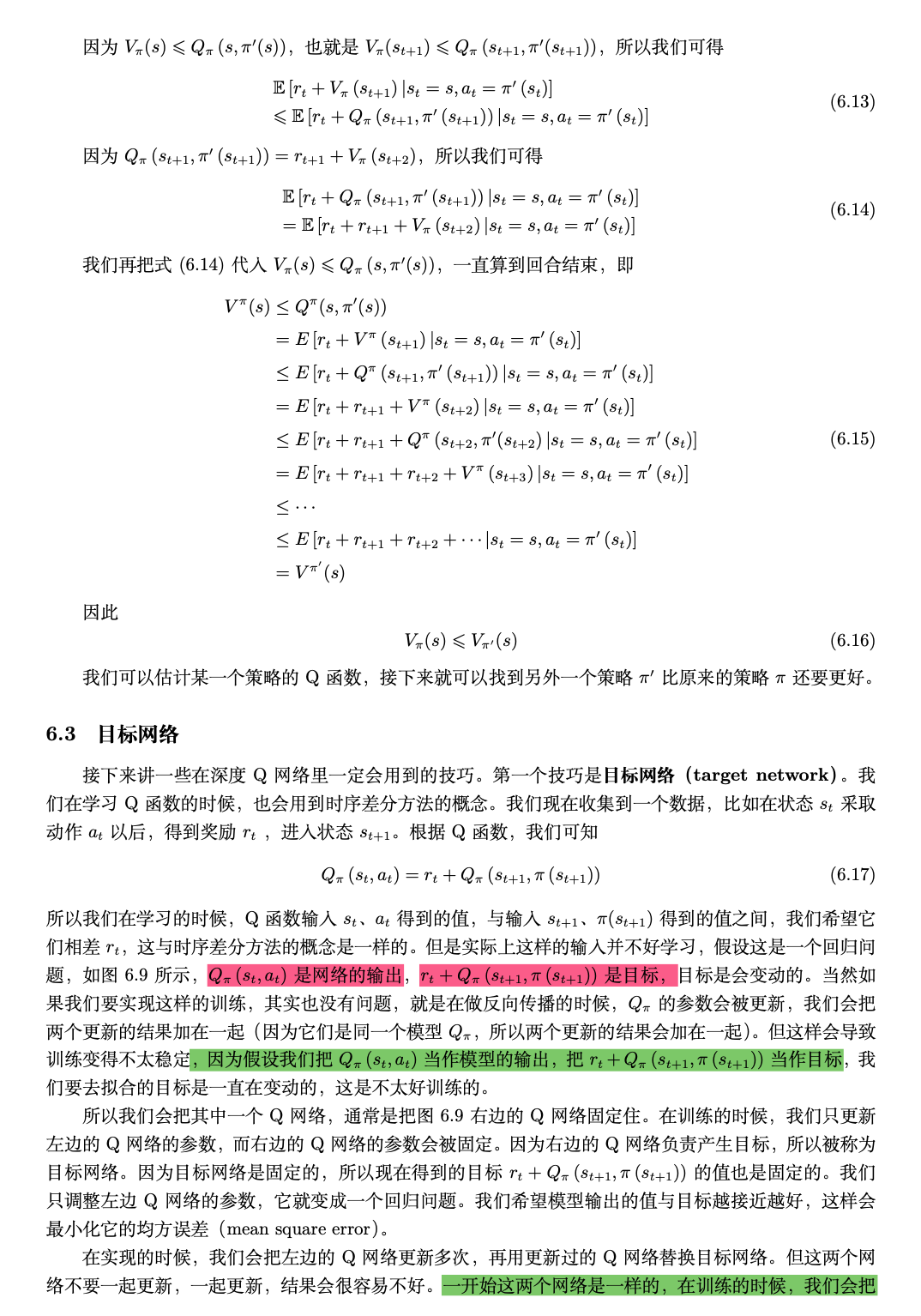

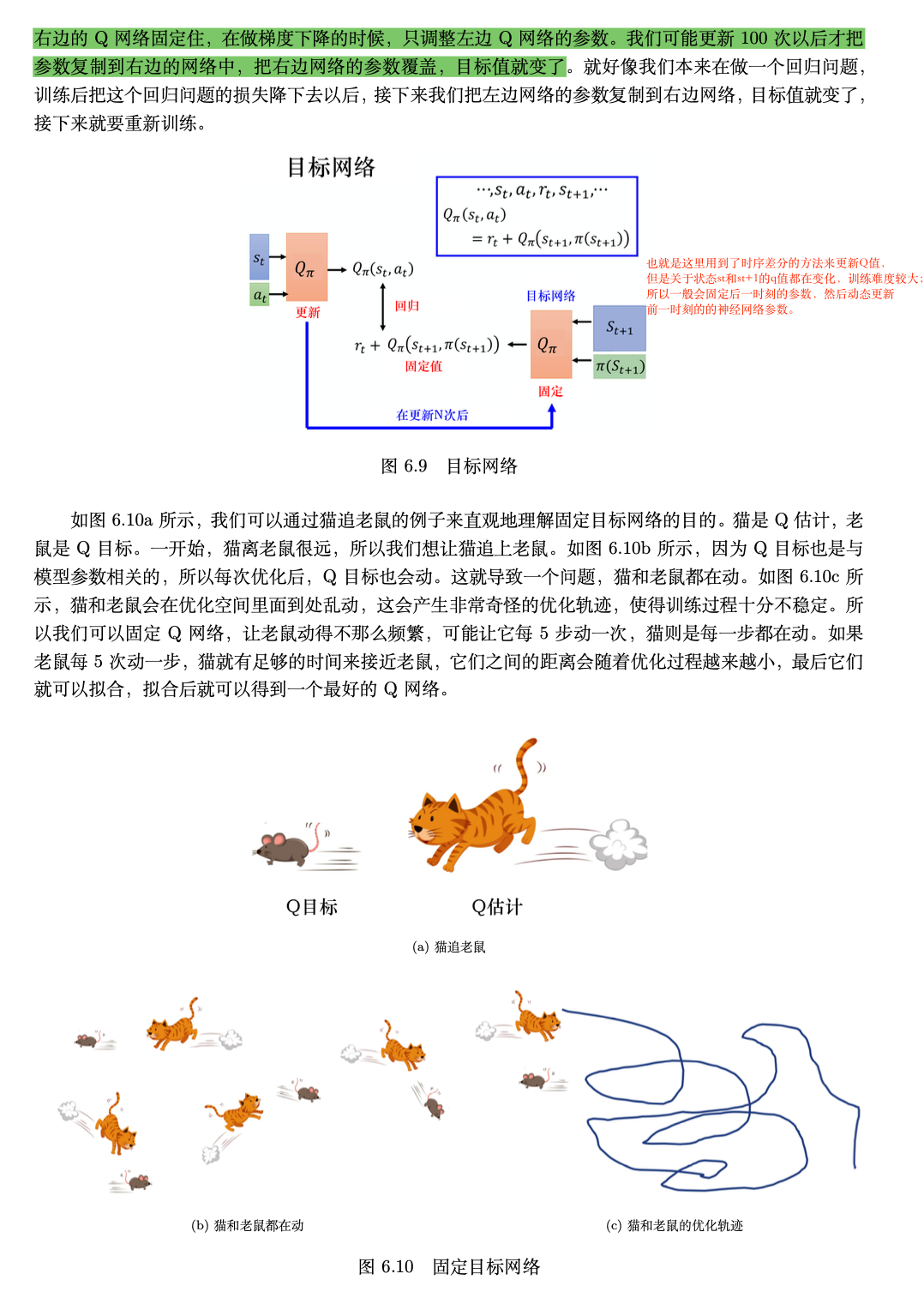

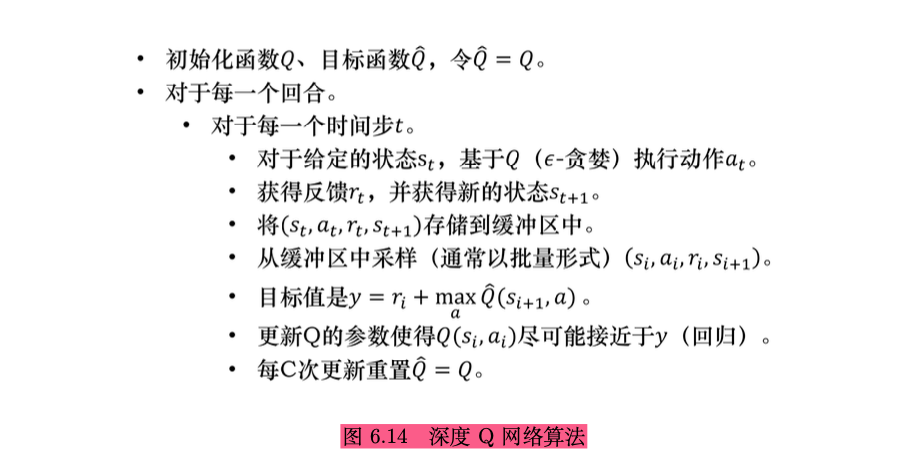

- 目标网络(Target Network)引入两个结构相同但参数不同的神经网络:

-

- 评估网络(Online Network):实时输出当前 Q 值,指导动作选择

-

- 目标网络(Target Network):定期复制评估网络参数,计算固定目标值 \( y = r + \gamma \max_{a'} Q(s', a'; \theta') \)固定目标值的设计减少了训练过程中目标的动态变化,显著提升了训练稳定性。

2. 网络架构:从像素到决策的端到端映射

针对 Atari 游戏的图像输入,DQN 采用经典 CNN 架构:

- 输入层:4 帧堆叠的 84x84 灰度图像(保留运动信息)

- 卷积层:3 个卷积层提取视觉特征,逐步压缩空间维度

- 全连接层:输出各动作的 Q 值,适用于离散动作空间(如 Atari 的 18 种操作)

二、状态价值函数:理解智能体决策的 "温度计"

在强化学习的价值体系中,** 状态价值函数 V (s)** 扮演着核心角色:

定义:输入当前状态 s,输出一个标量值,表示从状态 s 开始遵循既定策略 π,智能体在未来一段时间内获得的期望累计回报(通常包含折扣因子 γ),数学表达式为:\( V^\pi(s) = \mathbb{E}_\pi \left[ \sum_{t=0}^\infty \gamma^t r_{t+1} \mid s_t = s \right] \)

- 物理意义:衡量状态的 "好坏" 程度,高价值状态意味着后续能获得更多奖励

状态价值与动作价值的关系

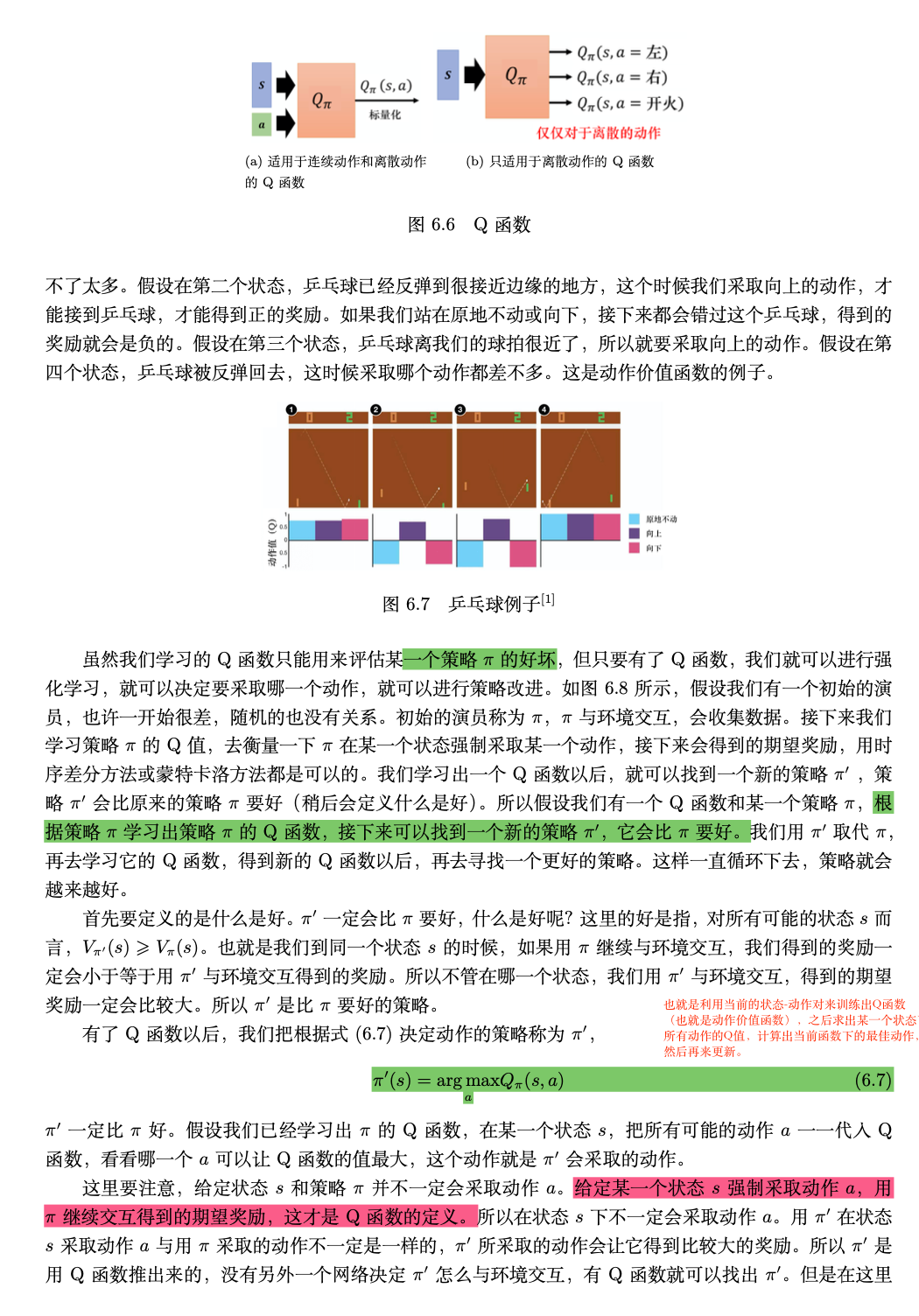

虽然 DQN 直接优化的是动作价值函数 Q (s,a)(即给定状态 s 时采取动作 a 的期望回报),但状态价值函数是理解强化学习的基础:\( V^\pi(s) = \sum_a \pi(a|s) Q^\pi(s,a) \)

二者通过策略 π 建立联系,Q 值可视为状态价值在动作维度的展开 —— 每个动作对应一条可能的价值分支。

三、贝尔曼方程:价值函数的递归本质

状态价值函数贝尔曼方程揭示了价值函数的动态规划特性:当前状态的价值等于即时奖励加上后续状态价值的折扣期望。\( V(s) = \mathbb{E}_{a \sim \pi, s' \sim p} \left[ r + \gamma V(s') \mid s \right] \)

- 核心思想:未来价值是当前决策的 "后视镜",每个状态的价值由后续所有可能状态的价值递归决定

- 马尔可夫性质:假设未来仅依赖当前状态,与历史无关,这是贝尔曼方程成立的前提

从状态价值到动作价值的贝尔曼更新

DQN 优化的 Q 值同样满足贝尔曼方程,其迭代更新公式为:\( Q(s,a) = r + \gamma \max_{a'} Q(s', a') \)

这一公式构成了 DQN 目标值计算的理论基础:当前动作的 Q 值由即时奖励 r 和下一状态的最大 Q 值(贪心策略)共同决定。目标网络的作用正是为这一递归过程提供稳定的目标值,避免评估网络自身参数变化带来的目标震荡。

四、DQN 如何突破传统强化学习瓶颈?

对比传统 Q 学习,DQN 的革命性在于:

- 处理高维状态:通过 CNN 自动提取图像特征,替代人工设计状态表示

- 稳定训练过程:经验回放打破数据相关性,目标网络降低目标变动频率

- 泛化能力提升:神经网络的函数近似能力让智能体具备举一反三的决策能力

经典案例:DQN 征服 Atari 游戏

在 2015 年的《Nature》论文中,DQN 在 49 款 Atari 游戏中超越人类平均水平。以《Pong》为例:

- 输入:4 帧连续游戏画面(84x84 灰度图)

- 输出:3 种动作(上、下、不动)的 Q 值

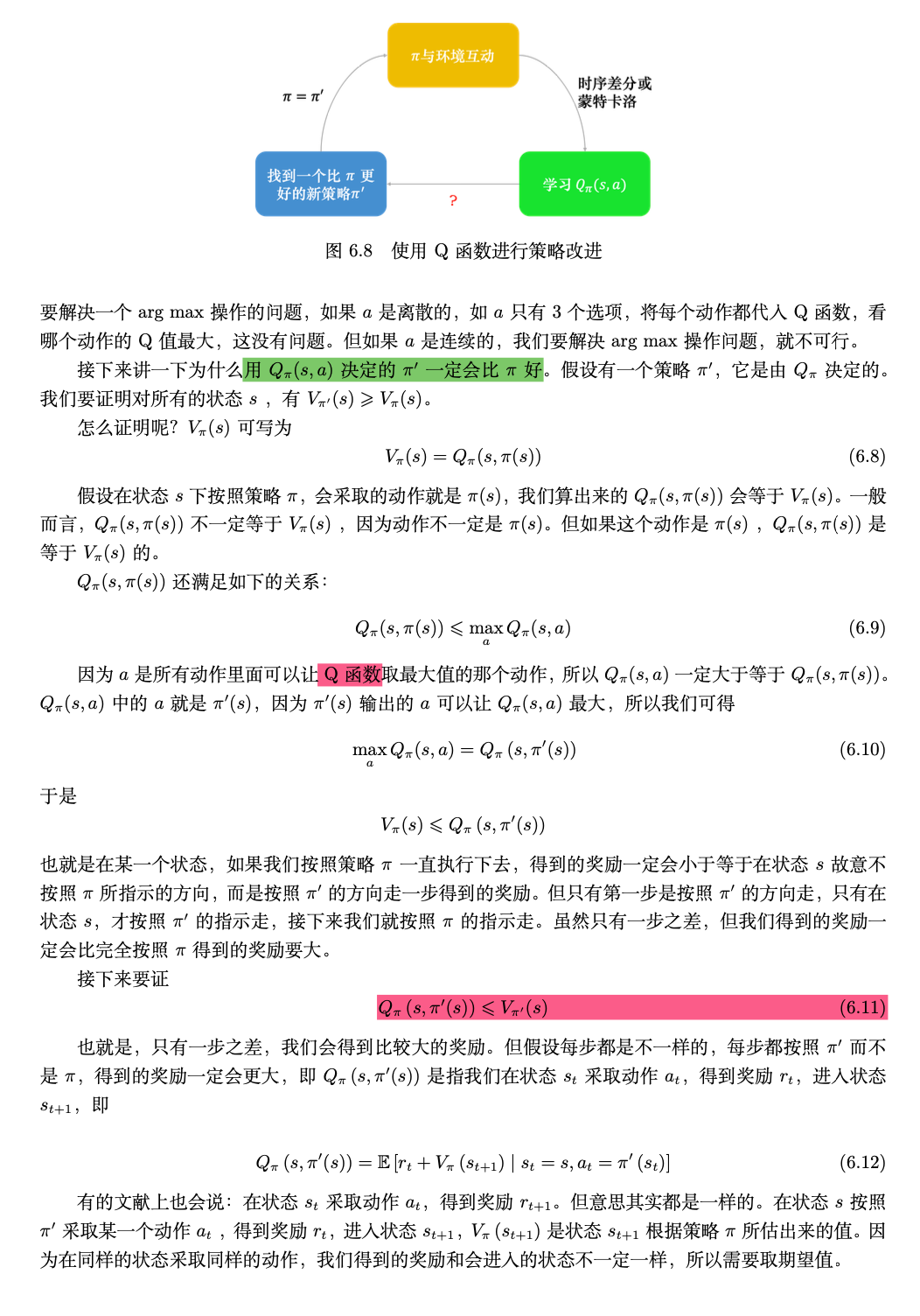

- 训练过程:累计百万次游戏交互,通过经验回放优化网络参数最终智能体学会预测球的运动轨迹,做出精准击球动作,展现出对视觉信息的高效处理能力。

五、技术局限与后续发展

尽管 DQN 取得突破性进展,但其仍存在局限性:

- 离散动作空间:仅适用于动作数量有限的场景(如 Atari 的 18 种操作)

- 高估问题:最大化操作可能导致 Q 值高估,催生了 Double DQN 等改进算法

- 样本效率:相比人类学习仍需海量数据,推动了优先经验回放(Prioritized Replay)等技术的发展

这些不足促使后续研究不断改进,形成了 Dueling DQN、Rainbow 等更强大的算法,但 DQN 奠定的 "深度网络 + 经验回放 + 目标网络" 架构,至今仍是许多强化学习算法的核心组成部分。

六、总结及详细学习资料留存

DQN 的成功不仅在于技术创新,更在于它构建了理论(贝尔曼方程)与工程(深度神经网络)之间的桥梁。状态价值函数为智能体提供了评估环境的 "度量衡",贝尔曼方程揭示了价值传递的动态规律,而 DQN 通过巧妙的工程设计,让这些理论在高维复杂环境中落地生根。

随着强化学习向机器人控制、自动驾驶等领域拓展,理解这些基础概念与核心算法,将为我们打开智能决策系统的大门。从表格到网络,从离散到连续,强化学习的故事仍在继续 —— 而 DQN,正是这个故事中浓墨重彩的一章。

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)