毕业设计-基于卷积神经网络的工作人员反光衣识别算法 YOLO 深度学习

基于深度学习的工作人员反光衣识别算法,该算法旨在提高工作场所的安全性和效率。通过使用深度学习技术,该算法能够准确地识别工作人员穿着反光衣的情况,从而帮助监控系统实时监测工作人员的位置和活动。解释了算法的原理和实现方法,并提供了实验结果和性能评估。这项毕业设计为工作场所的安全管理和监控提供了一种创新的解决方案,有望在实际应用中发挥重要作用。

目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于卷积神经网络的工作人员反光衣识别算法

设计思路

一、课题背景与意义

机场事故的首要原因是场务保障方面的人员因素。为了规避风险,根据机场运行管理规定,机坪作业人员在工作时必须穿着易于识别的工作外套并配有反光标识,反光衣是地勤人员的安全警示标识,可以提升地勤人员现场工作的安全性,从而更好地保护他们的安全。

二、算法理论原理

2.1 目标检测算法

目标检测技术是计算机视觉与数字图像处理领域的热门方向之一。在智能视频监控、农业监控、机器人导航等领域都需要使用目标检测技术。近年来,目标检测成为理论研究和应用研究的热点。随着深度学习技术的广泛应用,目标检测算法也突破了传统算法的局限,取得了重大提升。目前,基于深度学习的目标检测算法主要分为一阶段目标检测方法和二阶段目标检测方法。在二阶段目标检测方法中,比较常用的有Faster R-CNN和YOLO系列算法。

2.2 YOLOv5算法

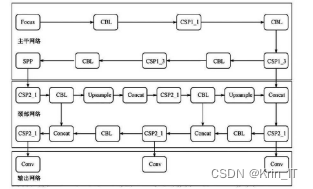

YOLOv5的网络结构如图所示:主要包含主干网络、颈部网络和输出网络三个部分。主干网络是一种用于特征提取的卷积神经网络,主要结构包括Focus模块、CSP结构和SPP模块。

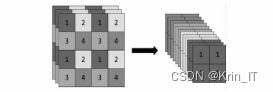

Focus模块对输入的图像进行自我复制和切片操作,以减少网络计算量并加快对候选区域特征的提取速度。CSP模块是在Darknet53的基础上引入主干网络中,用于在特征提取过程中防止产生过多的重复梯度信息,减少计算负担。SPP(Spatial Pyramid Pooling)层是空间金字塔池化层,采用不同大小的核进行最大池化,将不同尺度的特征融合转变为相同大小的输出,解决了输入尺度大小不一的问题,有利于多尺度检测。

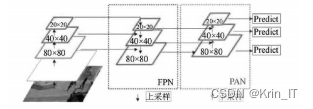

颈部网络采用了PANet结构,由特征金字塔结构(Feature Pyramid Network,FPN)和路径聚合网络结构(Path Aggregation Network,PANet)组成的多尺度特征融合网络结构,如图所示。FPN采用上采样的方式对特征图像自底向上融合,PANet则采用下采样的方式对特征图像自顶向下融合。PANet网络结构可以很好地融合主干网络和输出网络的特征,使得多层次、多尺度之间的信息融合更加顺畅,提升信息融合的能力。

三、反光衣检测系统的实现

3.1 实现环境

数据集是从监控摄像头中采集的,人员在近距离和远距离都有出现,目标的尺度比较丰富。因此,需要选用具有多尺度检测能力的检测器。虽然图像中有时会存在比较小的目标,但由于场景为机场保障现场,目标相对较稀疏,遮挡情况不太严重,且与周围环境相比,目标特征也比较明显。因此,针对图像中反光衣穿着情况进行目标检测,给出目标框和对应的类别信息,以实现预警功能。预警情况只有当人员穿着不规范穿反光衣时才触发。

3.2 评价标准

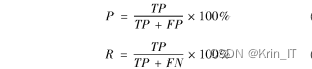

为了验证YOLOv5算法的性能,采用适当的评价标准进行评估。主要考虑了准确率(Precision)、召回率(Recall)、平均精度(Average Precision)和平均精度均值(mAP)等评价指标。对YOLOv5网络模型进行评价时,准确率和召回率的计算方式分别为以下公式中,TP代表正确检测的目标数量,FP代表错误检测的目标数量,FN代表没有检测出的目标数量。

平均精度均值是数据集中所有类别的平均精度的均值。具体计算公式如下:

![]()

3.2实验结果分析

在训练之前,我们将训练集图像按8:2划分为训练集和测试集。通过基于YOLOv5网络训练得到的目标检测结果表明系统采用YOLOv5网络进行反光衣检测精度更高。

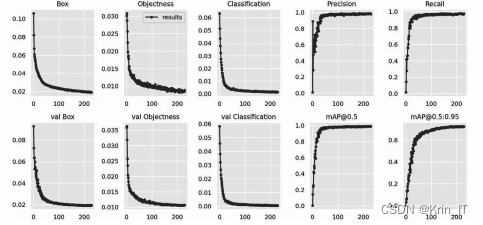

通过YOLOv5网络训练得到的损失函数、平均精度均值(mAP)、召回率(Recall)和精确率(Precision)的曲线变化如下图所示。其中,损失函数值越低说明算法的效果越好,平均精度均值、召回率和精确率的值越高说明算法的性能越好。

部分代码如下:

model = torch.hub.load('ultralytics/yolov5', 'yolov5s')

# 加载图像

image_path = 'path/to/your/image.jpg'

image = Image.open(image_path)

# 进行目标检测

results = model(image)

# 获取反光衣检测结果

person_results = results.pandas().xyxy[results.pandas().xyxy['name'] == 'person']

# 遍历每个检测到的人员

for _, person in person_results.iterrows():

# 获取反光衣的检测框坐标

x1, y1, x2, y2 = person[['xmin', 'ymin', 'xmax', 'ymax']].values.astype(int)

# 提取反光衣区域图像

reflective_clothing_image = image.crop((x1, y1, x2, y2))

# 进行反光衣识别操作,可以使用其他算法或模型进行识别

# 显示结果

cv2.rectangle(image, (x1, y1), (x2, y2), (0, 255, 0), 2) # 绘制检测框

cv2.putText(image, 'Reflective Clothing', (x1, y1 - 10), cv2.FONT_HERSHEY_SIMPLEX, 0.9, (0, 255, 0), 2) # 绘制标签

# 显示结果图像

cv2.imshow('Detection Results', image)

cv2.waitKey(0)

cv2.destroyAllWindows()

创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

最后

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)