(论文速读)DINO:改进去噪锚框的DETR目标检测模型

DINO是一种改进的端到端目标检测器,通过三个关键创新提升DETR类模型的性能。首先,对比去噪训练(CDN)引入正负样本对,有效减少重复预测;其次,前瞻两次方案(LFT)优化解码器梯度传播,提升框预测精度;最后,混合查询选择结合动态和静态查询,平衡收敛速度和训练稳定性。实验表明,DINO在COCO数据集上达到63.3AP的SOTA性能,且训练效率显著提高,12轮训练即可超越传统方法50轮的效果。该

DINO:改进去噪锚框的端到端目标检测器

引言

在计算机视觉领域,目标检测一直是最重要的基础任务之一。虽然传统的基于卷积的检测算法(如Faster R-CNN、YOLO等)在性能上表现优异,但它们通常包含手工设计的组件,如锚点生成和非最大抑制(NMS)。DETR(Detection Transformer)的出现为目标检测带来了全新的端到端解决方案,但其训练收敛缓慢且查询语义不清晰的问题一直困扰着研究者。

近期,一篇提交至ICLR 2023的论文提出了DINO(DETR with Improved deNoising anchOr boxes),通过三个关键创新显著提升了DETR类模型的性能和训练效率。

DINO的核心创新

1. 对比去噪训练(Contrastive Denoising Training, CDN)

问题分析

DN-DETR虽然通过去噪训练有效稳定了训练过程,但存在一个关键缺陷:每个去噪查询都与GT框匹配,缺乏预测"无目标"背景的能力。这限制了模型减少重复预测的能力。

创新设计

DINO提出了对比去噪训练方法,巧妙地引入了正负样本对:

实现机制:

- 使用两个超参数λ₁和λ₂(λ₁ < λ₂)控制噪声尺度

- 正样本:噪声小于λ₁,期望重建对应的GT框

- 负样本:噪声在λ₁和λ₂之间,期望预测"无目标"

优势分析:

- 显式引入困难负样本,帮助模型学习正负样本间的细微差异

- 提高框预测精度,减少重复预测

- 在所有置信度阈值下都能减少重复检测

实验数据显示,在COCO数据集上使用300个预测时,CDN(Contrastive DeNoising)相比传统DN在各个置信度阈值下都能预测更少的重复框。例如,在0.15阈值下,DN产生3.53个重复预测,而CDN仅产生2.55个。

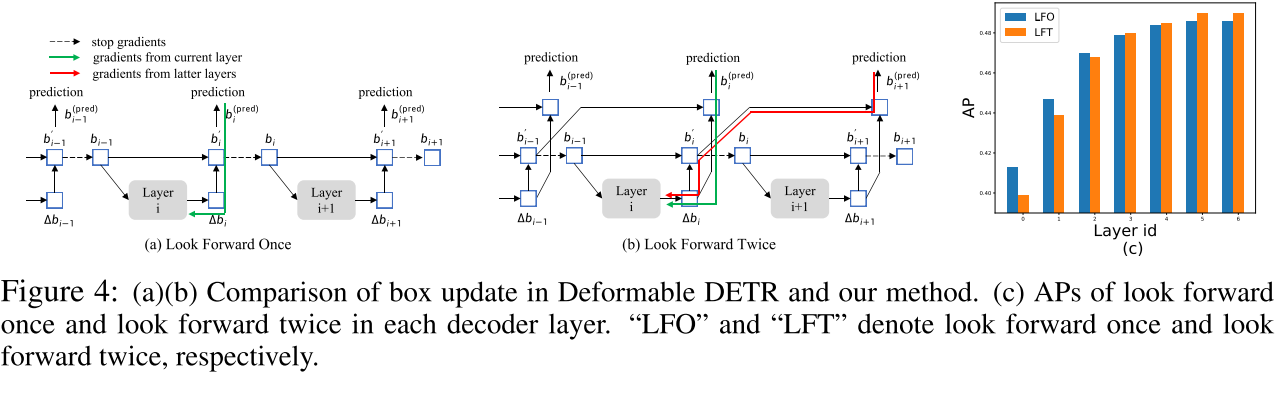

2. 前瞻两次方案(Look Forward Twice, LFT)

传统方法的局限

Deformable DETR采用"前瞻一次"(Look Forward Once)的贪心策略:第i层解码器的参数只基于第i层的辅助损失更新,通过梯度截断避免影响前层。这种方法虽然稳定训练,但可能导致次优结果。

LFT的设计思路

DINO提出的LFT允许第i-1层同时受到来自第i-1层和第i层的梯度影响:

核心改进:

传统LFO: b_i^(pred) = b'_i

改进LFT: b_i^(pred) = σ(σ⁻¹(b'_{i-1}) + Δb_i)

这使得参数在两个层次上都能逼近GT框,实现更全面的优化。

性能验证: 实验显示,LFT在解码器的第0-2层性能略低于LFO,但在第3-6层显著超越LFO,验证了LFT为获得更好的最终性能而在早期层面做出的权衡是合理的。

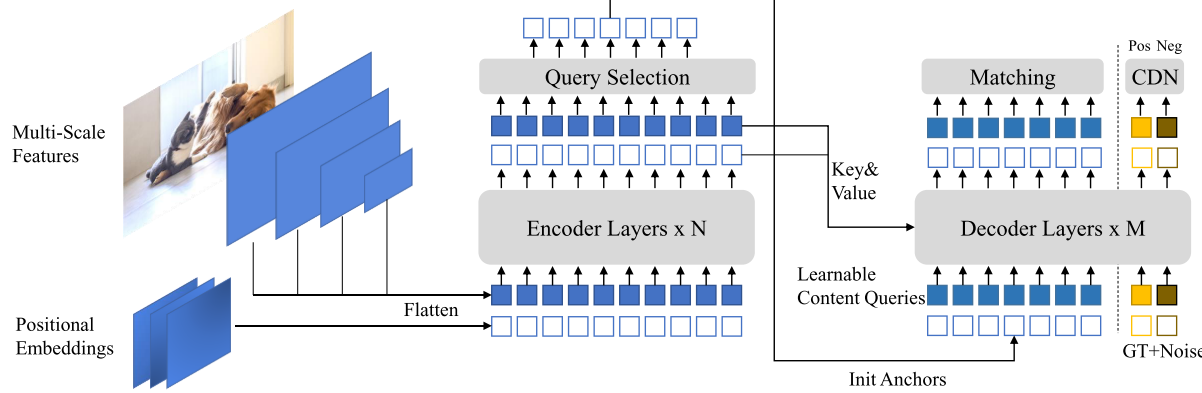

3. 混合查询选择(Mixed Query Selection)

设计动机

传统的查询初始化方法存在不同的优缺点:

- 静态查询:不依赖具体图像,收敛较慢

- 香草查询选择:提升收敛速度,但内容查询与CDN部分不对齐

解决方案

DINO采用混合策略:

- 位置查询:从编码器输出中选择Top-K特征作为动态锚点

- 内容查询:保持可学习状态,与CDN部分的可学习查询保持一致

这种设计既利用了查询选择的快速收敛优势,又保证了与CDN训练的兼容性。

实验验证与性能表现

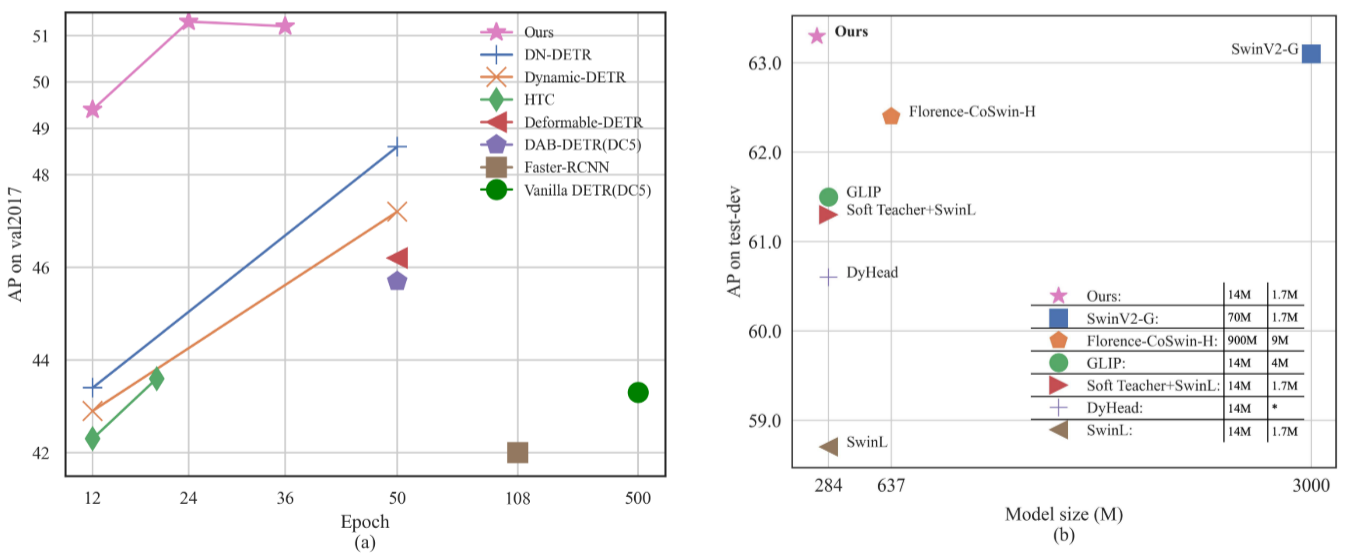

快速收敛能力

在12轮训练设置下,DINO展现出卓越的快速收敛能力:

- ResNet-50 + 4尺度:49.0 AP,相比DN-DETR提升+5.6 AP

- ResNet-50 + 5尺度:49.4 AP,相比DN-DETR提升+6.0 AP

特别值得注意的是,DINO在小目标检测上表现突出,分别提升+7.2 AP和+7.5 AP。

长期训练性能

在24轮训练下:

- 4尺度模型:50.4 AP(+1.8 AP)

- 5尺度模型:51.3 AP(+2.7 AP)

大规模模型的突破

使用SwinL骨干网络并在Objects365数据集预训练后,DINO取得了突破性成果:

- COCO val2017:63.2 AP

- COCO test-dev:63.3 AP

这一结果在参数量少于10亿的模型中创造了新纪录,相比SwinV2-G的30亿参数,DINO仅使用2.18亿参数就达到了更好的性能。

消融实验与技术分析

组件有效性验证

通过系统的消融实验,验证了各个组件的贡献:

| 组件 | AP提升 | 特点 |

|---|---|---|

| CDN | +0.9 | 减少重复预测,提升精度 |

| 混合查询选择 | +1.4 | 改善锚点初始化 |

| LFT | +0.4 | 优化框精修过程 |

计算效率分析

DINO在保持高性能的同时维持了合理的计算成本:

- ResNet-50模型:279 GFLOPs,24 FPS

- 训练时间:约55分钟/轮(8块A100 GPU)

技术意义与影响

理论贡献

- 对比学习引入目标检测:CDN首次在DETR框架中系统地引入正负样本对比

- 梯度传播优化:LFT提供了解码器层间梯度传播的新思路

- 查询初始化策略:混合查询选择为不同训练阶段提供了平衡方案

实用价值

- 端到端检测新标杆:首次使基于Transformer解码器的检测器在公开排行榜上达到SOTA

- 训练效率显著提升:12轮训练就能达到传统方法50轮的效果

- 模型参数效率:用更少的参数达到更好的性能

总结与展望

DINO通过三个精心设计的创新点,成功解决了DETR类模型训练慢、重复预测多、查询初始化不当等关键问题。其在COCO数据集上的突破性表现证明了端到端检测器的巨大潜力。

特别值得关注的是:

- 对比去噪训练为处理困难负样本提供了新思路

- 前瞻两次方案展示了梯度传播优化的重要性

- 混合查询选择体现了针对性设计的价值

DINO的成功不仅推动了DETR类模型成为主流检测框架,也为后续研究提供了宝贵的设计思路。随着Transformer在计算机视觉领域的深入应用,端到端检测器有望在更多场景中发挥重要作用。

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)