(2025|南大,LLM,强化学习,离线逆强化学习,下一 token 预测,内生奖励)在 LLM 中发现通用奖励模型

本文发现,一个强大的通用奖励模型并非需要构建,而是可以挖掘出来的,因为它潜伏在任何通过标准下一 token 预测训练的语言模型中。这种内生奖励并非启发式的,而是理论上等同于通过离线逆强化学习学到的奖励函数,它可带来优越于基础模型的策略

Generalist Reward Models: Found Inside Large Language Models

论文地址:https://arxiv.org/abs/2506.23235

进 Q 学术交流群:922230617 或加 CV_EDPJ 进 W 交流群

目录

1. 引言

大型语言模型(LLM)的对齐 问题,即如何让模型行为符合复杂的人类价值观(如助益性和诚实性),一直是人工智能发展的核心挑战。

- 目前主流的方法是 基于人类反馈的强化学习(RLHF),其核心在于通过 人类偏好数据训练奖励模型(RM)来对模型输出进行评分。

- 最终模型的对齐效果高度依赖于奖励模型的质量。

- 然而,构建高质量奖励模型需要大规模、高质量的人类偏好数据,这一过程不仅耗时且代价高昂,难以扩展。

为了摆脱对人类标注的依赖,研究者们提出了多种替代性对齐方法。

- 一个突出的方向是 基于 AI 反馈的强化学习(RLAIF)或 “LLM 作为评审”(LLM-as-a-judge)框架,这类方法利用强大的 LLM 自动生成奖励信号或偏好标签,从而避免人类标注。

- 但这些方法通常是启发式的,缺乏严谨的理论基础,同时容易继承评审模型的风格偏差与问题。这引发了一个关键问题:高质量的奖励信号是否必须依赖外部来源?

本文发现,一个强大的通用奖励模型并非需要构建,而是可以挖掘出来的,因为它潜伏在任何通过标准下一个标记预测(next-token prediction)训练的语言模型中。本文称之为 内生奖励(endogenous reward)。

- 本文证明,这种内生奖励并非启发式方法,而是理论上等同于通过 离线逆向强化学习 学习到的奖励函数。这一关联使得能够在无需额外训练的情况下,直接从基础模型(无论是预训练还是监督微调模型)中提取高质量的奖励信号。

- 关键的是,本文还证明,使用这种内生奖励进行后续强化学习会带来一个在误差界限上理论上优越于基础模型的策略。

- 据本文所知,这是首次理论上证明强化学习在 LLM 中的有效性。

本文的实验验证了这一理论,表明该方法不仅优于现有的 “LLM 作为评审” 方法,还能超越显式训练的奖励模型。

这些发现表明,奖励建模阶段可以被一种原则性方法所取代,该方法能直接提取在预训练中已经捕获的知识,从而为 LLM 对齐以及多模态模型开辟了一种更高效、更强大、更可扩展的新范式。

2. 预备知识

2.1 LLM 与 MDP 形式化

LLM 本质上是通过 预测序列中下一个 token 来生成文本的概率模型。形式化地,LLM π 在有限词汇表 V 中选择 token,并以自回归方式生成序列。给定历史序列 (a₁, …, aₕ₋₁),LLM 生成下一个 token 的条件分布为 aₕ ∼ π(·|a₁,…,aₕ₋₁)。

在本文中,采用 LLM 的强化学习视角,将语言生成任务形式化为 马尔可夫决策过程(Markov Decision Process,MDP),由元组 M = ⟨S, V, r, P, ρ, H⟩ 定义,其中状态空间 S 为所有有限长度字符串集合,动作空间为词汇表 V,奖励函数 r ∈ [0,1],转移概率 P 为确定性拼接操作,初始状态分布为 ρ,任务长度为 H,即轨迹在总共 H 步后结束。。

P(s_{h+1} | s_h, a_h) = 1 当且仅当 s_{h+1} = s_h ⊕ a_h,其中 ⊕ 表示拼接。

在强化学习的语境中,也将 π 称为策略。在本文中,“策略” 和 “策略学习模型” 这两个术语将互换使用。通过策略值 V^π 来衡量策略 π 的质量,其定义为

![]()

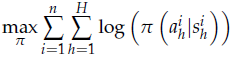

2.2 下一 Token 预测

下一 token 预测是 LLM 最基本的训练目标,目标是在给定先前 token 的情况下最大化预测下一个 token 的概率:

值得注意的是,从模仿学习 (imitation learning,IL) 的角度来看,下一 token 预测可以被视为著名的行为克隆(behavior cloning)方法的一个实例,其中模型模仿专家在演示状态下的行为。

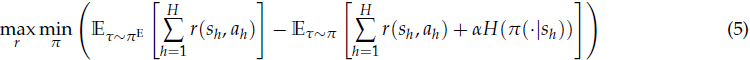

2.3 RLHF

基于人类反馈的强化学习(Reinforcement Learning from Human Feedback,RLHF)主要包括奖励建模与强化学习微调两个阶段。奖励(Reward)建模阶段利用人类偏好数据训练奖励模型,随后在奖励信号指导下对 SFT 模型进行 RL 微调,优化目标通常包含 KL 正则项以防止策略偏移过大。

![]()

其中,RM 为奖励模型,σ 是 sigmoid 函数,y_w 和 y_l 分别是 winner 轨迹和 loser 轨迹。

2.4 IRL

逆向强化学习(Inverse Reinforcement Learning,IRL)旨在从专家示范中恢复奖励函数。IRL 不是从已知的奖励函数中学习策略,而是假设专家的演示是最优或接近最优的,从而试图从专家的演示中恢复奖励模型。

最大熵(Maximum Entropy)IRL 是一种理论严谨的方法,目标是在解释专家行为的同时保持最大不确定性。

【注:熵 H 在信息论中表示一个事件的不确定度,表示为一个事件发生概率的负对数,即事件发生概率越小,其熵越大,不确定度越高】

2.5 IRL 与 RLHF 中奖励模型的联系

MaxEnt IRL 目标可视为 RLHF 中使用的模型原理的更通用的分布级表述。

公式 (3) 中的目标通过最大化特定 “winner” 轨迹 y_w 和 “loser” 轨迹 y_l 之间的得分差异来学习奖励函数。这本质上是一种成对或样本级比较。

公式 (5) 中的 MaxEnt IRL 目标可以看作是分布级的类似物。它不是比较两条采样轨迹,而是将整个专家分布 (π^E) 与奖励函数 r 下产生的最优竞争策略 π 进行比较。“min_r” 项主动寻求最强的竞争策略,然后 “max_r” 项调整奖励以创造最大的性能差距。

从这个角度来看,RLHF 奖励建模过程可以理解为 IRL 原理的一个实用且易于计算的实例。RLHF 并非求解复杂的 “min_π” 优化问题,而是简化了该问题,并直接最大化偏好数据集中 “winner” 与 “loser” 之间的奖励差值。因此,RLHF 是 IRL 提供的更广泛理论框架中的一个特例。

本文的工作回归到这个更通用的 IRL 公式,直接推导出奖励函数,而无需进行明确的成对比较。

3. 发现 LLM 中的内生奖励

3.1 从 IRL 角度看奖励学习

如前所述,RLHF 中的奖励建模过程本质上可视为 IRL 的简化版。

- 这就引出了一个问题:能否用一种更基础的 IRL 方法来恢复能够最好地解释专家数据集 D 的最优奖励函数,而不是依赖 RLHF 中常见的成对比较启发式方法?

- 历史上阻碍这种直接方法的主要挑战是,大多数 IRL 方法都是为 在线设置 而制定的,需要计算成本高昂的交互。

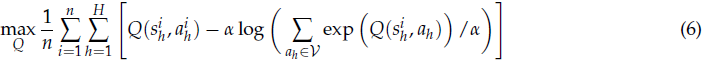

本文提出利用 离线 IRL 方法中的 inverse soft Q-learning,该方法旨在找到一个能够最好地解释静态数据集 D 中的专家数据的 Q-function。

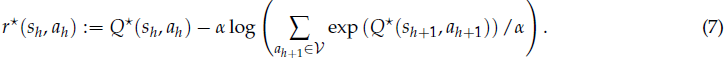

一旦找到最大化该目标的最优 Q 函数 Q*,就可以通过 inverse soft Bellman operator 恢复相应的理想奖励函数 r*:

这提供了一种原则性的离线方法来寻找奖励函数。关键问题是:这个问题的解 Q* 是什么?能否在不采用复杂的全新优化程序的情况下找到它?

3.2 从下一 Token 预测获得 IRL 解

现在证明,公式 (6) 中 Q* 的解不需要从头计算。相反,它已经体现在任何使用标准下一 token 预测目标训练的语言模型的 logits 中。

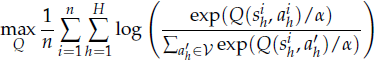

将 IRL 优化目标通过指-对转换,变为最大似然形式:

这一表达式中,softmax(Q(sₕ, ·); α) 定义了策略 π_Q,因此该优化问题目标是找到对应策略 π_Q 能最大化专家数据似然的 Q 函数。

而标准的下一 token 预测训练过程,其目标正是最大化训练数据的似然对应的策略

![]()

其中 f̂ 即 LLM 的 logits。

因此,LLM 的 logits f̂ 实际上已经是上述 IRL 优化问题的最优解。本文形式化提出以下命题:

命题 1:令 π̂ 为通过下一个 token 预测训练的 LLM,其策略满足 π̂(·|sₕ) = softmax(f̂(sₕ, ·); α),则其 logits f̂ 即为离线 IRL 优化问题的最优解。

这一命题是本文的理论核心,表明 LLM 的 logits 不只是用于生成 token 的分数,而是从原则上代表了最优 Q 函数,隐式地蕴含了训练数据中的最优奖励函数。

这一发现统一了生成与评估的视角:策略 π̂ 负责生成,logits f̂ 则承载评估能力。

3.3 内生奖励的定义

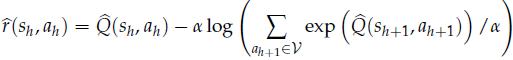

基于命题 1,本文提出了一种无需额外训练、基于 logits 提取奖励的训练自由方法。给定任何经过下一 token 预测训练的 LLM,可直接将其 logits Q̂ = f̂ 代入 inverse soft Bellman operator (公式 (7)):

此外,定义表示状态 s 预期未来的值函数

![]()

则内生奖励可重写为:

![]()

本文进一步从以下三个方面详细阐述这种内生奖励:

奖励整形视角:从上述公式可见,内生奖励 r̂ 可被看作是 LLM 的 log-probability(即 log π̂(aₕ | sₕ))与潜在函数 V_{Q̂} 的奖励整形。根据奖励整形(reward shaping)理论,r̂ 与 log-probability 所诱导的最优策略相同。

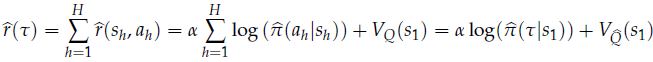

结果奖励视角:对于完整响应 τ = (s₁, a₁, …, s_H, a_H),累积内生奖励为:

由于终止边界条件 Q̂(s_{H+1}, ·) ≡ 0,这一公式中的奖励总和实际上等同于完整响应的 log-probability,外加仅与起始状态相关的常数项 V_{Q̂}(s₁)。换言之,模型在训练数据中生成频率高的响应,其奖励值也更高。

与现有生成式奖励模型的关系:上述结果表明,内生奖励提供了一个普适框架,将现有的生成式奖励模型纳入其中。例如,Zhang 等人的生成验证器(Generative Verifier)本质上是在特定 prompt 下评估 token “Yes” 的生成概率,这与上述公式在特定设定下完全一致。因此,本文的理论也为这些生成式奖励模型提供了理论依据。

4. 内生奖励的理论证明

4.1 内生奖励的误差分析

定理 1:在 token 级 MDP 中,假设专家策略 π^E 为熵正则的(entropy-regularized)最优策略,π̂ 为下一 token 预测训练得到的策略,r̂ 为内生奖励。对于任意响应对 (τ, τ'),有:

![]()

![]()

![]()

![]()

其中 D_{TV} 为两个分布 p、q 的总变差距离(total variation distance)。

该定理表明,只要 LLM π̂ 的 log-probability 接近专家策略 π_E,则内生奖励 r̂ 诱导的偏好分布与真实偏好分布之间的距离就很小。这意味着从 LLM 中提取的内生奖励能够可靠继承模型的性能。

4.2 使用内生奖励微调后的策略误差分析

考察两种策略:

-

直接通过下一 token 预测训练的基础策略 π̂;

-

使用内生奖励 r̂ 进行强化学习优化得到的新策略,π^{RL},即

![]()

目标是比较两者在真实奖励 r* 下的次最优性误差。

定理 2:在 token 级 MDP 中,假设专家策略 π^E 为熵正则的最优策略,π̂ 为基础策略,r̂ 为内生奖励。使用 r̂ 进行强化学习得到策略 π^{RL},则有:

![]()

![]()

其中 V^π_r 表示策略 π 在奖励 r 下的值。

该定理显示,π^{RL} 的误差仅线性依赖响应长度 H,而 π̂ 的误差呈二次增长。二次误差源于模仿学习中的误差累积现象,而通过内生奖励先提取奖励再进行强化学习,可显著缓解这一问题。这种线性优势在无限时间场景下也成立。

4.3 自我迭代优化的无效性

一个自然的问题是,是否可以对 π_{RL} 再次提取内生奖励并进行强化学习,从而持续提升性能?

答案是否定的。理论上,π_{RL} 已是内生奖励 r̂ 下的最优策略,提取 π_{RL} 的内生奖励仍等同于 r̂,因而后续强化学习不会带来任何变化,训练过程会立即收敛。

5. 实验

本章旨在通过实证实验验证本文的理论主张,主要聚焦以下三个核心问题:

-

Q1:内生奖励模型(endogenous reward model,EndoRM)在奖励模型评测基准上的表现如何?与现有无训练基线方法及最优奖励模型相比,其效果如何?

-

Q2:内生奖励是否具备强大的指令跟随能力,能否作为可提示的通用奖励模型?

-

Q3:利用内生奖励进行强化学习,是否能够实现理论预测中的自我改进效果?

5.1 实验设置

数据集:

-

RM-Bench:用于评测不同奖励模型的通用性能,验证 Q1;

-

Multifaceted-Bench 和 Domain-Specific Preference (DSP) 数据集:用于测试内生奖励的指令跟随能力,验证 Q2;

-

MATH-lighteval:用于检验基于内生奖励的强化学习能否带来自我改进,验证 Q3。

评测指标:

-

在 RM-Bench、Multifaceted-Bench 和 DSP 数据集中,度量奖励模型在给定 prompt 下对两条响应的分类准确率;

-

在 RL 实验中,采用五个数学推理基准(AIME 2024、AMC、Minerva、OlympiadBench、MATH-500)进行测试,报告 avg@32 或 pass@1 准确率。

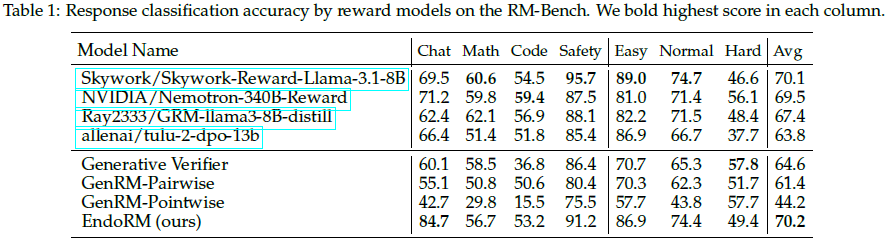

5.2 多样化偏好对的奖励准确率评测(Q1)

在 RM-Bench 上测试不同奖励模型对响应的选择准确率。由于 EndoRM 无需训练,本文将其与其他无训练方法(如 Generative Verifier、GenRM-Pairwise、GenRM-Pointwise)对比,所有基线和 EndoRM 均基于 Qwen2.5-7B-Instruct 模型,确保公平性。同时,报告四个顶尖显式训练奖励模型的结果作为对照。

结果分析:

-

EndoRM 在所有无训练基线中表现最佳,且在多个指标上超过了显式训练的最优奖励模型;

-

在聊天、数学、代码、安全等子任务中,EndoRM 综合表现最强,尤其在聊天与安全任务中明显领先;

-

这表明内生奖励不仅无需训练,还能超越昂贵的显式奖励模型。

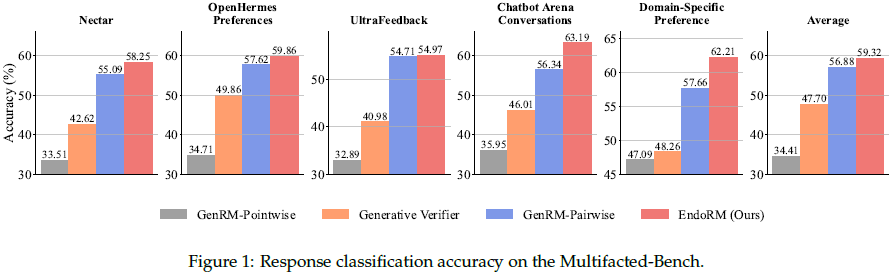

此外,在 Multifaceted-Bench 上进一步评测 EndoRM。结果显示,EndoRM 在所有五个子领域中均优于基线,展现了极高的稳健性与可扩展性,能够适应多样的偏好和复杂任务。

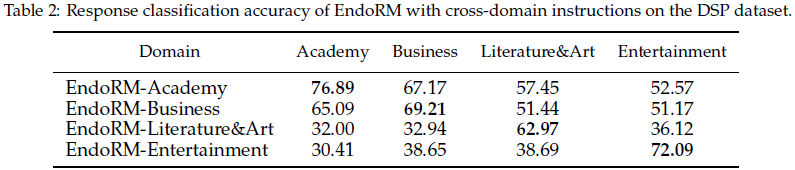

5.3 验证指令跟随能力(Q2)

本节进一步测试内生奖励的可提示性。具体方法为:在 DSP 数据集中,为内生奖励分别输入四个不同领域的系统提示,生成四个特化版本的内生奖励模型,并分别在四个测试集上评测其表现。

结果分析:

-

出现明显的 “对角线效应”:每个特化的内生奖励在对应领域上的准确率最高;

-

例如,EndoRM-Academy 在学术领域上的准确率高达 76.89%,而在其他领域则相对较低;

-

这证明内生奖励模型不仅是固定的评审器,还具备动态、可提示的特性,能够继承基础 LLM 的强大指令跟随能力。

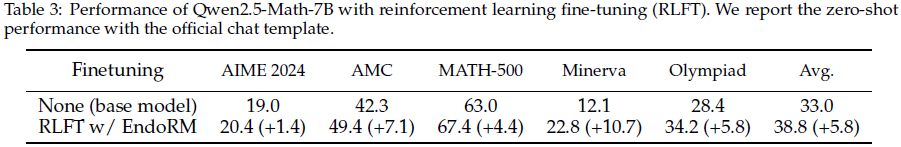

5.4 基于内生奖励的强化学习实现自我改进(Q3)

本节验证了理论中的核心命题——使用内生奖励进行强化学习能否实现自我改进。实验中,我们使用 Qwen2.5-Math-7B 作为基础模型,在 MATH-lighteval 数据集上利用 EndoRM 进行强化学习微调(RLFT)。

训练设置:

-

prompt 和响应的最大长度均设为 1024;

-

KL 正则系数设置为 0.01;

-

RL 训练过程中,内生奖励模型参数保持固定,仅更新策略。

结果分析:

-

微调后的模型在所有五个数学基准上均优于基础模型;

-

在 AIME 2024、AMC、Minerva、OlympiadBench 和 MATH-500 上平均提升 5.8 个百分点;

-

在具体问题中,强化学习后的模型不仅成功求解问题,还显著改善了输出逻辑,避免了未优化模型中出现的胡言乱语现象。

6. 相关工作

6.1 RLAIF 与 LLM-as-a-judge

最成熟的替代人类标注的方法是 基于 AI 反馈的强化学习(Reinforcement Learning from AI Feedback,RLAIF),通常通过 “LLM 作为评审”(LLM-as-a-judge)框架实现。

在该范式中,一个强大的专有 “教师” 模型(如 GPT-4)被用作评审,评估较小的 “学生” 模型输出。

具体实现方式包括:

-

生成直接的数值评分;

-

表达对两条候选响应的成对偏好;

-

提供结构化的自然语言点评,再用于指导对齐。

代表性工作包括 Bai 等人、Pang 等人和 Lee 等人提出的研究。虽然这类方法已被证明高效且具成本优势,但其本质仍属 启发式方法:

-

假设教师模型的评审可靠、能代表人类价值;

-

容易传递教师模型的风格偏差和缺陷。

6.2 生成式奖励模型

最近,生成式奖励模型(Generative Reward Models, GenRMs)成为新兴方向。

- 该类方法将奖励建模视作下一 token 预测任务,不输出具体的标量评分,而是通过模型生成特定 token 或序列的概率来定义奖励

- 例如:Mahan 等人和 Zhang 等人提出的方法,通常使用 token “Yes” 或其他标志性 token 表示答案正确性或输出质量。

此外,还有 RLIF(Reinforcement Learning from Internal Feedback)方法,利用模型内部的 “自我确信度”(self-certainty)构造奖励信号。

尽管这些方法在实践中有效,且成本较低,但仍属于 启发式方法,缺乏理论保证。

6.3 DPO 及其扩展方法

直接偏好优化(Direct Preference Optimization, DPO)及其扩展(如 IPO、KTO)属于另一类方法,完全绕过显式奖励建模。其核心思想是:

-

将 RLHF 目标重构为简单的分类损失;

-

直接在偏好对上训练语言模型。

值得注意的是,DPO 方法虽然不训练显式奖励模型,但其最优策略等价于在某个隐含奖励函数下通过 RLHF 学习得到的策略。因此,DPO 实际上仍隐含 依赖于偏好数据集,无论该数据集是由人类还是 AI 生成。

6.4 本文方法的差异与创新

相比上述所有方法,本文提出了全然不同的范式:

-

不依赖外部模型生成奖励信号;

-

不依赖偏好数据集;

-

不需要额外训练;

-

理论上证明了,奖励函数是任何通过下一 token 预测训练的模型的 内在属性。

具体而言,本文首次建立了标准语言模型训练目标与离线逆强化学习(IRL)之间的严格等价关系,从而能直接 揭示并提取模型内生的奖励函数。这一方法理论扎实、无需训练、完全独立于外部评审器或偏好数据,开创了奖励建模的新范式。

6.5 与近期 IRL 在 LLM 中的应用的区别

近年来,部分工作开始将逆强化学习(IRL)方法引入 LLM 领域。这些方法通常关注于:

-

在后训练阶段,从高质量人类示范中学习奖励模型;

-

侧重特定下游任务的奖励建模。

本文方法与这些研究有本质区别:

-

本文目标是 通用奖励模型,不针对特定任务;

-

本文方法 无需额外训练数据,直接从预训练模型中提取奖励,自然继承 LLM 在预训练期间已学到的能力。

7. 讨论

7.1 模型对齐范式的变革

本文方法最直接的影响在于彻底简化了传统的三阶段对齐流程。具体而言:

-

在传统 RLHF 流程中,奖励建模是必不可少的独立阶段;

-

本文方法则完全消除了这一阶段,因为内生奖励可以直接从模型中提取,无需训练奖励模型;

-

原本用于奖励建模的人类偏好数据可以直接用于预训练或监督微调阶段,从而进一步增强模型的内生奖励能力;

-

这种方法实质上类似于强化学习预训练(reinforcement pre-training)思想,但更加原则化、理论上更稳固。

(2025|微软 & 北大 & 清华,下一 token 推理 / NTR,下一 token 预测,强化学习,LLM)强化预训练

优势:

-

显著降低工程复杂性;

-

节省大量计算资源和开发时间;

-

加快对齐模型的开发与部署速度。

7.2 个性化与可控性的增强

传统的外部奖励模型通常是基于静态数据集训练的,其行为固定、难以个性化调整。而内生奖励具备天然的动态性和可控性:

-

内生奖励可以通过自然语言提示(prompt)动态改变;

-

用户只需更改指令即可引导模型学习特定价值观,无需额外训练;

-

这使对齐过程从静态的、后验的过程,转变为动态、交互式的对话过程。

潜力:

-

实现高度个性化的 AI;

-

支持用户或企业特定的偏好需求;

-

提供即时、灵活的模型行为调整机制。

7.3 新型强化学习蒸馏方法

本文方法为知识蒸馏提供了一种更原则性的替代方案:

-

传统蒸馏方法(如软标签蒸馏、模仿蒸馏)通常强制学生模型模仿教师模型的输出;

-

RLHF 变种方法(如 RLAIF)则通过教师模型生成偏好标签来训练中间奖励模型,过程间接且复杂;

-

本文方法则直接从教师模型 logits 中提取内生奖励信号,用于强化学习,指导学生模型;

-

学生模型不再只是模仿表面输出,而是通过 RL 优化,学习教师模型更深层次的判断逻辑。

优势:

-

更直接高效;

-

有助于学生模型捕获教师模型的细致能力;

-

潜在提升蒸馏后的模型质量与泛化能力。

7.4 超越文本的强化学习扩展

RLHF 在文本领域已相对成熟,但在图像、视频、音频等多模态场景中,因人类标注困难、成本高昂,扩展性极差。而内生奖励机制具备跨模态的天然优势:

-

只要模型具备自回归结构(包括图像生成、视频生成、音乐生成模型),就可以使用内生奖励;

-

多模态模型只需基于 prompt 自我评估生成质量,无需外部标注;

-

为多模态 AI 的对齐、质量控制与可控性提升开辟了可扩展、低成本的新路径。

7.5 局限性与未来工作

尽管内生奖励具备诸多优势,但仍存在潜在风险:

-

内生奖励完全依赖模型自身的 “世界观”;

-

如果基础模型在训练过程中已学入偏见或不良模式,内生奖励可能进一步放大这些问题;

-

模型可能在强化学习中“自我奖励”虚假、错误甚至有害的输出。

未来研究方向:

-

探索混合方法,如结合内生奖励与人类监督,利用稀疏但高质量的人类反馈矫正模型偏差;

-

系统性研究如何通过提示工程(prompt engineering)安全、稳健地引导内生奖励;

-

发展针对内生奖励的偏差检测与修正机制,确保其在实际应用中安全、可靠。

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献31条内容

已为社区贡献31条内容

所有评论(0)