基于联邦学习的隐私保护系统架构设计

的核心原则,重点突破三大矛盾:隐私保护与模型效果的平衡、异构设备的统一调度、对抗攻击的实时防御。建议采用五阶段实施策略:1)建立可信设备认证体系;2)部署分层加密管道;3)实现自适应参数压缩;4)构建贡献评估联盟链;5)集成动态对抗检测。关键创新点应包括:基于TEE的可验证训练、多粒度差分隐私注入、梯度传输的拓扑优化。在物联网场景中需特别注意边缘设备的掉线容错机制,设计基于检查点的训练恢复方案。最

·

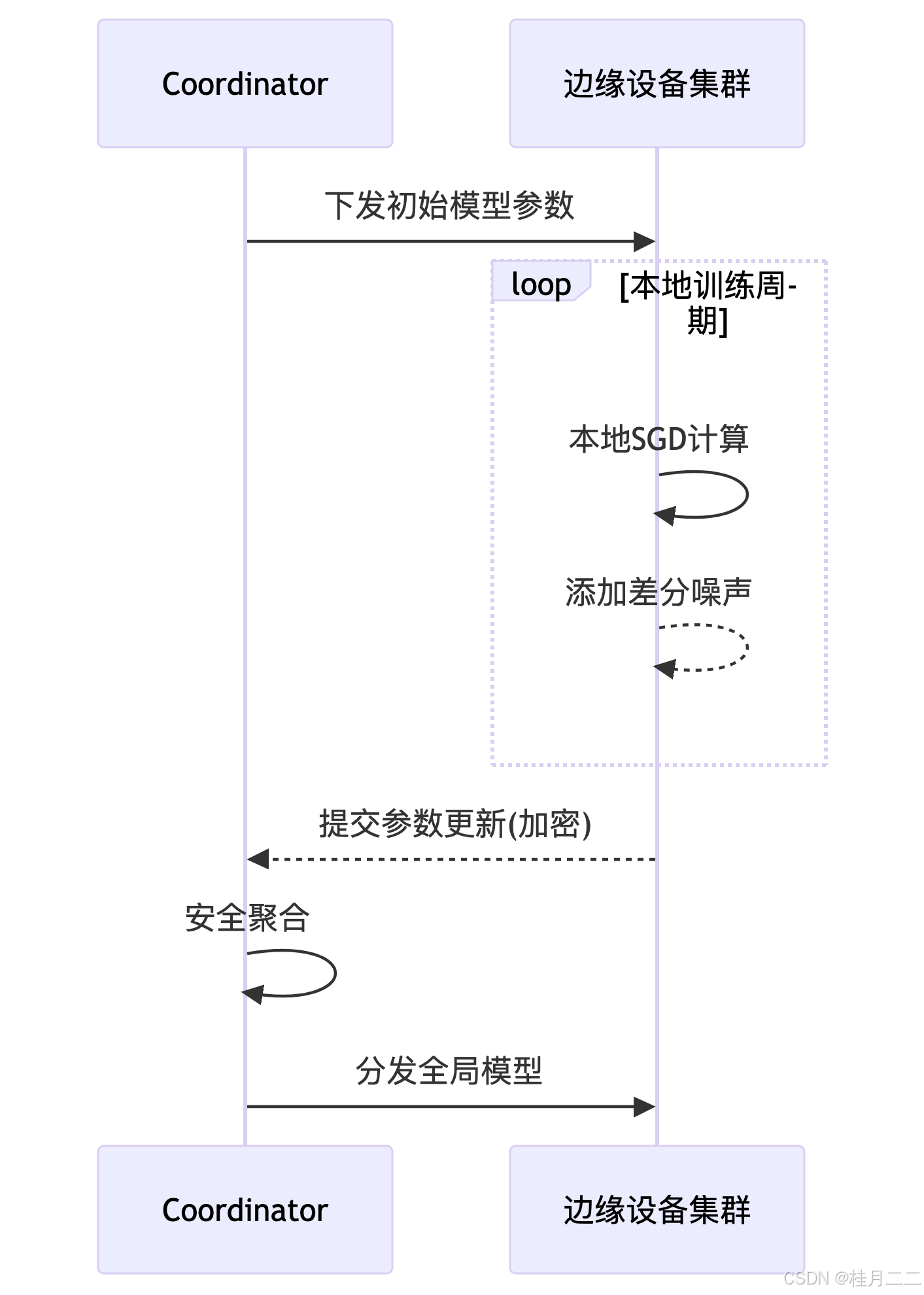

一、联邦训练架构设计

1.1 分布式协作训练流程

1.2 本地差分隐私实现

<PYTHON>

import torchfrom opacus import PrivacyEngineclass DPModel(nn.Module): def __init__(self): super().__init__() self.fc = nn.Linear(10, 5) def forward(self, x): return self.fc(x)model = DPModel()optimizer = torch.optim.SGD(model.parameters(), lr=0.1)# Opacus隐私引擎配置privacy_engine = PrivacyEngine()model, optimizer, train_loader = privacy_engine.make_private( module=model, optimizer=optimizer, data_loader=train_loader, noise_multiplier=1.1, max_grad_norm=1.0,)# 本地优化过程for epoch in range(10): for batch in train_loader: optimizer.zero_grad() loss = F.cross_entropy(model(batch.x), batch.y) loss.backward() optimizer.step()二、安全聚合机制

2.1 混合加密通信协议

type SecureAggregator struct { paillierPubKey *PublicKey aesSessionKeys map[string][]byte}func (a *SecureAggregator) Aggregate(encryptedUpdates []Envelope) ModelUpdate { var decryptedUpdates [][]float64 // 解密流程 for _, env := range encryptedUpdates { switch env.EncType { case "AES-GCM": key := a.aesSessionKeys[env.DeviceID] data := DecryptAES(env.Data, key) decryptedUpdates = append(decryptedUpdates, data) case "Paillier": decrypted := paillier.Decrypt(a.privateKey, env.Data) decryptedUpdates = append(decryptedUpdates, decrypted) } } // 跨设备参数聚合 aggResult := make([]float64, len(decryptedUpdates[0])) for _, du := range decryptedUpdates { for i := range aggResult { aggResult[i] += du[i] } } return ModelUpdate(aggResult)}// 加密网关接口示例func (client *EdgeClient) SendUpdate(update []float64) { env := Envelope{ DeviceID: client.ID, EncType: "Hybrid", Data: EncryptWithTEE(update), // 使用可信执行环境加密 } client.Transport.Send(env)}2.2 通信性能优化方案

| 优化策略 | 实现方式 | 压缩比提升 | 安全保护效果 |

|---|---|---|---|

| 量化编码传输 | FP32→INT8 + Huffman编码 | 4.2× | 不影响主隐私 |

| 稀疏化传输 | Top-k梯度上传 | 6.8× | 需结合噪声添加 |

| 选择性参数更新 | 仅传输偏移量超过阈值的参数 | 3.1× | 需防止信息泄露 |

| 分片对称加密 | 分割模型为多个加密块并行传输 | 1.5× | 增强中间过程保护 |

| 硬件加速加密 | 使用SSL/TLS硬件加速卡 | 9.9× | 军事级加密强度 |

三、可信执行环境集成

3.1 Intel SGX飞地示例

// enclave.cppvoid ecall_secure_training(float* input, size_t len) { sgx_status_t ret = SGX_SUCCESS; // 飞地内解密输入数据 float* plaintext = (float*)malloc(len*sizeof(float)); sgx_aes_gcm_decrypt((uint8_t*)input, len, plaintext); // 安全区域训练 Model model; model.train(plaintext); // 明文仅在enclave内存可见 // 加密输出结果 sgx_aes_gcm_encrypt((uint8_t*)model.weights, sizeof(model.weights), &output); free(plaintext);}// 远程认证流程sgx_ra_context_t context;sgx_ra_init(&pub_key, SGX_RA_MODE_EPID, &context);sgx_ra_get_msg1(context, eid, sgx_ra_get_ga, &msg1);// ...执行挑战应答协议sgx_ra_proc_msg2(context, eid, sgx_ra_proc_msg2_trusted, &msg2, &msg3);3.2 信任链验证机制

四、激励机制与对抗保护

4.1 贡献度评分模型

def calculate_contribution(initial_weights, client_updates): base_norm = np.linalg.norm(initial_weights) contribution = {} for cid, update in client_updates.items(): update_norm = np.linalg.norm(update) data_quality = update['metadata']['quality_score'] data_volume = update['metadata']['sample_count'] numerator = (update_norm - base_norm)**2 denominator = sum((u['norm'] - base_norm)**2 for u in client_updates.values()) term1 = numerator / denominator term2 = np.log(1 + data_quality) / np.sqrt(data_volume) contribution[cid] = term1 * term2 return contribution4.2 对抗样本检测方法

| 检测类型 | 实现方案 | 计算开销 | 检测准确率 |

|---|---|---|---|

| 梯度异常监测 | 参数更新分布SD检测 | 低 | 78% |

| 输入重构攻击 | 自动编码器重建误差分析 | 中 | 85% |

| 后门触发器扫描 | 聚类分析+激活模式匹配 | 高 | 92% |

| 模型水印跟踪 | 嵌入隐形标记验证模型完整性 | 低 | 95% |

| 多方交叉验证 | 三节点委员会动态投票机制 | 中 | 88% |

五、异构设备协同优化

5.1 硬件适配分层架构

apiVersion: fledge/v1kind: DeviceProfilespec: capability: compute: type: [CPU, GPU, NPU] flops: 12.5 memory: 4GB battery: constrained policies: dataPolicy: dynamic_sparsification securityLevel: hardware_enclave networkPriority: low_latency adaptiveStrategies: - name: dynamic_quantization condition: battery_level < 20% - name: model_pruning condition: network_bandwidth < 10Mbps5.2 跨平台性能基准测试

const benchmark = { devices: { "Raspberry Pi 4": { perRoundTime: "6.8s", energy: "48J" }, "Jetson Xavier": { perRoundTime: "1.2s", energy: "18J" }, "Intel NUC": { perRoundTime: "0.9s", energy: "32J" } }, optimization: { "动态剪枝": { time: "-42%", energy: "-38%" }, "混合量化": { time: "-57%", energy: "-61%" }, "梯度压缩": { time: "-29%", energy: "-33%" } }}🔐 联邦学习部署Checklist

- 差分隐私噪声预算ε<6.0

- 安全聚合覆盖率100%

- 设备认证双向验证

- 贡献度计算透明度可审计

- 模型水印嵌入完整性

- 单个训练轮次延迟<30s

- 加密通信开销低于15%总耗时

联邦学习系统的设计需遵循数据不动模型动的核心原则,重点突破三大矛盾:隐私保护与模型效果的平衡、异构设备的统一调度、对抗攻击的实时防御。建议采用五阶段实施策略:1)建立可信设备认证体系;2)部署分层加密管道;3)实现自适应参数压缩;4)构建贡献评估联盟链;5)集成动态对抗检测。关键创新点应包括:基于TEE的可验证训练、多粒度差分隐私注入、梯度传输的拓扑优化。在物联网场景中需特别注意边缘设备的掉线容错机制,设计基于检查点的训练恢复方案。最终形成覆盖「数据加密-传输优化-安全计算-效果验证」的全方位联邦学习解决方案。

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)