(RL强化学习)PPO

文章目录PPO(proximal Policy Optimization)On-policy Off-policy为什么需要Off-PolicyImportant SamplingOff-policy的gradientPPOPPO(proximal Policy Optimization)On-policy Off-policyOn-policy:跟环境互动的agent 和 要learn的agen

·

文章目录

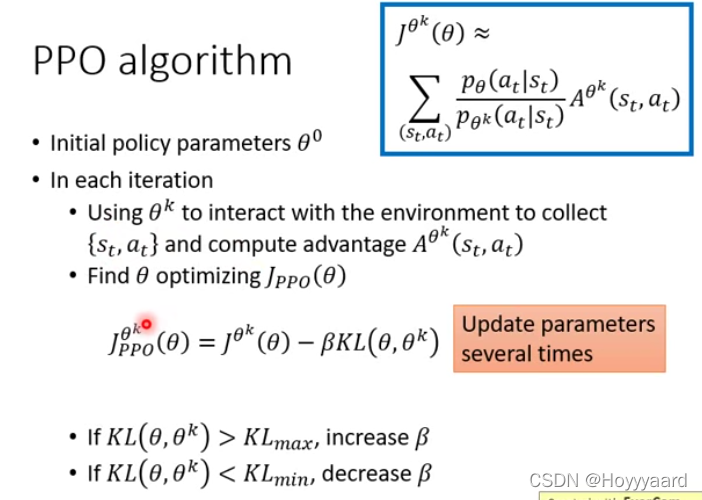

PPO(proximal Policy Optimization)

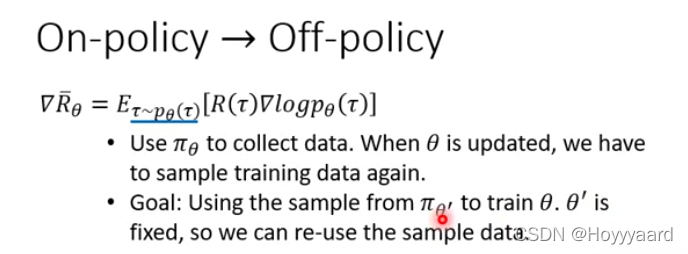

On-policy Off-policy

- On-policy:跟环境互动的agent 和 要learn的agent是同一个

- Off-policy:跟环境互动的agent 和 要learn的agent不是同一个

为什么需要Off-Policy

-

On-policy中每用一个policy gradient 就需要重新sample 一次data

-

使用Off-policy可以用另一个actor sample 一次data 这个actor就可以用这个data policy gradient很多次

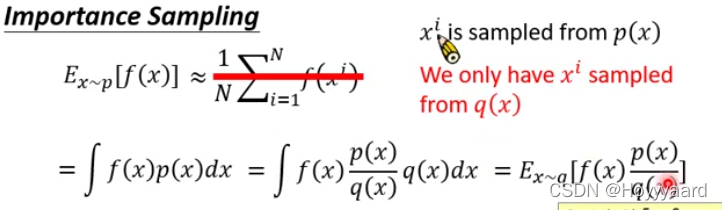

Important Sampling

-

当两个actor sample出来的data 分布不一样的时候 需要引入一个修正项

-

这里p分布为学习的actor q分布为被学习的actor、

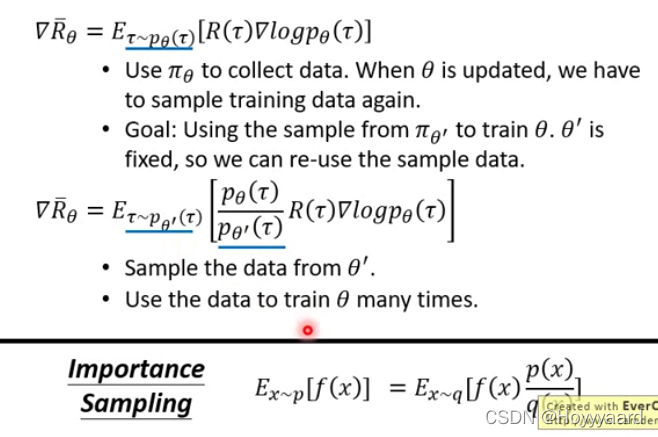

Off-policy的gradient

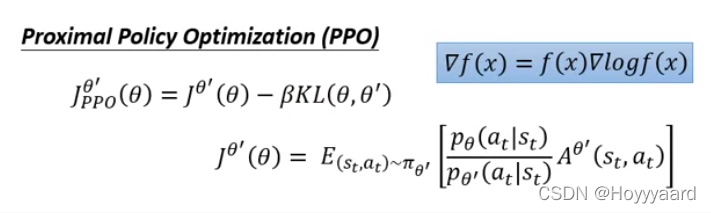

PPO

- off-policy

- 增加一项衡量两个actor的相似度 希望两个actor越像越好

-

算法流程

- 被learn的actor sample一组数据后learn的actor更新多次参数后 被learn的actor再次sample

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)