基于知识图谱的医疗问答系统部分细节

随着医疗行业的快速发展和医学知识的不断积累,如何高效、准确地获取疾病相关信息,成为提升医疗诊断水平和优化患者服务的重要课题。传统的医疗知识获取方式往往依赖人工查阅文献或基于关键词的检索,存在信息分散、查询效率低、难以精准匹配患者需求等问题。知识图谱技术的兴起,为构建高质量的医学知识库提供了技术支撑。基于此,本文围绕医学知识图谱的构建与应用展开研究,旨在开发一个高效、智能的医疗问答系统,以便快速分析

摘要

随着医疗行业的快速发展和医学知识的不断积累,如何高效、准确地获取疾病相关信息,成为提升医疗诊断水平和优化患者服务的重要课题。传统的医疗知识获取方式往往依赖人工查阅文献或基于关键词的检索,存在信息分散、查询效率低、难以精准匹配患者需求等问题。知识图谱技术的兴起,为构建高质量的医学知识库提供了技术支撑。基于此,本文围绕医学知识图谱的构建与应用展开研究,旨在开发一个高效、智能的医疗问答系统,以便快速分析并解答患者及医务人员的医学相关问题。

本研究的主要内容与创新点如下:

(1)医学命名实体识别研究: 医学文本数据中包含大量的长实体和嵌套实体,例如疾病名称、药品、症状及检查项目等,传统的命名实体识别(NER)方法在处理此类数据时,容易出现实体断裂或误识别的情况,降低了医学知识的抽取精度。为了解决这一问题,本文提出了一种新的医学命名实体识别模型——BERT-CSD-BiLSTM-SCRF,该模型能够更准确地识别医学文本中的关键实体,从而提高医学知识抽取和处理的效率。

(2)智能医疗问答算法研究: 传统的医疗问答系统通常基于分词、模板匹配和语义分析技术来理解用户问题,但由于医学术语的复杂性和问句表述的多样性,传统方法容易导致问句理解偏差,影响答案的准确性。针对这一问题,本文提出了一种基于深度学习的智能医疗问答算法,能够更精准地识别用户的意图,并从医学知识图谱中提取最相关的信息,以提供更准确、专业的解答,帮助医生和患者更高效地获取医疗知识。

关键词:医疗知识图谱、智能问答系统、医学命名实体识别(NER)、深度学习

相关技术与理论基础

知识图谱构建技术

知识图谱是一种以三元组形式构成的结构化语义网络,包括“<实体、关系、实体>”和“<实体、属性、属性值>”两种关系。实体通过唯一标识区分,关系链接实体,属性补充实体信息,形成复杂的知识网络。

构建方式主要分为自顶向下和自底向上。前者从结构化资源中提取本体和模式信息,逐步扩展知识库;后者从公开资源获取数据,经过技术处理和人工审核后纳入知识库。随着需求的增加,融合两者的创新方式成为主流。

知识图谱的构建涉及知识抽取、融合、推理、计算和存储。其中,知识抽取从多数据源提取信息,是图谱构建的基础;知识融合解决异构数据问题,实现互联互通,提高知识质量;知识推理是核心能力,为精细化工作和决策提供支持。早期实体识别依赖规则匹配,成本高且通用性差,近年来,结合自然语言处理和深度学习的方式提升了抽取效果,如 BiLSTM-CRF 用于序列标注,端到端模型优化实体关系联合抽取。知识融合通过实体对齐和消歧提高数据一致性,双重注意力模型、关系语义建模等技术优化实体对齐。

存储方式主要包括关系数据库(如 MySQL,稳定但查询性能一般)、RDF 三元组数据库(如 GraphDB,常用于存储三元组,但占用空间大)、原生图数据库(如 Neo4j,专门优化属性图结构,存取高效)。

智能问答技术

智能问答系统通过自然语言交互,使用户能够快捷、精确地获取信息,满足现代社会对高效信息检索的需求。根据答案的来源,问答系统可以分为多种类型,其中基于知识库的问答系统近年来发展迅速,主要包括基于语义解析、深度学习和知识图谱的方法。

1. 基于语义解析的问答方法

基于语义解析的方法主要依靠对用户输入的问句进行预处理,从中提取有用信息并转换成逻辑表达式,进而构建查询语句,在知识库中进行查询,最终得到相应的答案。其主要步骤包括:

- 语义解析:对问句进行实体识别,并将其与知识库中的实体进行匹配,常见方法包括使用模板匹配、词汇表和相似度计算等。

- 查询构建:根据解析结果构造查询语句,常用的查询语言包括Neo4j的Cypher和RDF知识库的SPARQL。

- 知识库查询与答案输出:执行查询语句并返回相应答案。

基于语义解析的方法能够精准地将用户的问题映射到知识库查询逻辑上,因而在问答任务上表现优秀。然而,其主要缺点在于需要大量人工标注数据,训练成本较高,同时在新领域的移植和扩展性较差。

2. 基于深度学习的问答方法

随着深度学习技术的快速发展,研究人员将其应用于问答系统,以期减少人工干预,自动理解用户问题并生成答案。基于深度学习的方法不依赖于固定模板或规则,而是通过海量数据的学习来提升问答能力。然而,这类方法往往可解释性较差,且返回的答案可能缺乏可控性。

近年来,神经网络模型在自然语言表示学习方面的研究得到了广泛关注。其中,词嵌入(Word Embedding)技术通过将文本转换为低维、连续的向量表示,提高了语言模型的学习能力。例如,BERT(Bidirectional Encoder Representations from Transformers)模型在主题挖掘、信息检索和问答任务中展现出了良好的性能。

常见的基于深度学习的语义表示模型包括:

- 基于卷积神经网络(CNN)的方法:利用卷积和池化操作进行特征提取,通过不同的卷积核获取多层次特征。然而,CNN模型通常网络层数较浅,难以捕捉复杂句子的深层特征。

- 基于循环神经网络(RNN)的方法:将句子视为连续的词语序列,其中长短期记忆网络(LSTM)能够有效学习上下文信息,在问答、机器翻译等领域广泛应用。例如,改进型BiLSTM(双向长短期记忆网络)结合多头注意力机制,可提升多轮对话任务的响应准确率。

尽管基于深度学习的方法具备自动化程度高的优势,但仍然面临数据依赖严重、可解释性不足等问题,因此在实际应用中往往结合其他方法进行优化。

3. 基于知识图谱的问答方法

基于知识图谱的问答系统以知识图谱作为核心数据来源,解析自然语言问句并构建查询语句,最终返回结构化的答案。其主要研究内容包括:

- 问句实体抽取:从用户输入的问句中识别出关键实体,如疾病、药物等。

- 问句意图理解:分析用户意图,确定查询范围,并在知识图谱中定位相关子图。

- 实体链接:将问句中的实体与知识图谱中的实体进行匹配。

- 答案查询与输出:根据解析出的查询逻辑,在知识图谱中查找答案并返回。

目前,基于知识图谱的问答方法结合了深度学习等技术,不断取得技术突破,在医疗、金融、教育等领域得到了广泛应用。相较于传统基于语义解析的方法,知识图谱问答系统能够提供更加精准、可解释的答案,同时具备良好的扩展性。

4. 研究目标与应用

本文的研究重点是利用高质量医疗数据构建知识图谱,并针对问句解析进行深入研究,以优化问答系统的性能。通过结合语义解析、深度学习和知识图谱技术,提升问答系统的精准度,使其在医疗信息检索、智能诊断等场景中发挥更大作用。

语言模型

自然语言处理(NLP)的核心研究目标是使计算机能够精准理解用户输入的语音或文本信息,并在保持语义完整的前提下,将这些信息转换为模型可以识别的数值向量。随后,模型对转换后的信息进行处理,计算词语在句子中出现的概率,从而实现“词嵌入”——即将词语表示为数值向量的方式。如今,词嵌入技术被广泛应用于机器翻译等 NLP 任务。

最早的词嵌入方法可以追溯到 20 世纪 60 年代的 One-Hot 编码,该方法利用二进制向量对分类变量进行表示。在 One-Hot 编码中,每个词被映射为一个高维向量,其中仅有一个位置的值为 1,其余均为 0,这个唯一的“1”对应词在词典中的位置。虽然这种方法直观且易于实现,但存在维度过高、向量稀疏、计算成本大等问题。此外,One-Hot 编码无法表达词语之间的相似性或语义关系。

为了解决这些局限性,Hinton 等人[39] 提出了分布式词表示方法,即词向量。与离散的 One-Hot 编码不同,词向量使用固定长度的连续稠密向量来表示词语,从而能够捕捉词汇之间的语义关联。这种方法不仅降低了数据处理的空间和计算成本,还能够更有效地表示词语之间的关系,因此在 NLP 任务中得到了广泛应用。

Word2vec模型

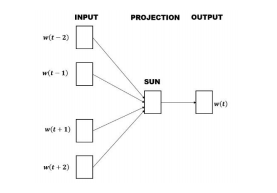

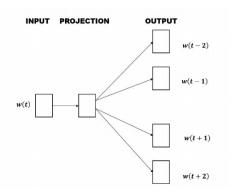

Word2vec 是 Google 公司于 2013 年开源的一个文本转词向量表示的模型。它基于神经网络,通过将词语映射到一个实数向量空间来表示词语的语义。每个词语的向量长度是可调的,使得生成的词向量既能保留词语的原始语义,又能有效地表达词与词之间的关系。Word2vec 提供了两种训练方式:CBOW(Continuous Bag of Words)模型和 Skip-gram 模型。

CBOW 模型通过上下文来预测中心词。它的输入是预测词的上下文的 One-Hot 编码。该编码与共享的输入权重矩阵相乘,得到一个向量,之后将这些向量相加并求平均,得到隐层向量。隐层向量再与输出权重矩阵相乘,经过激活函数处理后,得到一个维度为词汇表大小的概率分布。最终,模型预测概率最大的词作为中心词。通过梯度下降法更新权重矩阵,最终输出的词向量就是我们所需的词嵌入。

CBOW模型

Skip-gram 模型则是通过已知的中心词来预测周围的上下文词。它的输入是中心词的 One-Hot 编码,通过与隐层的权重矩阵相乘得到隐层向量,再通过与隐层和输出层之间的权重矩阵相乘得到输出结果。

Skip-gram模型

Word2vec 的通用性强,广泛应用于许多领域。然而,Word2vec 也存在一些问题。首先,它为每个词生成一个固定的向量表示,忽略了上下文的变化,因此对于多义词的处理效果较差,且不能有效捕捉长距离语义关系。其次,Word2vec 是静态模型,无法根据特定任务进行优化,因此在某些专业领域的表现可能不尽如人意。

BERT模型

BERT(Bidirectional Encoder Representations from Transformers)是由 Google 于 2018 年提出的预训练语言模型,它基于 Transformer 架构,能够通过深度双向训练学习词语的上下文表示。与传统的词嵌入模型(如 Word2vec)不同,BERT 不仅考虑单词本身的含义,还能够考虑其在上下文中的语境,因此在很多自然语言处理(NLP)任务中表现优异。

BERT 模型的关键思想是“上下文双向性”,即它能够同时从左到右和从右到左学习词语的上下文信息。传统的单向模型(如 Word2vec 和 LSTM)只能在一个方向上捕捉上下文信息,而 BERT 通过遮掩(Masked)部分单词,使模型能够通过上下文信息推测被遮掩的单词。

BERT 模型可以通过“预训练 + 微调”来适应医疗领域的特定任务。例如,在医疗问答系统中,BERT 可以用来回答病人关于疾病、症状、药物等问题。以下是基于 BERT 的医疗问答示例:

示例 1:疾病症状查询

- 问题*流感有哪些常见症状?

- 上下文:流感是一种由流感病毒引起的呼吸道疾病。其常见症状包括发热、咳嗽、喉咙痛、肌肉疼痛、头痛等。

- BERT 输出:发热、咳嗽、喉咙痛、肌肉疼痛、头痛

在这个例子中,BERT 能够理解问题“流感有哪些常见症状?”的语义,并从上下文中提取出与流感相关的症状。

BERT 的训练过程包含两个主要任务:

-

Masked Language Model(MLM):在训练时,BERT 随机遮掩输入中的一些单词,并通过上下文预测这些被遮掩的单词。这样,BERT 学会了通过上下文来理解词语的意义。

举例:假设输入句子是 “I love to play football”,BERT 可能将其中的 “play” 遮掩掉,变成 “I love to [MASK] football”。然后,BERT 的任务是预测出 [MASK] 的词是 “play”。 -

Next Sentence Prediction(NSP):BERT 还需要学习句子之间的关系。模型会输入一对句子,预测第二个句子是否是第一个句子的下文。这个任务有助于模型理解句子之间的逻辑关系和上下文。

举例:假设输入句子对是: -

句子A:“I love to play football.”

-

句子B:“It is a great sport.”

BERT 需要判断句子B是否是句子A的下文。如果是,它输出 “Is Next”;如果不是,它输出 “Not Next”。

BERT 模型的优势在于它通过上下文的双向理解,能够捕捉到词与词之间更丰富的语义关系。它的预训练模型可以在多种下游任务中进行微调,使得 BERT 在各类 NLP 任务(如问答系统、命名实体识别、情感分析等)中表现得非常出色。

与 Word2vec 不同,BERT 是基于 Transformer 的编码器架构,能够处理更复杂的上下文关系。BERT 预训练后可以通过微调(fine-tuning)应用到具体任务中,这使得它在特定任务上的表现优于静态的词嵌入模型。

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)