【视频异常检测】Cross-Modal Fusion and Attention Mechanism for Weakly Supervised Video Anomaly Detection

近年来,弱监督视频异常检测(WS-VAD)成为仅使用视频级标签识别视频中暴力、裸露等异常事件的当代研究方向。然而,这项任务面临着巨大的挑战,包括处理不平衡的模态信息和一致地区分正常和异常特征。在本文中,我们针对这些挑战,提出了一个多模态WS-VAD框架来准确检测暴力和裸露等异常。在提出的框架内,我们引入了一种新的融合机制,称为跨模态融合适配器(CFA),它能够动态选择并增强与视觉模态高度相关的视听

摘要

近年来,弱监督视频异常检测(WS-VAD)成为仅使用视频级标签识别视频中暴力、裸露等异常事件的当代研究方向。然而,这项任务面临着巨大的挑战,包括处理不平衡的模态信息和一致地区分正常和异常特征。在本文中,我们针对这些挑战,提出了一个多模态WS-VAD框架来准确检测暴力和裸露等异常。在提出的框架内,我们引入了一种新的融合机制,称为跨模态融合适配器(CFA),它能够动态选择并增强与视觉模态高度相关的视听特征。此外,我们引入了双曲洛伦兹图注意力机制(Hyperbolic Lorentzian Graph Attention, HLGAtt)来有效捕获正常和异常表示之间的层次关系,从而提高了特征分离的准确性。通过大量的实验,我们证明了所提出的模型在暴力和裸体检测的基准数据集上取得了最先进的结果。

1、引言

在现代科技时代,孩子们越来越多地使用在线平台学习、娱乐和与他人联系。然而,这种便利的访问方式也让人担心他们会接触到有害和不合适的内容,尤其是暴力和裸露的内容。对儿童情感健康和心理发展的潜在不利影响强调了实施强有力的机制来发现暴力和裸露的重要性。检测视频中的这种异常是一个众所周知的计算机视觉问题,它在其他现实世界的应用中也很有用,例如监视系统、犯罪预防和内容审核。在视频中获取帧级异常的注释是昂贵且耗时的。因此,WS-VAD已成为一个突出的研究领域。WS-VAD专注于学习异常事件,如暴力和裸露,仅基于视频级二元标签。在这种方法中,如果没有检测到异常事件,则将视频归类为正常。相反,如果存在任何形式的异常事件,如暴力或裸体,则将其归类为异常。WSVAD方法通常采用多实例学习(Multiple Instance Learning, MIL)[17]进行模型训练。在这里,一个正常的视频被视为一个没有异常片段的负袋,而一个异常视频被视为一个或多个异常片段的正袋。通过优化MIL损失来训练异常评价函数,确保正袋比负(正常)袋具有更高的异常值。

继MIL之后,最近又提出了几种基于单模态(即基于视频的方法[10,13,28 - 30,34,35])和多模态[1,19,21,36 - 38,40]的WS-VAD方法。与基于单模态的方法相比,多模态方法显示出了令人鼓舞的结果,这些方法通过利用来自不同模态的互补信息来共同学习音频和视觉表示以提高性能。尽管多模态方法表现出了良好的性能,但它们面临着两个主要挑战:1)结合视听特征时的模态信息不平衡;2)在正常和异常特征之间区分不一致。最近,Peng等人发现,模态不平衡的问题主要是由于来自真实场景的音频信号中的噪声。为了解决这个问题,他们建议听觉信息对异常检测的贡献小于视觉线索,从而降低音频特征的优先级。但是,当音频数据与视觉数据一样重要时,必须纠正这种方法。为了解决另一个问题,即正常和异常特征之间不一致的区分,先前的研究利用了图表示学习,其中每个实例被视为图中的一个节点。然而,这些方法仍然难以准确区分它们。

在本研究中,我们提出了一个新的框架来应对这些挑战。为了解决模态信息不平衡的问题,我们引入了一种新颖的融合模块CFA。它通过优先考虑音频特征相对于视觉模态的重要性来动态调整每种模态的影响。这种选择性过程确保只使用对视觉学习至关重要的相关音频特征。通过适应性地选择相对于视觉模态最合适的特征,我们的方法通过整合相关的音频特征来增强视觉特征的学习。此外,我们引入了一种基于双曲图卷积网络的HLGAtt机制,以保持正常和异常特征之间的一致区分。该机制在双曲空间中运行,通过空间和时间特征学习来捕获正常和异常表示之间的层次关系,这有助于区分正常和异常特征。

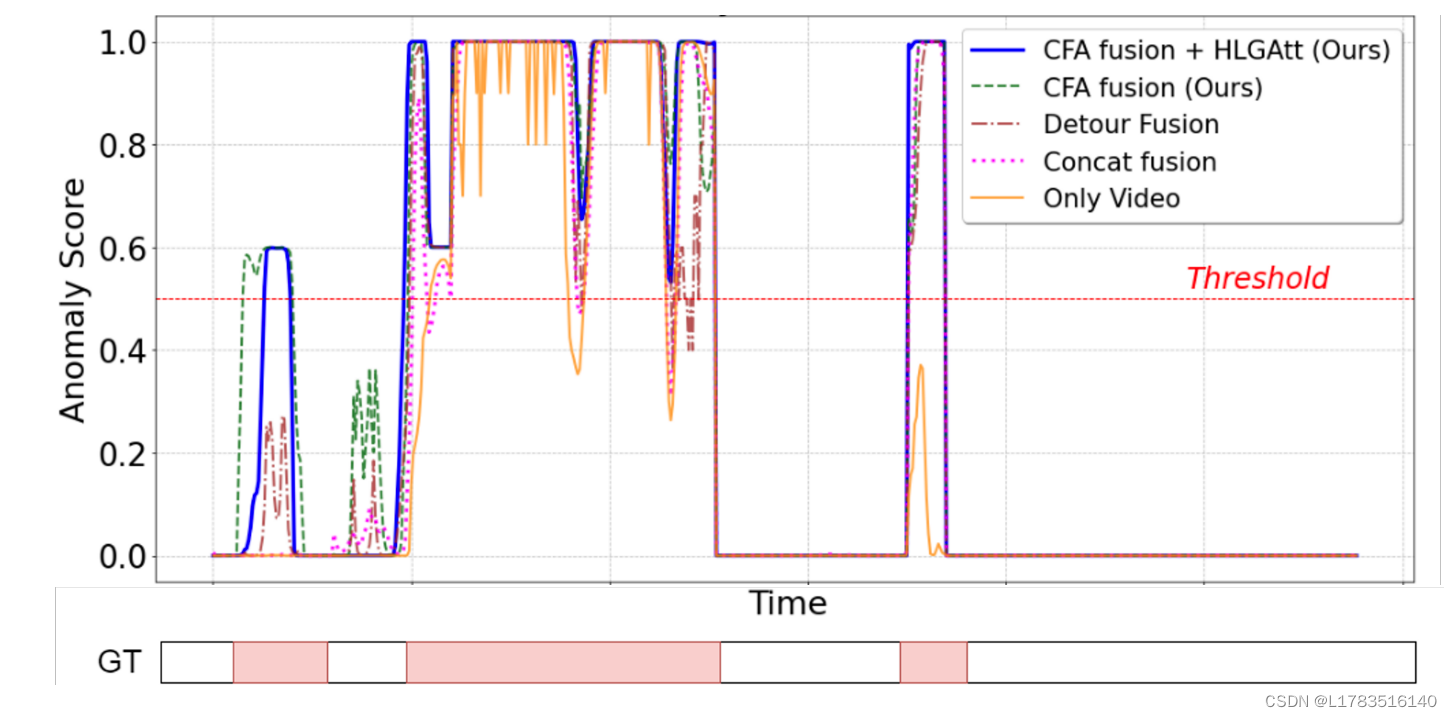

所提出的模型准确地识别异常事件,并优于现有的最先进的(SOTA)方法,用于暴力和裸体检测任务。图1显示了从XD-Violence数据集的几个暴力和正常实例中获得的异常评分分析,并将其与各种方法(如仅基于视频的方法[36],Concate融合[36],Detour融合[21]方法)进行了比较。图1显示,与其他模型相比,所提出的模型准确地识别了异常。我们总结本文的贡献如下:

- 我们提出了一种新的WS-VAD框架,以解决视听模态信息的不平衡问题,有效区分异常特征和正常特征,从而准确检测到暴力、裸露等异常事件。

- 为了解决模态信息不平衡的问题,我们引入了一个新的融合模块CFA,该模块通过动态调节每个模态的贡献来帮助所提出的框架有效地促进多模态交互。

- 我们引入了一种新的注意力机制HLGAtt来捕捉正常和异常表征之间的层次关系,从而增强了特征分离。

相关工作

1、Violence Detection Works

此前,很少有基于无监督学习的方法[14,25]被提出用于暴力检测。这些方法专注于单类分类,通过学习什么是正常的,并通过识别偏离规范来发现异常。然而,这些方法并不适合复杂的环境,并且由于训练过程中异常视频数据的可用性有限而经常受到挑战。

最近,WS-VAD方法[13,28,36,37,40]利用视频级标签被引入,并取得了比无监督VAD方法更有希望的结果。为了提高暴力事件的检测精度,已经提出了几种基于视频的WS-VAD方法[10,13,28 - 30,34,35]。然而,这些方法忽略了音频信息和跨模态的相互作用,限制了暴力预测的有效性。为了解决这个问题,Wu等人([36])引入了一个名为XD-Violence的大规模视听数据集,并建立了视听活动基线。在此之后,许多多模态方法[1,19,21,36 - 38,40]被提出,优于基于视频的WS-VAD方法。最近,Peng等人提出了一种视听数据的融合机制,并引入了一种基于双曲图卷积网络的模型,通过学习双曲空间中的嵌入来有效地捕获语义区别。最近,Zhou等人提出了一种具有不确定性调节的双存储单元模块,强调异常和正常数据的学习表征。Salem等人于2010年推出了一种新版本的MIL,通过使用margin损失来避免排名损失的缺点。

尽管这些方法呈现出令人满意的结果,但它们的有效性受到模态信息不平衡的影响。此外,它们在持续区分正常和异常特征方面存在困难,限制了检测的准确性。本文解决了这些问题,并提出了一个新的多模态框架,可以更准确地检测暴力事件。与最近的多模态方法相比[21,38,40],我们提出了一种新的带有调制机制的跨模态融合,以自适应地学习和融合音频模态与相关视觉特征。在此基础上,我们引入了基于洛伦兹注意力的双曲图机制来学习正常和异常特征之间的层次关系,并有效地进行区分。

2、Nudity Detection Works

在基于视频的裸体检测中,研究人员设计了各种方法来处理识别露骨内容的任务。一种常见的策略是检测视频帧中的肤色[5,9,12,22]。Samal等人提出了一种模型,该模型将注意力池与基于Swin transformer的YOLOv3架构相结合,用于图像和视频中的淫秽内容检测。Jin等人[8]采用弱监督的多实例学习方法,以最小的注释生成适当大小的区域,以解决基于局部区域的私密部位检测问题。Wang等人[15]将注意力机制与深度网络结合在一起,证明了其在性能增强方面的有效性。一些研究提出了联合考虑局部和全局背景的深度学习架构[18,33]。Utsav等人提出了一种基于域自适应的流媒体视频成人内容过滤方法。Tran等人提出了一种额外的基于训练的伪标签方法,使用Mask RCNN进行性对象检测。

然而,上述方法侧重于基于图像的方法或利用单模态方法;以视听为基础的方法尚未得到广泛探索。本文试图通过使用视听数据来解决这一差距,旨在提高视频中裸体检测的准确性。

方法

1、问题陈述

给定一组NNN个视频,X={Xi}i=1NX=\{X_{i}\}_{i=1}^{N}X={Xi}i=1N,对应的真视频级标签Y={Yi}i=1N∈{1,0}Y=\{Y_{i}\}_{i=1}^{N}\in\{1,0\}Y={Yi}i=1N∈{1,0},其中Yi=1Y_{i}=1Yi=1表示视频中存在异常事件,Yi=0Y_{i}=0Yi=0表示不存在异常事件,我们的目标是以弱监督的方式准确检测视频中的暴力和裸露等异常事件。具体来说,每个视频XiX_{i}Xi最初被分成基于16帧的TTT个不重叠的多模态片段(M={MiV,MiA}i=1T)(M=\{M_{i}^{V},M_{i}^{A}\}_{i=1}^{T})(M={MiV,MiA}i=1T),通过预训练的CNN网络对这些片段进行处理,提取相应的视觉特征FV∈RT×DVF_{V}\in\mathbb{R}^{T\times D_{V}}FV∈RT×DV和音频特征FA∈RT×DAF_A\in\mathbb{R}^{T\times D_A}FA∈RT×DA,其中DVD_VDV和DAD_ADA分别表示视频和音频模态的特征维数。其中MiVM_{i}^{V}MiV和MiAM_{i}^{A}MiA分别表示视频段和音频段。然后将这些提取的视频和音频特征转发到所提出的框架中,该框架识别输入视频是否包含任何异常事件。

为了准确识别异常事件,我们提出了一个新的框架,如图2所示,其中我们引入了新的跨模态融合模块和双曲洛伦兹图注意机制。这些模块的细节将在后面的小节中讨论。

2、Cross-modal Fusion Adapter (CFA)

CFA模块由prefix-tuned-based bottleneck attention和调制机制组成。The prefix-tuned-based bottleneck attention有助于有效地在视听模态之间进行多模态交互。调制机制考虑到音频特征对视觉模态的重要性,动态调节融合过程中各模态的贡献。

Prefix-Tuning bottleneck attention mechanism

该机制通过prefix-tuned操作,将学习到的表示与初始化的参数相结合,将先验知识融入到特征转换过程中。为此,该过程涉及将从音频特征FAF_{A}FA获得的键KKK和值VVV与prefixes PkP_{k}Pk和PvP_{v}Pv拼接起来,分别产生prefix-tuned的键KpK_{p}Kp和值VpV_{p}Vp。参数PkP_{k}Pk和PvP_{v}Pv初始化为维度为RB×DA×Dp\mathbb{R}^{B\times D_{A}\times D_{p}}RB×DA×Dp的零矩阵,其中B、DA和DpB、D_{A}和D_{p}B、DA和Dp分别表示批处理大小、音频特征维度和prefix维度。

这些prefix-tuned的键KpK_{p}Kp和值VpV_{p}Vp以及查询QQQ(即视觉特征FVF_{V}FV),然后被传递给跨模态多头部注意模块[23]。该模块使音频和视觉模态的prefix-tuned特征之间的交互成为可能,使它们能够有选择地和情境地关注每种模态的相关信息。在这个过程中,注意力分数是基于查询、前缀调优键和值计算的。跨模态多头注意模块函数(fCMAf_{CMA}fCMA)的数学表达式为

式中,DKPD_{K_{P}}DKP表示键向量KpK_{p}Kp的维数。注意力特征FAttF_{Att}FAtt随后被传递到bottleneck适配器模块。在此阶段,bottleneck适配器确保模式之间的平滑交互,同时保留特定于模式的特征。它包括向下缩放的全连接层(即fdownf_{down}fdown),然后是高斯误差线性单元(GELU)激活(即fGELUf_{GELU}fGELU)和向上缩放的全连接层(即fupf_{up}fup)。这可以在数学上表示为

这里,GELU激活函数引入非线性,允许复杂的特征转换。这种精心的设计确保适配器模块有效地调整输入特征以共享bottleneck表示,从而促进上下文感知融合。

Modulation Mechanism

在提出的CFA模块中,我们引入调制因子,通过考虑其音频特征相对于视觉模态的重要性来动态调整各个模态的影响。这种机制是由一个可学习的调制函数来促进的,该函数对音频特征FAF_AFA进行操作,以选择对视觉模态重要的相关音频特征。得到的调制特征FModF_{Mod}FMod被定义为

其中,σ表示sigmoid激活,WmodW_{mod}Wmod表示与调制函数相关的权重。sigmoid激活函数确保调制因子的范围在0到1之间,从而调节应用于融合表示的调制程度。

接下来,使用融合和细化过程,首先将调制特征与prefix-tuning bottleneck attention的输出融合,然后通过全连接层对融合表示进行细化。这个操作可以在数学上表示为

调制机制fMF()f_{MF}()fMF()根据音频特征对视觉模态的重要性来修改前缀调优瓶颈注意力的输出。通过融合和细化过程,最终的融合表示被精心制作,以从两种模态中捕获最相关的信息,同时减少噪声并保留模态特定的特征。

3、Hyperbolic Lorentzian Graph Attention (HLGAtt) Mechanism

在提出的框架中,我们引入了一个基于新的注意机制HLGAtt的双曲图卷积网络。提出的HLGAtt使用双曲洛伦兹图注意机制,该机制学习分层曲率参数来捕获输入图的层次结构,从而与现有的基于图的[21,36]或基于transformer的[40]方法相比,增强了正常和异常表示之间的层次关系。它由双曲空间转换操作、并行节点上的洛伦兹线性变换和增强模块处理以及融合操作组成。

首先,我们使用指数函数将融合的视听特征FFusedF_{Fused}FFused转换到双曲空间。由此得到转换后的融合特征图FH∈RT×2DHF_{H}\in\mathbb{R}^{T\times2D_{H}}FH∈RT×2DH,其中TTT为片段数,DHD_HDH为双曲维数。

最近,Zhang等人提出了一种双曲图注意机制,该机制利用并行分支过程来学习各自分支中的不同特征和模式来完成预测任务。受此[39]的启发,我们在两个并行分支(即节点A和节点B)上处理转换后的双曲特征映射,以从输入特征图中学习特定的模式。分离分支确保具有相似特征的特征被引导到各自的节点。这允许每个分支学习正常和异常特征的独特属性,从而更精确地区分它们。

转换后的双曲特征图在每个节点上经过洛伦兹线性变换增强模块。本文采用洛伦兹线性变换[4,21]进行特征变换,并利用提出的增强机制对变换后的时空特征进行进一步增强。在Lorentzian线性变换中,我们首先建立邻接矩阵A∈RT×TA\in\mathbb{R}^{T\times T}A∈RT×T来捕获双曲特征相似度。这里,每个条目AijA_{ij}Aij可以计算为

其中,fsimf_{sim}fsim表示双曲特征相似性度量,它基于片段iii和jjj的洛伦兹内有的距离dLd_LdL来评估它们之间的相似程度。使用指数函数和Softmax函数保持非负性,并将AAA的值限制在[0,1]范围内。

接下来,我们引入双曲洛伦兹线性(即fHL()f_{HL}()fHL()),然后进行邻域双曲聚合操作[24]进行特征变换。第lll层的第iii段的这些变换后的双曲特征(即zilz_i^{l}zil)可以表示为

式中,η为负曲率常数。

为了进一步增强这些转换后的特征,我们对它们进行了基于时空信息的处理。输入向量z[0]z[0]z[0]的初始分量表示双曲空间[4]中的时间方面。该分量通过一个sigmoid激活函数进行处理,然后进行指数缩放和移位操作。通过这个过程,计算节点A和节点B的时间特征(即TnodeAT_{nodeA}TnodeA和TnodeBT_{nodeB}TnodeB)为

式中,γ\gammaγ为可训练参数。输入向量zzz的剩余元素可以认为是节点A和节点B(即SnodeAS_{nodeA}SnodeA和SnodeBS_{nodeB}SnodeB)的空间特征[4]。在数学上,它们可以表示为

这些特征将复杂的空间特征封装在双曲空间中,这对于捕获图中的层次结构和关系至关重要。

为了确保空间组件与双曲模型的对齐,需要计算缩放因子Υ\UpsilonΥ。这个因素考虑了每个节点的时间和空间复杂性。它确保空间组件被适当地缩放以适应双曲空间。

将时间和缩放后的空间分量连接起来,得到增强的特征向量(即:F^HnodeA\hat{F}_{H}^{nodeA}F^HnodeA和F^HnodeB\hat{F}_{H}^{nodeB}F^HnodeB)。数学上,这个过程可以表示为

节点A分支中的增强特征映射通过Leaky-ReLU激活和softmax归一化操作来引入非线性并确保增强特征映射的标准化。这确保了在每个节点学习到表示正常和异常数据的不同模式。通过这样做,鼓励模型从其他节点(即节点B)处理的特征集中学习不同的特征集。最后,通过矩阵乘法处理节点A和节点B的增强特征映射以计算注意力,然后通过ReLU激活生成输出特征映射。提议的HLGAtt模块的结果可以表述为

4、Hyperbolic Classifier & Learning Objective

在[21]之后,我们还使用双曲分类器,它将HLGAtt模块的输出作为输入,并预测正常和异常事件的置信度得分。最终得分得分可以表示为

为了端到端训练所提出的模型,我们采用了[20,21,28,36]中采用的基于MIL的学习目标,该目标计算视频中前k−max预测分数的平均值。高分正预测表明异常事件的存在,而k-max负分数通常代表硬样本。这个学习目标函数可以表示为

其中,Score‾\overline{Score}Score表示视频中k−max分数的平均值,YiY_iYi表示二元视频级别标签。

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)