一文搞懂:数据湖、数据市集、数据仓库

可靠性是指数据是否稳定可靠。•工作原理:理解数据管道的工作原理,即如何将数据从源头移动到目标位置,并在移动过程中进行必要的处理,如数据清洗、转换、聚合等。例如,每天晚上从企业的生产系统、销售系统等抽取当天的数据,经过ETL处理后加载到数据仓库,为第二天的业务分析提供最新的数据。例如,通过设置监控指标,如数据延迟、处理错误率等,及时发现和解决数据管道中的问题,确保数据的正常流动。例如,将企业内部的E

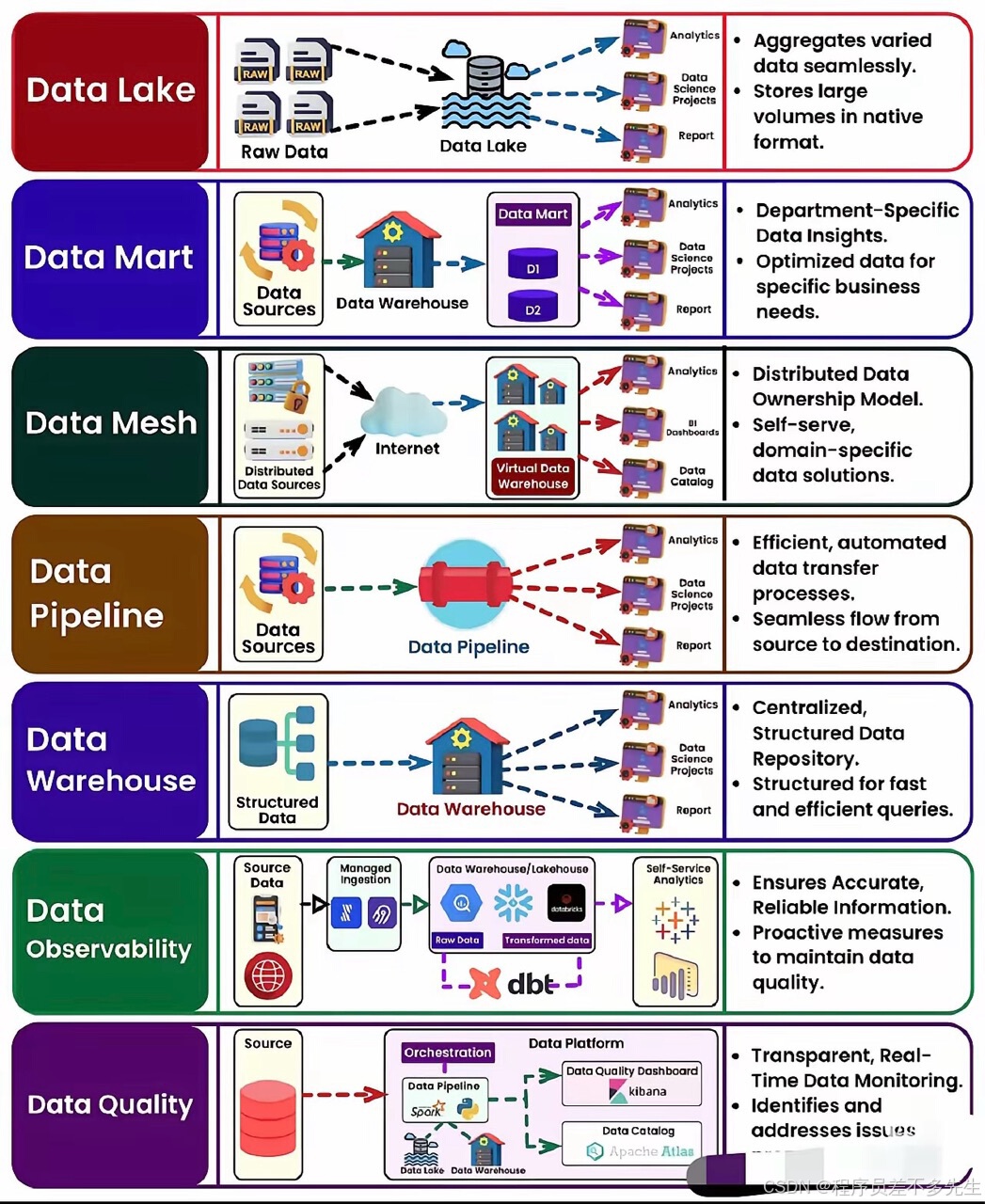

以下是对这7个数据知识的详细解释以及如何学习和运用它们:

一、数据湖(Data Lake)

• 学习要点:

• 理解概念:数据湖是一个存储原始、非结构化数据的庞大库。它能够存储来自各种来源的数据,如日志文件、社交媒体数据、传感器数据等,这些数据在存储时不需要预先进行结构化处理。

• 存储技术:了解常见的数据湖存储技术,如Amazon S3、Hadoop HDFS等。例如,Amazon S3提供了高可用性、高持久性和可扩展的存储服务,适合构建数据湖,能够存储海量的数据对象。

• 数据治理:学习数据湖中的数据治理方法,包括数据分类、访问控制、数据生命周期管理等。因为数据湖中的数据量大且复杂,需要有效的治理策略来确保数据的安全和合规使用。

• 应用实践:

• 数据收集:使用数据采集工具,如Apache NiFi,将不同来源的数据导入数据湖。例如,从企业内部的业务系统收集日志数据,从外部的社交媒体平台收集用户评论数据。

• 数据探索:利用数据分析工具,如Apache Spark,对数据湖中的数据进行探索性分析。通过编写Spark SQL查询,可以快速了解数据的基本特征和分布情况,为后续的数据处理和分析提供依据。

二、数据集市(Data Mart)

• 学习要点:

• 与数据仓库的关系:明确数据集市是数据仓库的一个定制子集。数据仓库通常存储企业级的、全面的结构化数据,而数据集市则专注于特定领域,如销售数据集市、财务数据集市等,为特定部门或业务团队提供服务。

• 数据建模:掌握数据集市的数据建模方法,如星型模型或雪花模型。星型模型以事实表为中心,周围围绕着多个维度表,这种模型结构简单,查询效率高,适合数据集市的快速分析需求。

• 性能优化:了解如何对数据集市进行性能优化,包括索引创建、查询优化等。例如,在数据集市的数据库中,为常用的查询字段创建索引,可以加快查询速度,提高数据访问的效率。

• 应用实践:

• 数据抽取与转换:从数据仓库中抽取与特定领域相关的数据,并进行必要的转换和清洗,加载到数据集市中。例如,从企业数据仓库中抽取销售订单数据,去除无效记录,转换数据格式,然后加载到销售数据集市。

• 报表生成:利用数据集市中的数据,为业务团队生成各种报表。例如,为销售部门生成月度销售报表,包括销售额、销售量、客户分布等信息,帮助他们了解业务状况,制定销售策略。

三、数据网(Data Mesh)

• 学习要点:

• 架构特点:理解数据网作为一种分散式数据架构的核心特点,即赋予团队对其数据的所有权和控制权。与传统的集中式数据管理不同,数据网强调数据的去中心化,各个业务团队负责自己数据的生产、管理和维护。

• 数据治理框架:学习数据网中的数据治理框架,如如何定义数据标准、数据质量规则等。在分散的数据环境中,统一的数据治理框架能够确保数据的一致性和可靠性,避免数据孤岛和数据混乱。

• 技术实现:了解实现数据网所需的技术,如微服务架构、事件驱动架构等。微服务架构可以将数据处理和管理功能分解为多个独立的服务,每个服务负责特定的数据任务,提高系统的灵活性和可扩展性。

• 应用实践:

• 团队协作:在企业内部推动数据网的实施,需要建立跨部门的团队协作机制。例如,成立一个数据治理委员会,由各个业务部门的数据负责人组成,共同制定数据网的策略和规则。

• 数据共享与集成:通过数据网实现不同团队之间的数据共享和集成。例如,市场部门和销售部门可以通过数据网共享客户数据,市场部门可以利用销售数据进行精准营销,销售部门也可以参考市场数据调整销售策略。

四、数据管道(Data Pipeline)

• 学习要点:

• 工作原理:理解数据管道的工作原理,即如何将数据从源头移动到目标位置,并在移动过程中进行必要的处理,如数据清洗、转换、聚合等。数据管道可以是批处理的,也可以是流处理的,根据数据的实时性和处理需求选择合适的管道类型。

• 工具与技术:熟悉常见的数据管道工具和技术,如Apache Kafka(用于流数据处理)、Apache Airflow(用于批处理工作流管理)等。Apache Kafka可以高效地处理高吞吐量的实时数据流,而Apache Airflow可以灵活地定义和调度复杂的批处理任务。

• 监控与维护:学习如何对数据管道进行监控和维护,包括监控数据的传输状态、处理性能等。例如,通过设置监控指标,如数据延迟、处理错误率等,及时发现和解决数据管道中的问题,确保数据的正常流动。

• 应用实践:

• 数据集成:构建数据管道,将不同来源的数据集成到数据仓库或数据湖中。例如,将企业内部的ERP系统数据、CRM系统数据以及外部的市场数据通过数据管道进行整合,为数据分析提供全面的数据基础。

• 实时数据处理:利用数据管道实现实时数据处理应用。例如,在金融领域,通过数据管道实时监控交易数据,及时发现异常交易行为,进行风险预警。

五、数据仓库(Data Warehouse)

• 学习要点:

• 架构设计:掌握数据仓库的架构设计方法,包括数据的分层存储、ETL(Extract, Transform, Load)流程设计等。通常数据仓库采用分层架构,如ODS(操作数据存储)、DW(数据仓库)、DM(数据集市)等层次,通过ETL工具将数据从源头抽取、转换后加载到相应的层次中。

• 数据模型设计:深入学习数据仓库的数据模型设计,如星型模型、雪花模型等。星型模型适用于多维数据分析,通过事实表和维度表的关联,可以快速地进行数据聚合和查询;雪花模型则在星型模型的基础上进一步规范化维度表,减少数据冗余。

• 性能优化:了解数据仓库的性能优化技巧,如索引优化、分区策略、查询优化等。例如,对数据仓库中的关键表创建合适的索引,可以加快查询速度;通过分区策略,将数据按照时间、地区等维度进行分区,提高数据的管理和查询效率。

• 应用实践:

• 数据加载与更新:根据业务需求,定期从各个业务系统加载数据到数据仓库,并进行数据更新。例如,每天晚上从企业的生产系统、销售系统等抽取当天的数据,经过ETL处理后加载到数据仓库,为第二天的业务分析提供最新的数据。

• 数据分析与报告:利用数据仓库中的数据,进行各种数据分析和报告生成。例如,通过数据挖掘算法分析客户购买行为,为企业制定营销策略提供依据;生成财务报表,帮助企业了解财务状况,进行决策支持。

六、数据质量(Data Quality)

• 学习要点:

• 质量维度:理解数据质量的多个维度,包括准确性、一致性、完整性、及时性、可靠性等。准确性是指数据是否真实反映了客观事物;一致性是指数据在不同系统、不同时间点是否保持一致;完整性是指数据是否缺失;及时性是指数据是否能够及时更新;可靠性是指数据是否稳定可靠。

• 评估方法:掌握数据质量的评估方法,如数据质量评估指标体系的建立、数据质量评估工具的使用等。可以使用专业的数据质量评估工具,如Informatica Data Quality,对数据进行自动评估,生成数据质量报告。

• 提升策略:学习数据质量提升策略,如数据清洗、数据校验、数据监控等。数据清洗可以去除数据中的错误、重复和不一致的部分;数据校验可以在数据输入或加载时进行,确保数据符合预定义的规则;数据监控可以实时监控数据质量的变化,及时发现问题并进行处理。

• 应用实践:

• 数据清洗与校验:在数据加载到数据仓库或数据湖之前,进行数据清洗和校验。例如,对客户数据进行清洗,去除重复的客户记录,校验客户信息的格式和完整性,如电话号码、邮箱地址等是否符合规范。

• 数据质量监控:建立数据质量监控机制,对数据的准确性、一致性等进行实时监控。例如,通过设置数据质量监控指标,如数据错误率、数据更新及时性等,当指标超出阈值时,及时发出警报,通知相关人员进行处理。

七、数据可用性(Data Availability)

• 学习要点:

• 系统健康监测:了解如何监测数据系统的健康状况,包括硬件设备的运行状态、软件系统的性能指标等。可以使用系统监控工具,如Zabbix、Prometheus等,对数据系统的服务器、存储设备、网络设备等进行实时监控,收集性能数据,如CPU利用率、内存使用率、磁盘I/O等。

• 可靠性保障。

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)