LightLLM:轻量级、高性能的语言模型推理框架

LightLLM:轻量级、高性能的语言模型推理框架项目地址:https://gitcode.com/gh_mirrors/li/lightllm在人工智能领域,大型语言模型(LLM)的应用日益广泛,但高效的推理和部署一直是技术挑战。今天,我们向您推荐一款卓越的开源项目——LightLLM,它以其轻量级设计、易扩展性和高速性能,成为语言模型推理领域的佼佼者。项目介绍LightLLM 是一个基...

LightLLM:轻量级、高性能的语言模型推理框架

在人工智能领域,大型语言模型(LLM)的应用日益广泛,但高效的推理和部署一直是技术挑战。今天,我们向您推荐一款卓越的开源项目——LightLLM,它以其轻量级设计、易扩展性和高速性能,成为语言模型推理领域的佼佼者。

项目介绍

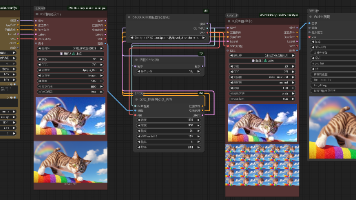

LightLLM 是一个基于 Python 的 LLM 推理和部署框架,它集成了多种优秀的开源实现,如 FasterTransformer、TGI、vLLM 和 FlashAttention,确保了其高性能和灵活性。该项目通过三进程异步协作、Nopad 注意力操作、动态批处理调度等创新技术,显著提升了 GPU 利用率和系统吞吐量。

项目技术分析

LightLLM 的核心技术亮点包括:

- 三进程异步协作:将 tokenization、模型推理和 detokenization 异步执行,大幅提高 GPU 利用率。

- Nopad 注意力操作:支持多模型的 nopad 注意力操作,有效处理长度差异大的请求。

- 动态批处理:实现请求的动态批处理调度,优化资源分配。

- FlashAttention:集成 FlashAttention 以加速推理并减少 GPU 内存占用。

- 张量并行:利用多 GPU 进行张量并行,加速推理过程。

- Token Attention:实现 token-wise 的 KV 缓存内存管理机制,确保推理过程中的零内存浪费。

- 高性能路由器:与 Token Attention 协同工作,精细管理每个 token 的 GPU 内存,优化系统吞吐量。

- Int8KV 缓存:增加 token 容量近两倍,仅支持 llama 模型。

项目及技术应用场景

LightLLM 支持多种流行的大型语言模型,如 BLOOM、LLaMA、StarCoder 等,适用于以下场景:

- 自然语言处理:文本生成、翻译、摘要等。

- 对话系统:聊天机器人、客服系统等。

- 内容创作:代码生成、创意写作等。

- 教育辅导:智能辅导系统、学习助手等。

项目特点

LightLLM 的主要特点包括:

- 轻量级设计:占用资源少,易于部署和扩展。

- 高性能:通过多种优化技术,实现高速推理。

- 易用性:提供 Docker 容器和详细的文档,简化使用流程。

- 广泛兼容性:支持多种模型和 GPU 架构,确保广泛的适用性。

结语

LightLLM 是一个强大且灵活的语言模型推理框架,无论您是研究人员、开发者还是企业用户,都能从中获得高效、便捷的体验。立即访问 GitHub 项目页面,了解更多信息并开始您的 AI 之旅!

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)