首发支持! 基于昇腾MindIE玩转InternVL3多模态理解最新模型

上海AI实验室开源了多模态大模型InternVL3.0,该模型在10亿-780亿参数规模下均取得开源模型性能第一,并在GUI智能体、图纸理解等专业场景表现出色。评测显示其性能接近闭源模型Gemini-2.5-Pro。模型已适配昇腾MindIE和MindSpeed平台,开发者可通过魔乐社区下载不同参数版本。文档详细说明了基于昇腾平台的部署流程,包括环境配置、容器创建及服务化推理方法,支持图像/视频理

2025年4月16日,上海人工智能实验室(上海AI实验室)升级并开源了通用多模态大模型书生·万象3.0(InternVL3)。通过采用创新的多模态预训练和后训练方法,InternVL3 多模态基础能力全面提升,在专家级基准测试、多模态性能全面测试中,10 亿~780 亿参数的全量级版本在开源模型中性能均位列第一,同时大幅提升了图形用户界面(GUI)智能体、建筑场景图纸理解、空间感知推理以及通识学科推理等方面的能力。

InternVL3系列一经发布开源,即在昇腾 MindIE 和 MindSpeed 中开箱即用。魔乐社区已上架该模型, 欢迎开发者下载体验!模型链接:

MindIE:

- 魔乐社区

https://modelers.cn/models/Models_Ecosystem/InternVL3-78B

https://modelers.cn/models/Models_Ecosystem/InternVL3-78B - 魔乐社区

https://modelers.cn/models/Models_Ecosystem/InternVL3-38B

https://modelers.cn/models/Models_Ecosystem/InternVL3-38B - 魔乐社区

https://modelers.cn/models/Models_Ecosystem/InternVL3-14B

https://modelers.cn/models/Models_Ecosystem/InternVL3-14B - 魔乐社区

https://modelers.cn/models/Models_Ecosystem/InternVL3-8B

https://modelers.cn/models/Models_Ecosystem/InternVL3-8B - 魔乐社区

https://modelers.cn/models/Models_Ecosystem/InternVL3-2B

https://modelers.cn/models/Models_Ecosystem/InternVL3-2B - 魔乐社区

https://modelers.cn/models/Models_Ecosystem/InternVL3-1B

https://modelers.cn/models/Models_Ecosystem/InternVL3-1B

MindSpeed:

01 模型介绍

基于司南OpenCompass 开源评测框架,研究团队对InternVL3 进行了全面系统的评估,包括多学科推理、文档理解、多图像 / 视频理解、现实世界理解、多模态幻觉检测、视觉定位、多语言能力以及以语言为中心的基准测试。评测结果显示,InternVL3 在开源多模态大模型中性能表现最优,创造了开源多模态大模型的性能新标杆,性能接近闭源模型 Gemini-2.5-Pro。

让我们快速体验一下。

图片理解体验:

Prompt:简单描述一下这张图片

效果:这张图片展示了一只大熊猫。它正坐在绿色的植物和竹子之间,看起来正在吃竹子。大熊猫有黑白相间的毛皮,背景中有木头和植物,营造出自然的栖息环境。

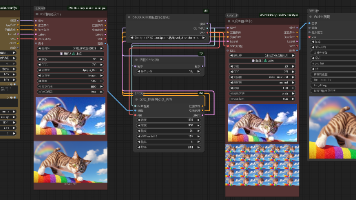

Prompt:描述一下这张梗图并解释其中的笑点。

效果:这张梗图的上半部分是一段文字,写着“最新消息 科学家发现”,下面是一张食物的图片,上面写着“吃饭能缓解饥饿”。这张图的笑点在于其讽刺和夸张的幽默。它用一种非常正式和严肃的新闻报道形式,宣布了一个极其显而易见和常识性的“发现”——吃饭能缓解饥饿。这种反差让人感到荒谬,从而产生幽默效果。它调侃了科学研究中有时会发布一些显而易见的结论。

视频理解体验:

给模型看一个视频并提问:

请描述这个视频

效果:

视频中展示了两只小熊猫(红熊猫)。一只小熊猫在树枝上,似乎在观察或与另一只小熊猫互动。另一只小熊猫站在地上,抬头看着树上的同伴。它们周围有竹梯和绿色的植物,环境看起来像是动物园或自然保护区。整个场景显得很自然和生动,两只小熊猫看起来非常可爱和有趣。

以下手把手带大家基于昇腾 MindIE 部署 InternVL3 模型。

02 准备环境

1. 加载镜像

需要使用mindie:2.0.T3及其后版本。

前往昇腾社区/开发资源或者魔乐社区/更多下载适配,下载镜像前需要申请权限,耐心等待权限申请通过后,根据指南下载对应镜像文件。

- 魔乐社区下载链接:魔乐社区

https://modelers.cn/images/MindIE/tags

https://modelers.cn/images/MindIE/tags - 昇腾社区下载链接:

https://www.hiascend.com/developer/ascendhub/detail/af85b724a7e5469ebd7ea13c3439d48f昇腾社区是基于昇腾系列处理器和基础软件构建的全栈 AI计算基础设施、行业应用及服务,包括昇腾系列处理器、系列硬件、CANN异构计算架构、AI计算框架、应用使能、开发工具链、管理运维工具、行业应用及服务等全产业链。 https://www.hiascend.com/developer/ascendhub/detail/af85b724a7e5469ebd7ea13c3439d48f完成之后,请使用docker images命令确认查找具体镜像名称与标签。

https://www.hiascend.com/developer/ascendhub/detail/af85b724a7e5469ebd7ea13c3439d48f完成之后,请使用docker images命令确认查找具体镜像名称与标签。

docker images

2. 新建容器

如果您使用的是 root 用户镜像(例如从 Ascend Hub 上取得),并且可以使用特权容器,请使用以下命令启动容器:

docker run -it -d --net=host --shm-size=1g \

--privileged \

--name <container-name> \

--device=/dev/davinci_manager \

--device=/dev/hisi_hdc \

--device=/dev/devmm_svm \

-v /usr/local/Ascend/driver:/usr/local/Ascend/driver:ro \

-v /usr/local/sbin:/usr/local/sbin:ro \

-v /path-to-weights:/path-to-weights:ro \

<IMAGE ID> bash

如果您希望使用自行构建的普通用户镜像,并且规避容器相关权限风险,可以使用以下命令指定用户与设备:

docker run -it -d --net=host --shm-size=1g \

--name <container-name> \

--device=/dev/davinci_manager \

--device=/dev/hisi_hdc \

--device=/dev/devmm_svm \

--device=/dev/davinci0 \

--device=/dev/davinci1 \

--device=/dev/davinci2 \

--device=/dev/davinci3 \

--device=/dev/davinci4 \

--device=/dev/davinci5 \

--device=/dev/davinci6 \

--device=/dev/davinci7 \

-v /usr/local/Ascend/driver:/usr/local/Ascend/driver:ro \

-v /usr/local/sbin:/usr/local/sbin:ro \

-v /path-to-weights:/path-to-weights:ro \

<IMAGE ID> bash

3. 进入容器:

docker exec -it ${容器名称} bash

4. 安装python依赖

cd /usr/local/Ascend/atb-models

pip install -r requirements/models/requirements_internvl.txt

03 执行推理

纯模型推理

运行脚本,可参考 run_pa.sh 同级目录下的 README.md。

bash /usr/local/Ascend/atb-models/examples/models/internvl/run_pa.sh --run --trust_remote_code ${权重路径} ${图片或视频所在文件夹路径}

服务化推理

1. 打开配置文件

vim /usr/local/Ascend/mindie/latest/mindie-service/conf/config.json

2. 更改配置文件

{

...

"ServerConfig" :

{

...

"port" : 1040, #自定义

"managementPort" : 1041, #自定义

"metricsPort" : 1042, #自定义

...

"httpsEnabled" : false,

...

},

"BackendConfig": {

...

"npuDeviceIds" : [[0,1,2,3,4,5,6,7]],

...

"ModelDeployConfig":

{

"maxSeqLen" : 50000,

"maxInputTokenLen" : 50000,

"truncation" : false,

"ModelConfig" : [

{

"modelInstanceType": "Standard",

"modelName" : "internvl",

"modelWeightPath" : "/model/InternVL3-1B",

"worldSize" : 8,

...

"npuMemSize" : 8, #kvcache分配,可自行调整,单位是GB,切勿设置为-1,需要给vit预留显存空间

...

"trustRemoteCode" : false #默认为false,若设为true,则信任本地代码,用户需自行承担风险

}

]

},

"ScheduleConfig" :

{

...

"maxPrefillTokens" : 50000,

"maxIterTimes": 4096,

...

}

}

}

3. 拉起服务化

cd /usr/local/Ascend/mindie/latest/mindie-service/bin ./mindieservice_daemon

4. 新建窗口测试(VLLM 接口)

curl 127.0.0.1:1040/generate -d '{

"prompt": [

{

"type": "image_url",

"image_url": ${图片路径}

},

{"type": "text", "text": "Explain the details in the image."}

],

"max_tokens": 512,

"stream": false,

"do_sample":true,

"repetition_penalty": 1.00,

"temperature": 0.01,

"top_p": 0.001,

"top_k": 1,

"model": "internvl"

}'

服务化推理的更多信息请参考MindIE Service用户指南:

产品简介-MindIE Service开发指南-MindIE1.0.0开发文档-昇腾社区

欢迎体验

欢迎大家下载体验InternVL3,也欢迎广大开发者在模型评论区留言交流!

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献57条内容

已为社区贡献57条内容

所有评论(0)