可控文生图:让 Stable Diffusion 活好又听话

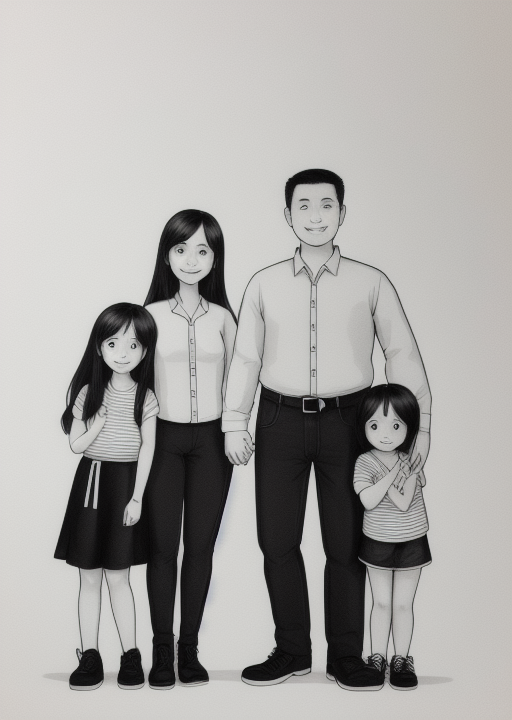

此图由 Stable Diffusion 模型生成我们知道核聚变的优点多多,但是由于发生的条件是超高温超高压以及能量产生得太快等因素,并不好利用,因此要寻求可控技术。Stable Diffusion 模型也类似,文生图的能力相当生猛,但是生成的结果往往并不是我们想要的。就像放烟花一样,只有等它绽放开了你才知道它长啥样。即便对于经验丰富的 Stable Diffusion 用户来说,高效地生成你想要

哈喽这里是海绵

前言

此图由 Stable Diffusion 模型生成

我们知道核聚变的优点多多,但是由于发生的条件是超高温超高压以及能量产生得太快等因素,并不好利用,因此要寻求可控技术。

Stable Diffusion 模型也类似,文生图的能力相当生猛,但是生成的结果往往并不是我们想要的。

就像放烟花一样,只有等它绽放开了你才知道它长啥样。

即便对于经验丰富的 Stable Diffusion 用户来说,高效地生成你想要的精确姿势也是非常困难的。

如果有个手段可以让 Stable Diffusion 变得可控,那它成为一种先进生产力的可能性就大大提高了。

ControlNet 正是提供了这种手段,能够从输入图像复制构图和人体姿势等。它功能强大且用途广泛,你可以将其与任何稳定扩散模型一起使用。

在这篇文章中,我们将介绍什么是 ControlNet,如何在 AUTOMATIC1111 中安装和使用 ControlNet。

所有的AI设计工具,安装包、模型和插件,都已经整理好了,👇获取~

1什么是 ControlNet?

ControlNet 是一种神经网络结构,目的是为了更好地引导模型生成图像,做到有的放矢。

它的原理是通过添加额外的条件来控制预先训练的扩散模型,使其能够利用输入图片或文字的特征来精确引导图像的生成。它将已有模型的权重复制到一个锁定副本和一个可训练副本。可训练副本学习额外条件,锁定副本则保留原有模型。

ControlNet 改进了 Stable Diffusion 模型的工作方式。它可以接受多种类型的输入,例如草图、边缘图像、语义分割图像、人体关键点特征、霍夫变换检测直线、深度图、法线图等。

Stable Diffusion 模型最基本的形式是文本到图像,即使用文本提示作为条件来引导图像生成。而 ControlNet 增加了其他形式的条件。

我们将通过查看两个 ControlNet 模型来阐明这一点:

(1) 边缘检测;

(2) 人体姿势检测。

¸边缘检测

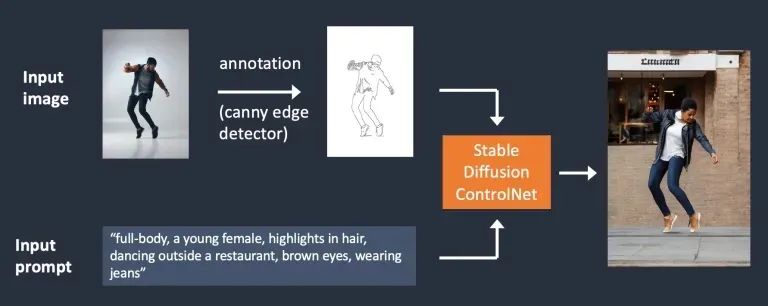

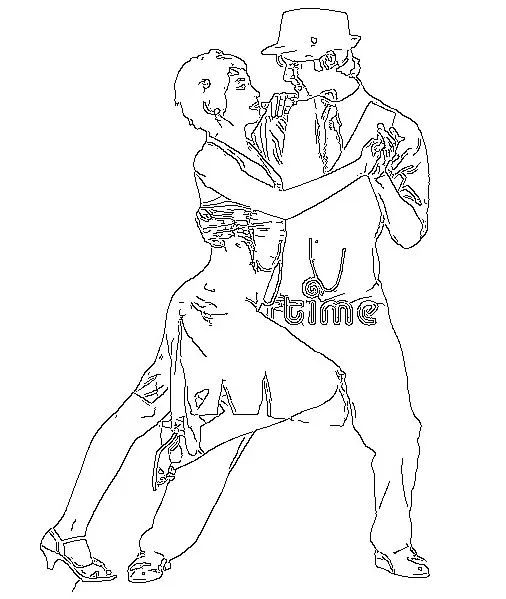

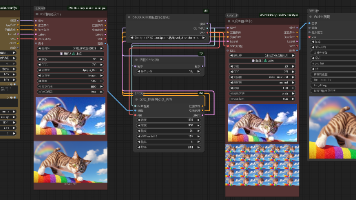

在下面所示的工作流程中,ControlNet 获取额外的输入图像并使用 Canny 边缘检测器检测其边缘。检测到的边缘被保存为控制图,然后作为文本提示之外的额外条件输入到 ControlNet 模型中。

具有 Canny 边缘调节的稳定扩散控制网络。

从输入图像中提取特定信息(在本例中为边缘)的过程称为注释(在研究文章中)或预处理(在 ControlNet 扩展中)。

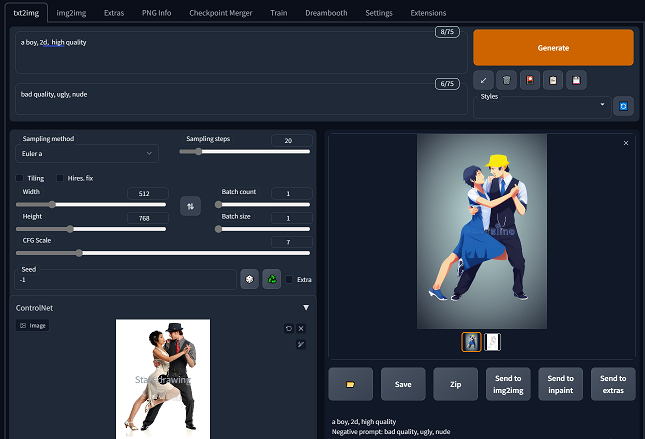

¸人体姿态检测

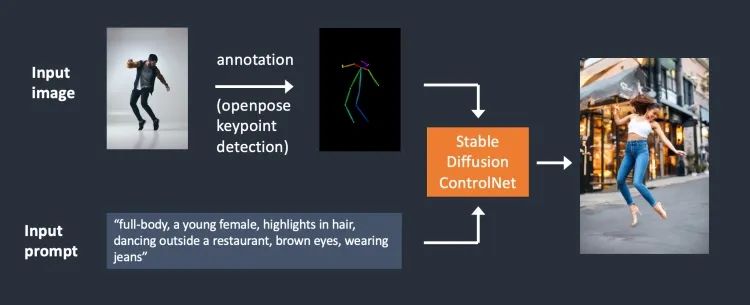

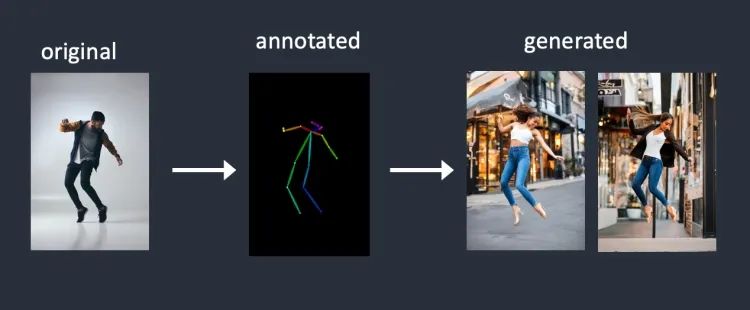

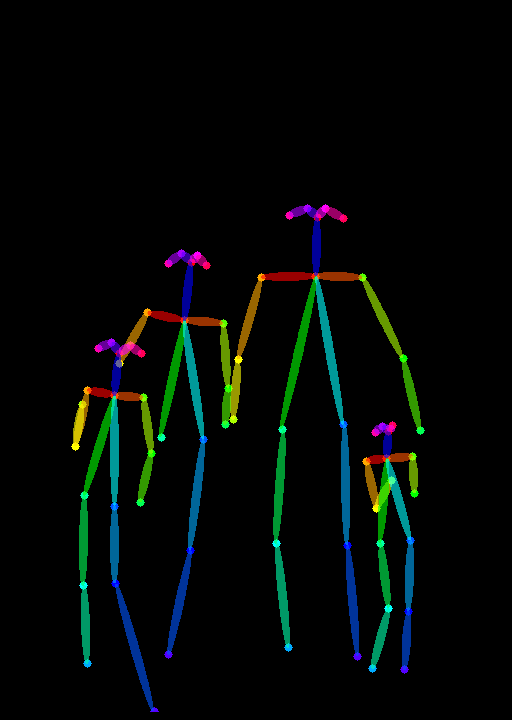

你可能已经猜到,边缘检测并不是预处理图像的唯一方法。Openpose[1] 是一种关键点快速检测模型,可以提取人体姿势,如手、腿和头部的位置,请参见下面的示例。

使用 OpenPose 的 ControlNet 工作流程如下所示。使用 OpenPose 从输入图像中提取关键点,并保存为控制图;然后将其馈送到 Stable Diffusion,并对文本提示进行额外调节;图像是根据这两个条件生成的。

使用 Canny 边缘检测和 Openpose 有什么区别?Canny 边缘检测器提取主体和背景的边缘,这往往更忠实于形状。你可以看到跳舞的男人变成了女人,但轮廓和发型都很相似。

OpenPose 仅检测关键点,因此图像生成可以更加自由,但仍遵循原始姿势。

在上面的示例中,它生成了一个左脚指向侧面的女人跳起来,这与原始图像和使用 Canny 边缘检测生成的图像不同。原因是 OpenPose 的关键点检测没有指定脚的方向。

2ControlNet 模型

在本节中,我将对 ControlNet 的各个模型作简要说明。

¸Canny边缘检测器

Canny 边缘检测器[2]是一种通用的老式边缘检测器,用于提取图像的轮廓。它对于保留原始图像的构图很有用。

¸OpenPose 检测器

OpenPose 检测器标注了人体关键点,例如头部、肩部、手部等的位置。它对于复制原始图像的人体姿势很有用,但对其他细节(例如服装、发型和背景)并没有帮助。

¸直线检测器

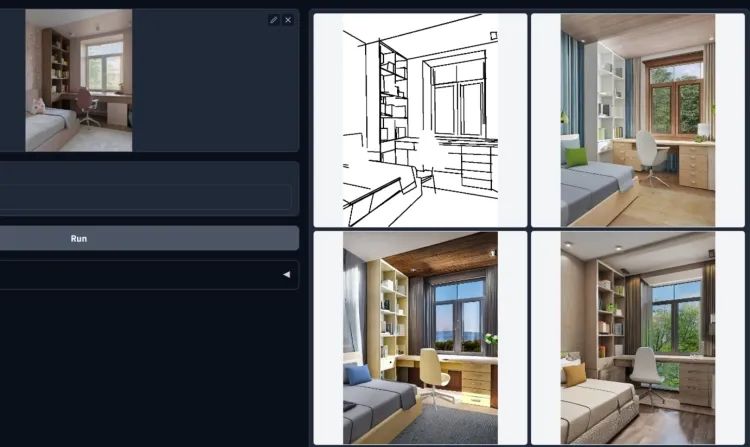

ControlNet 可与 M-LSD[3] (移动线段检测)一起使用,这是一种快速直线检测器。它对于提取具有直边的轮廓非常有用,例如室内设计、建筑物、街景、相框和纸张边缘。

¸HED 边缘检测器

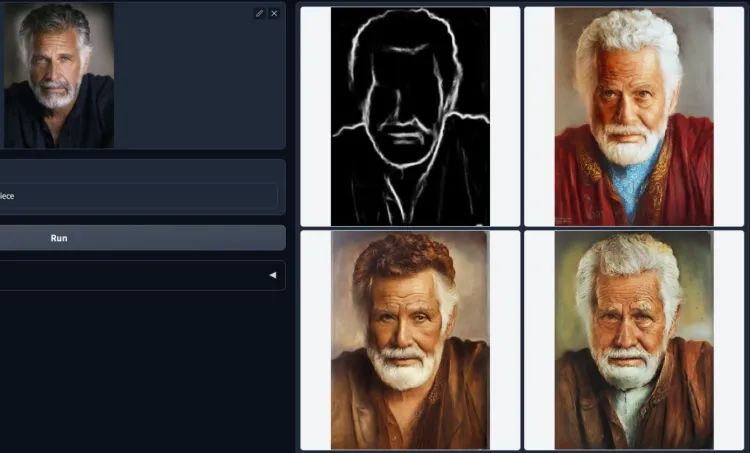

HED(整体嵌套边缘检测)[4]是一种边缘检测 AI 模型,擅长像人类一样从图像中生成轮廓。根据 ControlNet 的作者,HED 适用于重新着色和重新设计图像样式。

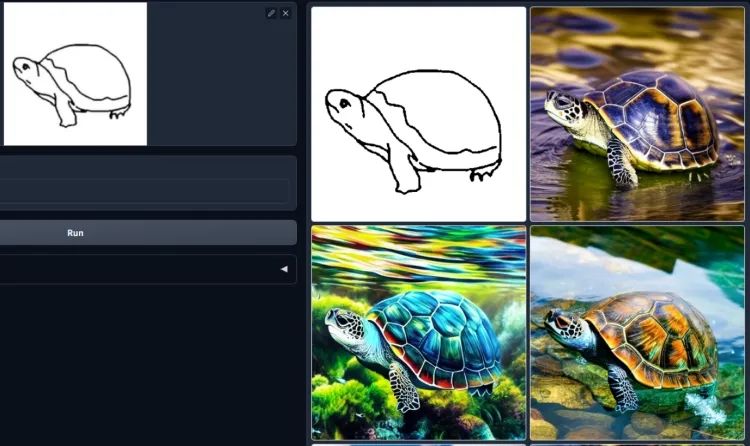

¸涂鸦草图

ControlNet 还可以将你涂鸦的草图变成图像!

¸其他模型

其他还有,

-

语义分割 — 根据从输入图像中提取的分割图生成图像。

-

深度图 — 类似于稳定扩散 v2 中的深度到图像,ControlNet 可以从输入图像推断深度图。ControlNet 的深度图比 SD v2 的分辨率更高。

-

法线图 — 用于指定对象表面的 3D 方向。这是在由多边形构成的低分辨率表面上伪造纹理的常用方法。当然,我们只有一个 2D 输入图像。法线贴图是从深度贴图计算出来的。

3安装 SD + ControlNet

我们将在 AUTOMATIC1111[5]中使用 ControlNet ,它是一种流行且功能齐全而且还免费的稳定扩散 GUI。我们将使用此扩展[6]来启用 ControlNet。

¸在 Colab 中安装 ControlNet

这种方式可以通过 Google的 notebook 文件轻松地使用 ControlNet,不需要你拥有一块好显卡。缺点就是你得能上去。

¸在 PC 上安装 ControlNet

1、安装最新 AUTOMATIC1111 webui,再装 ControlNet 扩展。

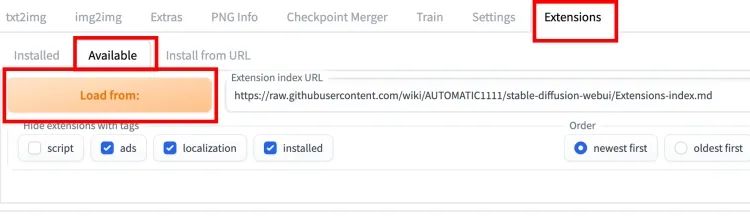

要安装 ControlNet 扩展,请转至扩展选项卡并选择可用子选项卡。按加载自按钮。

在新出现的列表中,找到扩展名为 sd-webui-controlnet 的行,点安装。

这种方式不行的话就选 Install from URL:

https://github.com/Mikubill/sd-webui-controlnet

装好以后重新启动 AUTOMATIC1111 webui。

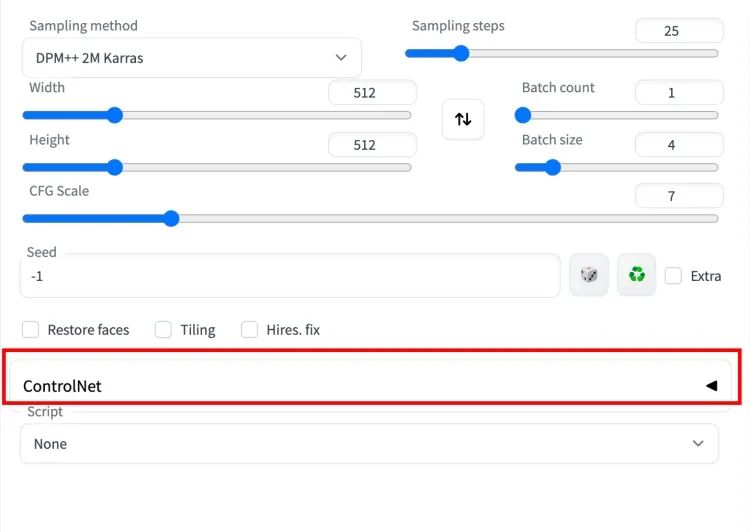

如果扩展安装成功,你将在 txt2img 选项卡中看到一个名为 ControlNet 的新可折叠部分,它应该位于脚本下拉菜单的顶部。

2、安装 ControlNet 模型

ControlNet 的作者发布了一些预训练的 ControlNet 模型。它们可以在此页面[7]中找到。

要使用这些模型,请下载模型文件并将它们放在扩展的模型文件夹中。模型文件夹的路径是

stable-diffusion-webui/extensions/sd-webui-controlnet/models

不需要所有模型,可以只下载 openpose 模型[8]。

4使用 ControlNet

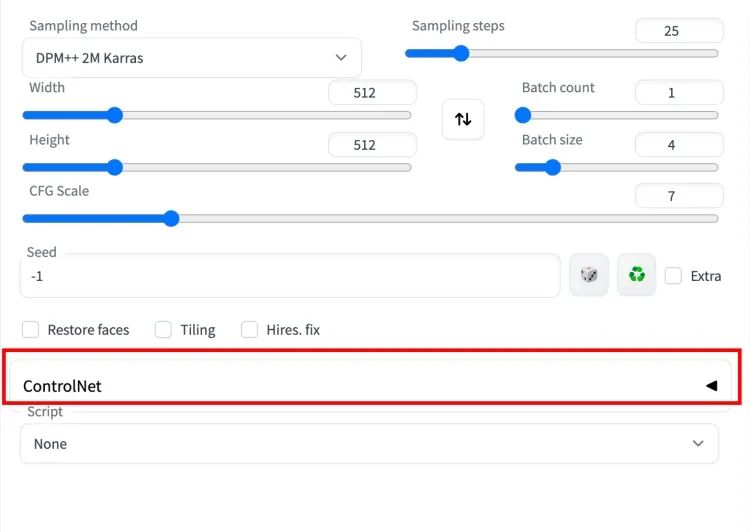

现在应该已经安装 ControlNet 扩展,你可以通过如下查看来验证。

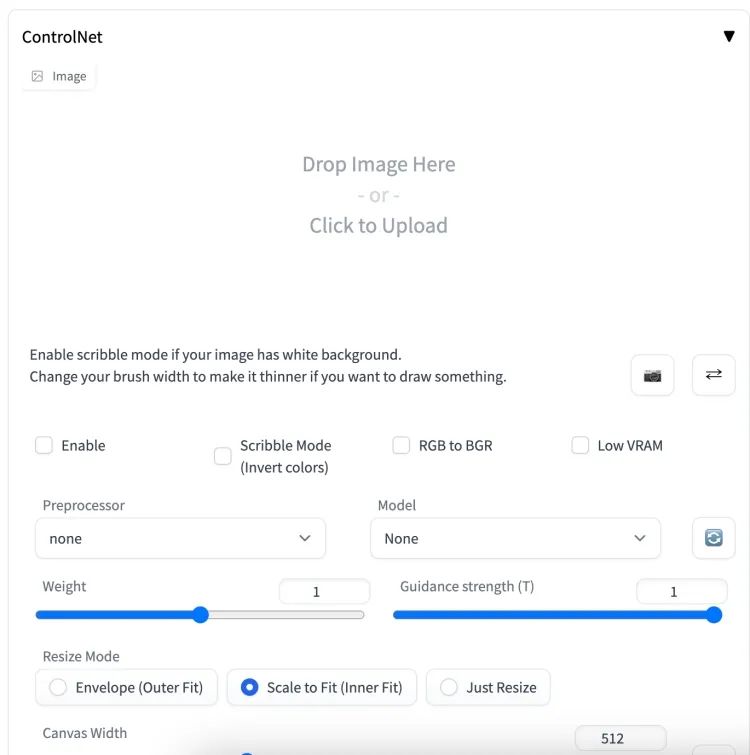

按右侧的插入符号以展开 ControlNet 面板。它显示了控制旋钮的完整部分和图像上传画布。

我将使用下图向你展示如何使用 ControlNet。

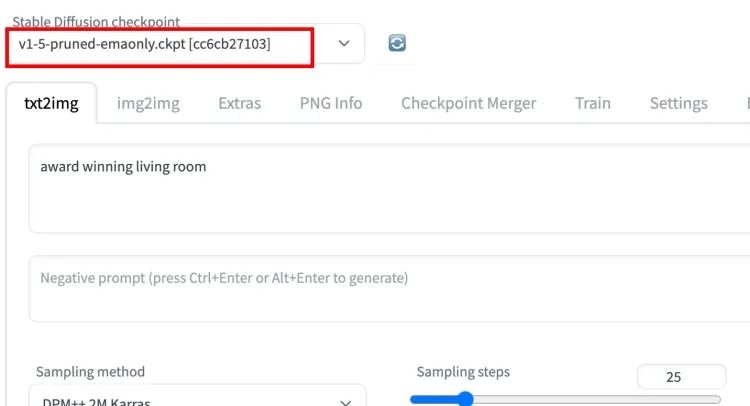

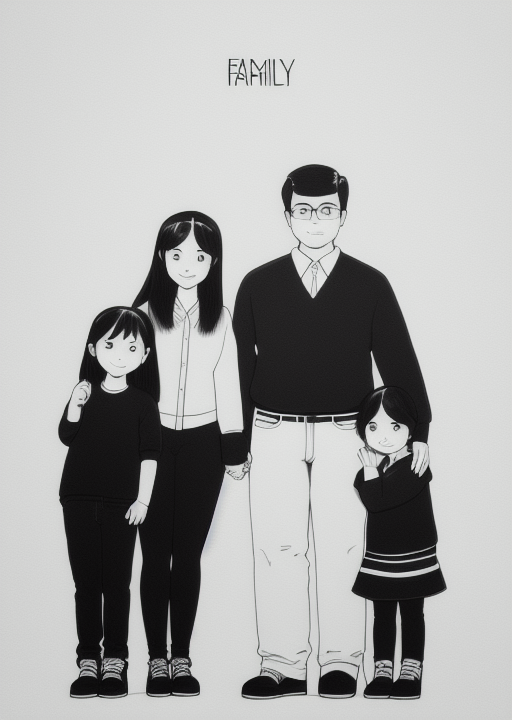

¸txt2img 设置

ControlNet 需要与 Stable Diffusion 模型一起使用。在 Stable Diffusion 检查点下拉菜单中,选择要与 ControlNet 一起使用的模型。比如选择 v1-5-pruned-emaonly.ckpt 使用 v1.5 模型。

在 txt2image 选项卡中,编写提示和可选的否定提示以供 ControlNet 使用。

设置图像生成的**图像大小。**我将使用宽度 512 和高度 776。请注意,图像大小是在 text2img 部分中设置的,而不是在 ControlNet 部分中设置的。

GUI 应该如下所示。

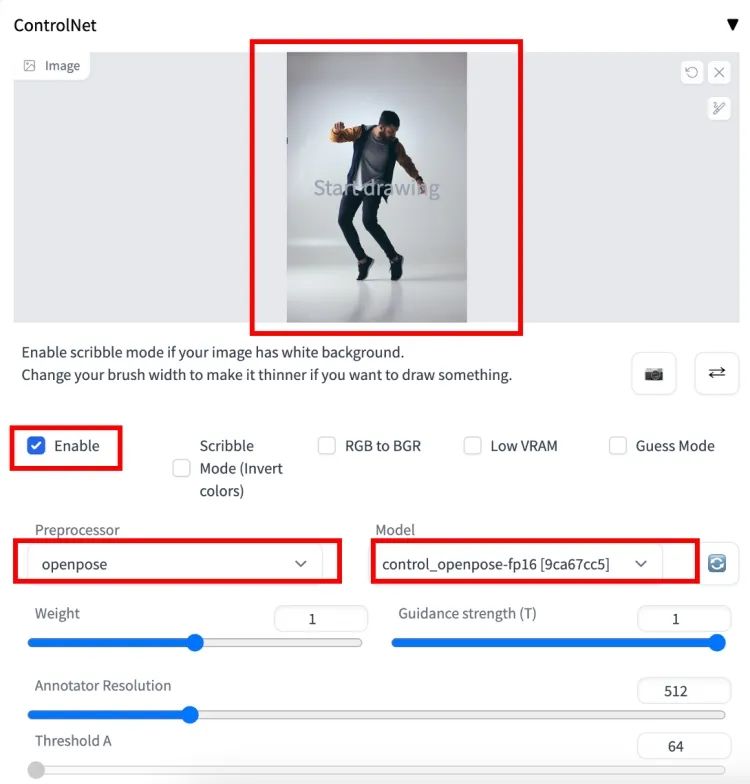

¸ControlNet 设置

现在我将讨论你需要在 ControlNet 面板中执行的操作。首先将图像上传到图像画布,选中启用复选框。

你需要选择预处理器和模型。Preprocessor 就是我们前面讲的 annotator,让我们选择 openpose 作为 Preprocessor。

所选的 ControlNet 模型必须与预处理器一致。对于 OpenPose,我们应该选择 control_openpose-fp16 作为模型。

ControlNet 面板应如下所示。

这就是我们需要设置的全部。现在按生成开始使用 ControlNet 生成图像。

你应该看到生成的图像遵循输入图像的姿势。最后一张图像直接来自预处理步骤。在这种情况下,它是检测到的关键点。

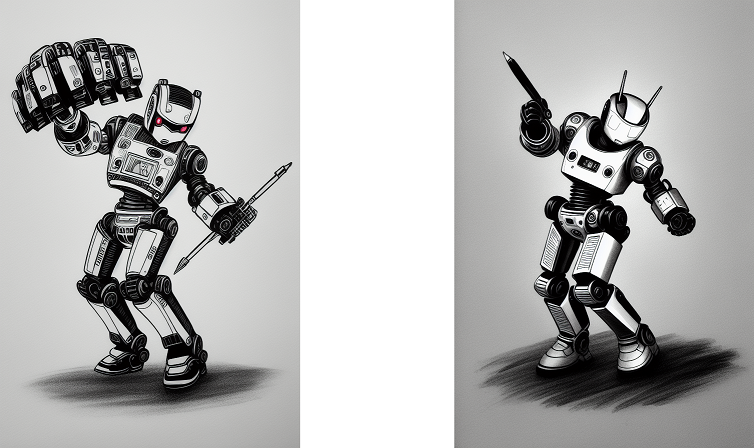

在提示(prompt)那里写上:robot, dancing。

我们来欣赏一下机器人的优美舞姿。

先可以直接提供关键点图像,让它引导生成想要的姿势。

比如上面的骨骼将生成类似下面的图像。

总体还可以,不过仔细看会发现细节上还是有些问题的。

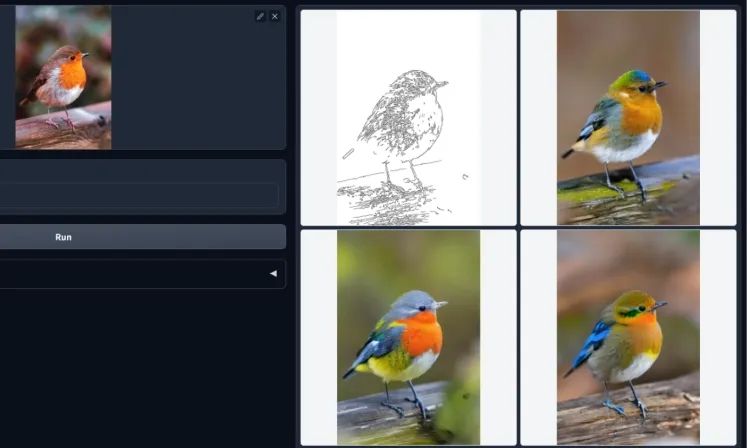

下面改用 Canny 边缘控制图,对比一下效果。

看大图,

下面是边缘图,

好了,对于 ControlNet 就把玩到这里了。相信大家已经领略到它的威力了,更多功能有待你去试探哦。

关于AI绘画技术储备

学好 AI绘画 不论是就业还是做副业赚钱都不错,但要学会 AI绘画 还是要有一个学习规划。最后大家分享一份全套的 AI绘画 学习资料,给那些想学习 AI绘画 的小伙伴们一点帮助!

对于0基础小白入门:

如果你是零基础小白,想快速入门AI绘画是可以考虑的。

一方面是学习时间相对较短,学习内容更全面更集中。

二方面是可以找到适合自己的学习方案

包括:stable diffusion安装包、stable diffusion0基础入门全套PDF,视频学习教程。带你从零基础系统性的学好AI绘画!

零基础AI绘画学习资源介绍

👉stable diffusion新手0基础入门PDF👈

👉AI绘画必备工具👈

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉AI绘画基础+速成+进阶使用教程👈

观看零基础学习视频,看视频学习是最快捷也是最有效果的方式,跟着视频中老师的思路,从基础到深入,还是很容易入门的。

温馨提示:篇幅有限,已打包文件夹,获取方式在:文末

👉12000+AI关键词大合集👈

这份完整版的AI绘画全套学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

魔乐社区(Modelers.cn) 是一个中立、公益的人工智能社区,提供人工智能工具、模型、数据的托管、展示与应用协同服务,为人工智能开发及爱好者搭建开放的学习交流平台。社区通过理事会方式运作,由全产业链共同建设、共同运营、共同享有,推动国产AI生态繁荣发展。

更多推荐

已为社区贡献8条内容

已为社区贡献8条内容

所有评论(0)